¿Hacia dónde va la Inteligencia de Negocios?

mayo 1, 2020

Cinco tendencias que están marcando la evolución de la Analítica y el Business Intelligence

Las empresas que atraviesan un proceso de transformación digital adoptan en prácticamente todos los casos nuevas tecnologías que las ayudan a avanzar y agilizar procesos. Entre ellas hay en muchos casos una o varias ramas de la Inteligencia Artificial. Como la Analítica o el Business Intelligence, dos piezas de gran importancia para que las empresas consigan extraer información útil y valiosa de los datos que manejan y puedan aplicarla en sus procesos. Tanto, que según Gartner, muchos directivos y empresas centradas en lo digital han convertido a ambas tecnologías en dos de sus principales prioridades de inversión.

Estas dos tecnologías, al igual que el resto de ramas de la Inteligencia Artificial, avanzan de manera constante, para lo que se apoyan en diversas tendencias que dan forma a su evolución. De ellas, las cinco más punteras en la actualidad son las siguientes:

1 – Analítica aumentada

La analítica aumentada emplea el machine learning para automatizar la preparación de datos, el descubrimiento de información, la ciencia de datos, el desarrollo de modelos de machine learning y la compartición de información para un amplio rango de usuarios profesionales, trabajadores y científicos de datos «civiles».

A medida que vaya madurando, la analítica aumentada se convertirá en una función clave de las plataformas de analítica moderna. Proporcionará análisis a cualquier miembro de una empresa en menos tiempo, y también con menos requisitos para los usuarios con experiencia, y con menos sesgo interpretativo que los enfoques manuales actuales.

2 – Cultura digital

El desarrollo de una cultura digital eficaz puede ser el primer y más importante paso en una empresa de cara a abordar sus procesos de transformación digital. Cualquier organización que intenta obtener valor de sus datos y está en pleno proceso de transformación digital debe centrarse en el desarrollo de una formación en datos. Según los analistas de Gartner, la formación de datos tendrá impacto en todos los empleados, ya que se convertirá no solo en una habilidad de empresa, sino en una que será crítica para la vida.

En relación con esto, la preocupación por el peso cada vez mayor de la Inteligencia Artificial y la sociedad digital, pero también de las fake news, tanto las organizaciones como los gobiernos están interesándose cada vez más por la ética digital.

Los líderes en datos y analítica deberían patrocinar debates sobre ética digital para asegurarse de que la información y la tecnología se usan de manera ética para conseguir y mantener la confianza de empleados, clientes y socios. Y parece que, según Gartner, es cada vez más importante. Así, según sus datos, para 2023, el 60% de organizaciones con más de 20 científicos de datos necesitarán un código de conducta profesional que incorpore un uso ético de los datos y la analítica.

3 – Analítica de las relaciones

La emergencia de la analítica de relaciones pone de manifiesto el uso creciente de los grafos, la ubicación y las técnicas de analítica social, con el objetivo de comprender cómo están conectadas las distintas entidades de interés, como la gente, los lugares y las cosas.

El análisis de datos desestructurados y cambiantes puede proporcionar a los usuarios información y contexto en una red, y datos más exhaustivos que mejoren la precisión de las predicciones y la toma de decisiones.

4 – Inteligencia de decisión

Los líderes en datos y analítica trabajan con grandes cantidades de datos de ecosistemas que están en evolución constante. Por lo tanto necesitan utilizar una multitud de técnicas para gestionar los datos de forma eficaz.

Lo impredecible de los modelos de decisión actuales viene a menudo de una incapacidad para capturar de manera adecuada o tener en cuenta ciertos factores de incertidumbre relacionada con el comportamiento de modelos en un contexto de empresa. La inteligencia de decisión proporciona un framework que aúna técnicas tradicionales y avanzadas para diseñar, modelar, alinear, ejecutar, controlar y afinar modelos de decisión.

5 – Operatividad y escalado

La cantidad de casos de uso en el núcleo de una empresa, en sus áreas relacionadas y más allá es ingente. Cada vez más más gente que quiere interactuar con los datos, y cada vez más interacciones y procesos necesitan analítica para la automatización y el escalado.

Los servicios de analítica y los algoritmos se activan cada vez con más frecuencia cuándo y donde se necesitan. Ya sea para justificar el siguiente gran paso estratégico o para optimizar millones de transacciones, las herramientas de analítica y los datos que las alimentan están en espacios en los que hasta ahora era raro encontrarlos.

Fuente: muycomputerpro.com, 2019

___________________________________________________________________

Analítica de grafos: El valor de las relaciones

Con los avances en Big Data y Machine Learning en los últimos años, el análisis y modelado de datos se está convirtiendo en algo cada vez más importante, convirtiendo el rol de Data Scientist en un perfil cada vez más relevante y solicitado.

Pero, ¿qué tiene que ver esto con la analítica de grafos?

Los grafos son una estructura de datos que aporta mucho valor tanto en áreas científicas y de investigación (biología, sociología, etc), como en áreas de negocio (estudios de mercado, detección de fraude, etc), permitiendo modelar la información visualmente de una forma mucho más “real”.

Por esta razón, la analítica de grafos se ha convertido en una habilidad más que todo analista de datos debería aprender.

¿Cómo realizar un análisis?

Aunque visualmente un grafo pequeño es fácil de entender, la volumetría de los datos y la complejidad de las propiedades y de las relaciones puede dificultar mucho su interpretación. Por esta razón, es importante definir qué es lo que se quiere medir o analizar y utilizar la metodología y los algoritmos correctos para obtener conclusiones.

Dentro de la teoría de grafos, en función de lo que se pretenda obtener, se pueden realizar los siguientes tipos de análisis:

- Path analysis: analiza las características de las rutas entre dos nodos, por ejemplo, para conocer la distancia mínima que hay entre ellos. Existen muchos casos de uso dónde este análisis es muy útil, uno de los más comunes sería utilizarlo para conocer los pasos que ha realizado un usuario desde que accede a una web hasta que compra un producto, pero también se utiliza para temas más complejos, como analizar patrones de comportamiento que llevan a una persona a cometer un fraude.

- Connectivity analysis: se utiliza para comprobar la “fuerza” de las relaciones, permitiendo detectar relaciones débiles o vulnerables entre dos nodos. Un caso de uso para este tipo de análisis sería detectar cuellos de botella en la comunicación dentro de una red de ordenadores.

- Community analysis: este método de análisis se basa en la distancia y densidad del grafo para detectar comunidades de nodos, de forma que cada comunidad contenga nodos con características comunes o similares.

- Centrality analysis: permite conocer la relevancia que tienen los nodos dentro del grafo, es decir, analiza la influencia que tiene un nodo. El ejemplo más común sería detectar las páginas web más visitadas, sin embargo, tiene usos más atractivos como detectar las personas más influyentes en las redes sociales.

La centralidad dentro de un grafo se puede calcular en función de distintas medidas. La siguiente imagen muestra los resultados de centralidad utilizando diferentes medidas sobre el mismo grafo:

- Subgraph isomorphism: analiza el grafo para obtener patrones estructurales dentro del mismo, permitiendo averiguar qué patrones son los más repetidos. La detección de patrones es un método muy utilizado para la detección de fraude.

- Graph Embedding: se trata de una técnica que permite interpretar los nodos como vectores y así poder entrenar y ejecutar modelos predictivos de Machine Learning sobre el grafo. Por lo general, el uso de modelos ML sobre grafos es complicado debido a la forma en la que están estructurados los datos, sin embargo, técnicas como Graph Embedding facilitan su uso al transformar las estructuras de nodos en vectores.

La analítica de grafos es una rama dentro del análisis de datos que permite visualizar la información de forma más clara, y que se está utilizando en numerosas disciplinas, como detección de fraude, marketing, investigación, etc. a fin de revelar rasgos y tendencias ocultos en los datos. Por esta razón, se está convirtiendo en una habilidad muy cotizada en personas con perfil de analista.

La analítica de grafos basada en proyectos Big Data y complementada con tecnología como Machine Learning y Deep Learning proporciona a los analistas un mapa del comportamiento facilitando y simplificando los procesos de investigación.

___________________________________________________________________

Luchando contra el fraude: “El roadmap de la detección”

Hace unas semanas tuve la oportunidad de participar como ponente en el “III Foro Anual de Gestión de Siniestros y Fraude” organizado por INESE en la que pude explicar cómo la analítica de grafos puede ayudar en la detección de fraude aportando nuevas perspectivas de análisis. Veremos cómo las compañías aseguradoras pueden emprender el “roadmap de la detección” desde la tramitación manual a la analítica de grafos pasando por la implementación de algoritmos de Machine Learning. Estas son las fases del “Roadmap de la detección”:

Matrices de fraude o automatización de reglas de negocio

La mayor parte de las compañías disponen de una identificación clara de las reglas de negocio que determinan el riesgo de un determinado siniestro en función de la experiencia de negocio adquirida en los últimos años.

De esta forma, las compañías determinan el riesgo de un siniestro en base a las condiciones establecidas en el producto contratado (periodos de carencia, exclusiones, etc…) o bien, en función de la experiencia ganada con siniestros sospechosos en el pasado, identificando una serie de reglas que permiten obtener un indicador de riesgo en base al cumplimiento de dichas reglas.

Algunas compañías han pasado de la identificación de las reglas de negocio o matriz de fraude, a una automatización de la misma basada en productos de mercado o bien, en una implementación ad-hoc para sus sistemas de tramitación de siniestros.

- La automatización de la matriz de fraude aporta una serie de ventajas:

- Permite que el modo de tramitación de todo el departamento se base en las mismas reglas evitando la interpretación subjetiva de las reglas.

- Evita el pago de siniestros que no cumplen con las condiciones del producto o sus exclusiones de un modo automático.

- Aporta un nivel de riesgo de fraude a aquellos siniestros que cumplen con unas características que han sido determinadas en base a la experiencia de la compañía o a la experiencia global del sector.

Las matrices de fraude son un elemento altamente eficaz, de hecho la mayor parte de las compañías dispone de mecanismos de automatización de las mismas. Sin embargo, el volumen de información que disponen las compañías está creciendo exponencialmente y por lo tanto deberíamos ser capaces de responder a la siguiente pregunta: ¿Existen otros datos distintos a los tratados en la matriz que pueden determinar el riesgo de un siniestro? Para poder responder a esta pregunta, necesitamos entrar en el siguiente paso del roadmap (hoja de ruta):

Machine Learning

Si bien las técnicas de machine learning existen de manera previa a la irrupción del Big Data, es cierto que esta nueva tendencia permite que estas técnicas sean más eficaces gracias a la capacidad que disponemos para usar la totalidad de los datos para el entrenamiento de los modelos en lugar de muestreos más pequeños.

Teniendo en cuenta esta premisa, es fácil imaginar oportunidades de mejora en la automatización de la matriz de fraude si además de contar con la información proveniente de los sistemas de tramitación, pudiéramos mezclar esa información con la información que proviene de los centros de atención al usuario, correos electrónicos, la historia del cliente en la compañía y otros elementos.

Disponer de la capacidad de mezclar toda esta información aporta unas ventajas claras a la hora de determinar el riesgo de fraude de un determinado siniestro, sin embargo, hay que tener en cuenta multitud de aspectos esenciales para tener éxito en este tipo de aproximaciones:

- ¿Dispongo de la suficiente calidad en la información de mis sistemas?

- ¿Puedo mejorar dicha calidad de un modo automatizado?

- ¿Cómo puedo acceder a la información de todos los sistemas sin alterar su rutina de funcionamiento?

- ¿Cómo seleccionamos las variables más relevantes?

- ¿Cómo se aborda un proyecto de Machine Learning?

- ¿Cómo reduzco el número de falsos positivos?

Aunque intentaré responder a estas preguntas en posteriores artículos, lo que podemos determinar es que la aplicación de las técnicas de Machine Learning aportan de nuevo una serie de ventajas adicionales:

- Aumenta el rango de búsqueda de los siniestros con riesgo de fraude: La selección de nuevas variables puede determinar nuevos condicionantes hasta ahora desconocidos.

- Automatiza la identificación del riesgo a partir de la aplicación de estos modelos.

- Aporta un nuevo indicador de fraude en base a la predicción del riesgo a través de dichos modelos.

- Permite la no repetición de fraude que hayamos detectado en el pasado.

- Puede reducir el número de falsos positivos de las matrices de fraude.

Esta serie de ventajas pueden aportar una gran diferencia con respecto a la automatización de la matriz de fraude y suponen un gran retorno de inversión para aquellas compañías aseguradoras que invierten en el desarrollo de estos sistemas de detección.

Hasta este momento de la “Hoja de Ruta de la detección” hemos conseguido minimizar el riesgo de reaparición de fraudes para los que tenemos indicios en el histórico de la compañía, sin embargo, ¿Podemos acercarnos un paso adicional en la detección del fraude que nunca hemos detectado en la compañía o que no tenemos consciencia de él? Las siguientes etapas nos permiten acercarnos a la resolución de esta pregunta.

Enriquecimiento de la información

Uno de los aspectos fundamentales para encontrar nuevos indicios de riesgo de fraude es disponer de otros elementos de información distintos a los que disponemos en nuestras organizaciones que puedan enriquecer la información que disponemos de nuestros clientes o del propio siniestro, para ello existen varias catalogaciones de las fuentes de información:

Redes Sociales e Internet: La sociedad ha cambiado de manera radical en los últimos años hacia la digitalización. El uso de redes sociales y blogs, entre otros es una constante en casi todos los rangos de edad poblacionales, lo que supone una gran oportunidad para las compañías si son capaces de recoger parte de esa información para enriquecer sus propios datos.

Fuentes públicas: En los últimos años se han desarrollado multitud de fuentes de libre disposición y que permiten enriquecer la información de nuestra compañía con múltiples indicadores como pueden ser valores socio económicos, valores meteorológicos, geopolíticos, etcétera. Estas fuentes de libre disposición vienen determinadas por las corrientes Open Data que se han ido desarrollando en los últimos años por los gobiernos de todo el mundo; de hecho, España es líder europeo en la puesta a disposición de los ciudadanos de multitud de fuentes de información para el desarrollo de diferentes modelos de negocio.

Fuentes privadas: Existen multitud de recursos que pueden adquirirse a través de diferentes asociaciones o empresas para enriquecer la información de nuestros clientes con un posible riesgo crediticio, patrón de comportamiento, etc. Estas fuentes de información permiten a las compañías enriquecer su información a través de acuerdos interempresa.

Si bien la disposición de estas fuentes de información para enriquecer nuestros datos puede ser un elemento diferencial en la detección de fraude, disponer de esta información no está exento de múltiples cuestiones a considerar:

- ¿Es viable disponer de esta información sin vulnerar la LOPD (Ley Orgánica de Protección de Datos de Carácter Personal)?

- ¿Cuál es la fiabilidad de cada una de las fuentes de información?

- ¿Qué trabajo es necesario para normalizar esta información externa e integrarla en los procesos de tramitación de mi compañía?

- ¿Qué beneficio real me aporta la incorporación de esta fuente?

Analítica de grafos

Uno de los enfoques más creativos a la hora de luchar contra el fraude o determinar el riesgo de un determinado cliente u operación, es conseguir analizar la información desde múltiples perspectivas. En este sentido, la Analítica de Grafos nos permite enfocar la detección de fraude desde un punto de vista completamente distinto al habitual, el enfoque de las relaciones.

Como hemos visto en los anteriores puntos, la mayor parte de las técnicas utilizadas consiste en analizar los datos desde el punto de vista del valor de dichos datos, sin embargo, la Analítica de Grafos nos permite modelar la información desde el punto de vista de cómo se interrelaciona la información. Este nuevo enfoque nos permite identificar nuevos indicios de fraude basándonos en cómo nuestros clientes, nuestros siniestros, nuestros datos, se interrelacionan entre sí.

La Analítica de Grafos o SNA (Social Network Analysis) es una técnica que nos permite modelar cualquier realidad en una red formada por nodos y relaciones como podemos ver en la siguiente figura:

Esta aproximación nos permite acelerar los tiempos de investigación de cada caso, basándonos en que los tramitadores o analistas no tienen que imaginarse un mapa mental del siniestro sino que dichas técnicas nos aportan un enfoque completamente visual de la información.

De otro modo, la Analítica de Grafos aplicada a los datos de una compañía aseguradora nos permite conocer el comportamiento de nuestros clientes en cada uno de los siniestros de la compañía y así identificar nuevos indicios como elementos en común entre diferentes siniestros, aparición de redes organizadas de fraude, detección de secuencias temporales o patrones geográficos. Es decir, dado que el fraude lo cometen personas, utilicemos un modelado de información que nos permita “ver” como se interrelacionan dichas personas.

Pero la Analítica de Grafos no es sólo un modo de visualización o modelado, sino que nos permite la aplicación de diferentes técnicas y algoritmos matemáticos que nos

permiten inferir patrones de comportamiento en el conjunto de nuestros clientes o anomalías que se encuentran en nuestros datos de un modo automatizado.

En mi opinión, la detección de fraude o la determinación del riesgo de un determinado perfil es una tarea realmente compleja y no existen los sistemas infalibles. Sin embargo, la utilización de la Analítica de Grafos junto con el Machine Learning y el enriquecimiento de la información aporta un elemento diferenciador en la lucha contra el fraude y puede generar importantes beneficios para una compañía que decida emprender dicho camino.

Fuente: bites.futurespace.es, 15/11/17.

Más información:

La Inteligencia y sus especialidades en la Sociedad del conocimiento

___________________________________________________________________

.

.

El Tablero de Control en una estrategia de marketing

mayo 1, 2020

El Dashboard en una estrategia de marketing

Por Tristán Elósegui.

[En este artículo se analiza el caso de uso de Dashboards en marketing, esto puede generalizarse a muchas otras áreas en empresas y organizaciones.]

Al hablar de Dashboards o Tableros de Control, inmediatamente pensamos en Analítica digital. Es inevitable, pensamos en datos, Google Analytics,… y si eres un poco más técnico, piensas en etiquetados, Google Tag Manager (GTM), integración de fuentes, Google Data Studio, etc.

Pero en realidad, pienso que deberíamos darle la vuelta al enfoque. Por definición, la Analítica digital es una herramienta de negocio. Representa los ojos y oídos de la estrategia de marketing, y por tanto se debe definir desde el negocio y no desde el departamento de Analítica (con su ayuda, pero no liderado por ellos).

Para explicarlo, os dejo una resumen de mí ponencia en el primer congreso de marketing digital celebrado en Pontevedra (Congreso Flúor).

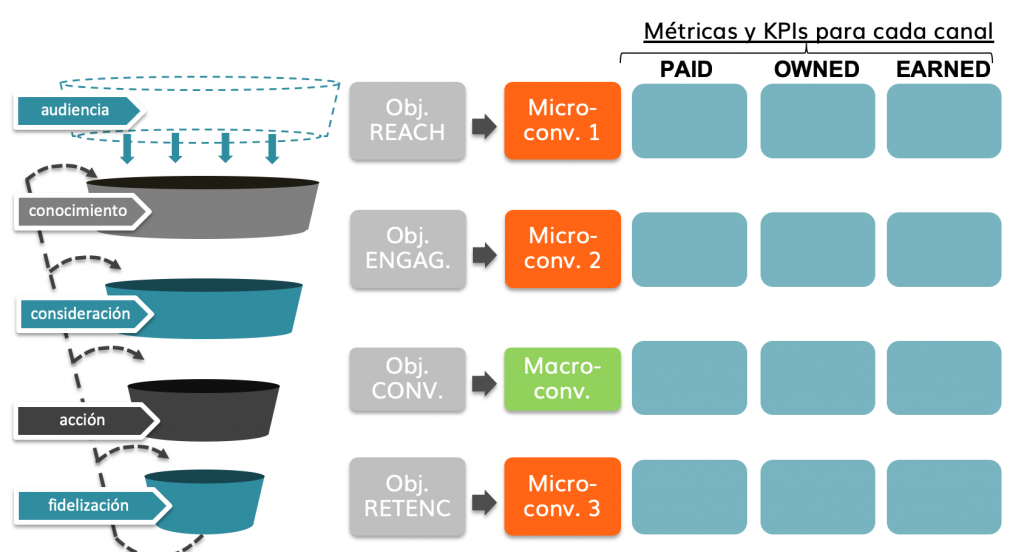

Para definir correctamente un dashboard, debemos partir de la estrategia de marketing y seleccionar las fuentes de datos y métricas que mejor la representen. Las que mejor nos describan el contexto de nuestra actividad de marketing, y nos permitan tomar las mejores decisiones.

Para entender el papel de un dashboard en una estrategia vamos a ver cinco puntos:

- ¿Qué es un dashboard?

- ¿Cómo se define un cuadro de mando?

- Caso práctico real.

- Consejos para aportar valor con un dashboard de marketing.

- Ejemplos de dashboard.

Pero, empecemos la historia por el principio.

¿Qué es un dashboard?

Me gusta enfocar la definición de dashboard, de dos maneras, mejor dicho de una manera que concluye en la clave de todo:

Es una representación gráfica de las principales métricas de negocio (KPI), y su objetivo es propiciar la toma de decisiones para optimizar la estrategia de la empresa.

Un dashboard de indicadores debe transformar los datos en información y estos en conocimiento para el negocio.

[Obsérvese la similitud con la definición de Inteligencia.]

Esta transformación de los datos nos debe llevar a una mejor Toma de decisiones. Este es el objetivo principal que no debemos perder de vista. Algo que suele pasar con cierta frecuencia en este proceso. Nos centramos tanto en el proceso de creación del Tablero de Control, que tendemos a olvidar que su objetivo es la toma de decisiones y no la acumulación de datos. Pero esta es otra historia.

A todo esto tenemos que añadir un elemento más, ya que la base para la toma de decisiones está en un buen análisis de los datos.

[No debe confundirse el concepto de Tablero de Control (Dashboard) con el de Cuadro de Mando Integral (Balanced Scorecard).]

¿Qué necesitamos para hacer un buen análisis de un dashboard de control?

Pues fundamentalmente dos cosas:

- Visión estratégica de negocio.

- Pilares del análisis de datos.

Visión estratégica de negocio:

- Correcta definición de los objetivos de marketing y de negocio: es lo que nos va a marcar el camino a seguir, lo que va a definir el éxito de nuestro marketing.

- Definición de la macro y micro conversiones: debemos traducir nuestras metas a hechos objetivos medibles en nuestra web, y además ser capaces de asignarlos a cada una de las etapas del proceso de compra de nuestra audiencia.

- Conocer el contexto: en nuestros resultados incluyen muchas variables: mercado, competencia, regulaciones, etc. En ocasiones son tantas, que dejamos de mirar. Pero un buen punto de arranque para entender los porqués de gran parte de las variaciones en los datos, está en la estrategia de marketing y sus acciones planificadas.

Pilares del análisis de datos:

- Personal cualificado: debemos ser capaces de vencer la tentación de pensar que una herramienta de medición nos va a solucionar el problema. La clave del buen análisis está en las personas que lo realizan. Son las que realizan la transformación de los datos en información y esta en conocimiento para la empresa.

Para tenerlo claras las proporciones, se estima que de cada 100 € invertidos en medición, 90 deben ir a personas y 10 a herramientas. - Calidad del dato: nos tenemos que asegurar de que lo datos que estamos analizando se acercan lo máximo a la realidad. Digo lo máximo, porque es normal que en algunas métricas veamos variaciones entre los datos que nos da la herramienta de analítica y los sistemas internos.

Además de tener la tranquilidad de que estamos usando los datos correctos para tomar decisiones, vamos a eliminar las discusiones internas sobre cuál es el dato real y cual no. - Tablero de Control (Dashboard):

- Definición: selección de KPIs y métricas.

- Implementación técnica: configuración de la herramienta de medición, y etiquetado (web y acciones).

- Integración de fuentes en herramienta de cuadro de mandos.

- Definición de la visualización más adecuada.

- Informes y herramientas de análisis adicionales: necesarios para complementar los diferentes niveles de análisis necesarios.

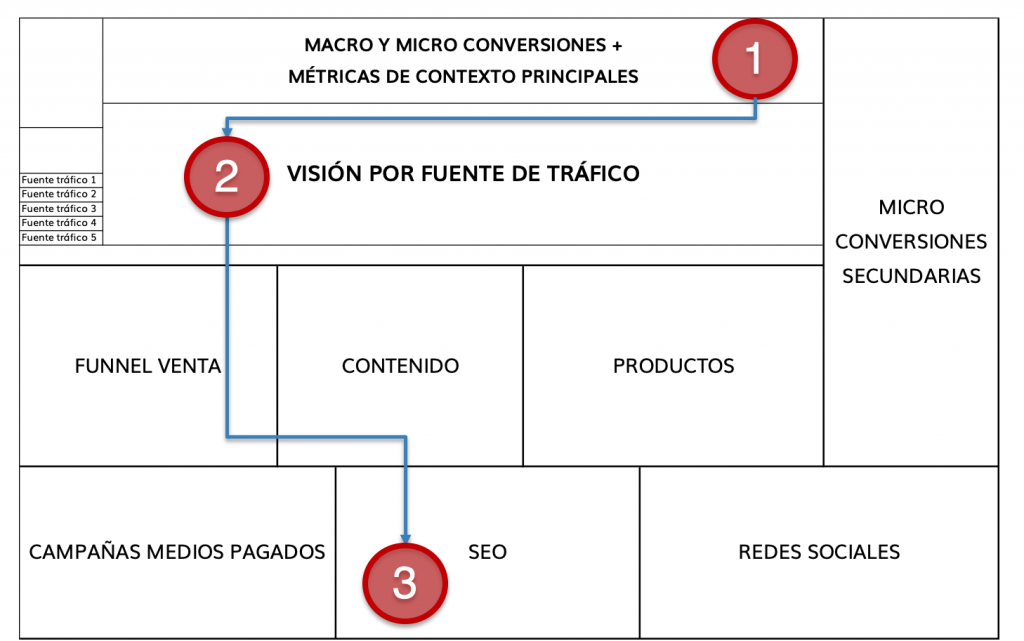

Para realizar un análisis correcto de un dashboard debemos ir de lo global a los específico

El dashboard de métricas debe contar una historia. Nos debe enseñar el camino desde los principales indicadores, a la explicación de la variación del dato.

Además este cuadro de mando no debe contar con más de 10 KPIs (aproximadamente), primero porque no debería haber más y segundo, porque nos complicamos el análisis.

- Objetivos y KPIs de la estrategia.

- Métricas contextuales.

- Fuentes de datos que necesitaremos para componer el dashboard.

- Siguiente paso: seleccionar el tipo de dashboard más adecuado.

Y por último, aconsejo que el Tablero de Control sea una foto fija de la realidad. Existen herramientas de dashboard que permiten profundizar en el análisis y cruzar variables, pero las desaconsejo (al menos en una primera fase). ¿por qué? El tener estas posibilidades nos llevará a invertir tiempo en darle vueltas a los datos, y nos alejará de la toma de decisiones (objetivo principal de todo cuadro de mando).

Un buen dashboard comercial o de marketing es como un semáforo: Nos muestra las luces rojas, amarillas y verdes de nuestra actividad y las decisiones a tomar .

¿Cómo se define un Tablero de Control de marketing?

Para hacerlo debemos partir del planteamiento de nuestra estrategia (ya que es lo que queremos controlar). Cómo ya adelantaba al hablar de las claves de un buen análisis, tenemos que tener muy claros varios puntos:

- Objetivos por etapa del embudo de conversión (purchase funnel).

- Macro y microconversiones: traducción de estos objetivos a métricas que podamos medir en nuestra página web.

- Métricas de contexto, que nos ayudan a entender la aportación de los medios pagados, propios y ganados a la consecución de los objetivos de cada etapa del embudo de marketing.

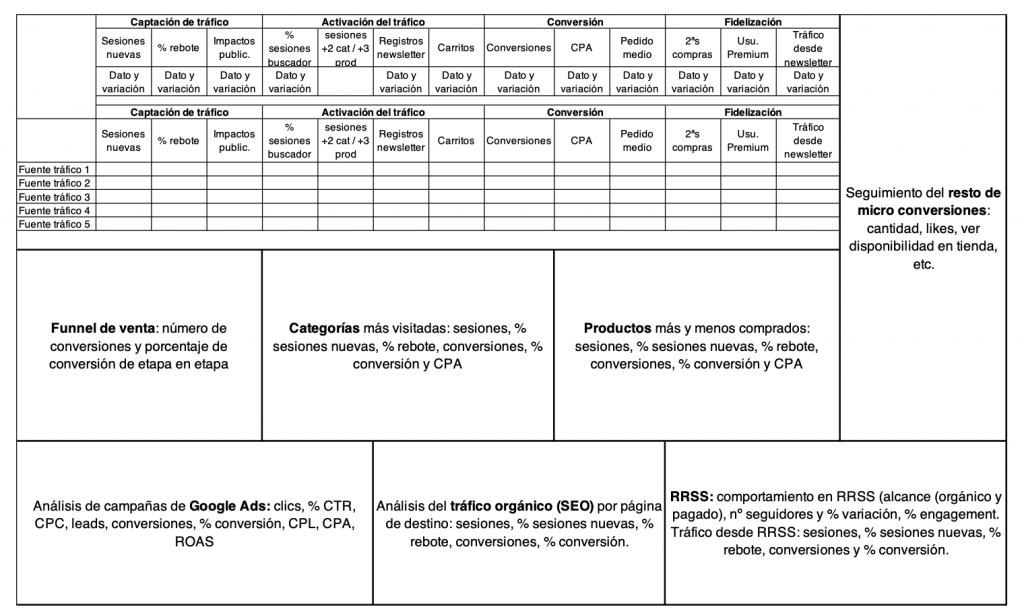

La imagen que os dejo a continuación, os ayudará a estructurar mejor la información y sobre todo a no olvidar métricas importantes.

Definición de macro y micro conversiones – Tristán Elósegui

.

¿Qué tenemos hasta el momento?

- Objetivos y KPIs de la estrategia.

- Métricas contextuales.

- Fuentes de datos que necesitaremos para componer el dashboard.

- Siguiente paso: seleccionar el tipo de dashboard más adecuado.

Con esta información ya podemos hacer la selección de las métricas y definir nuestro dashboard de indicadores en formato borrador.

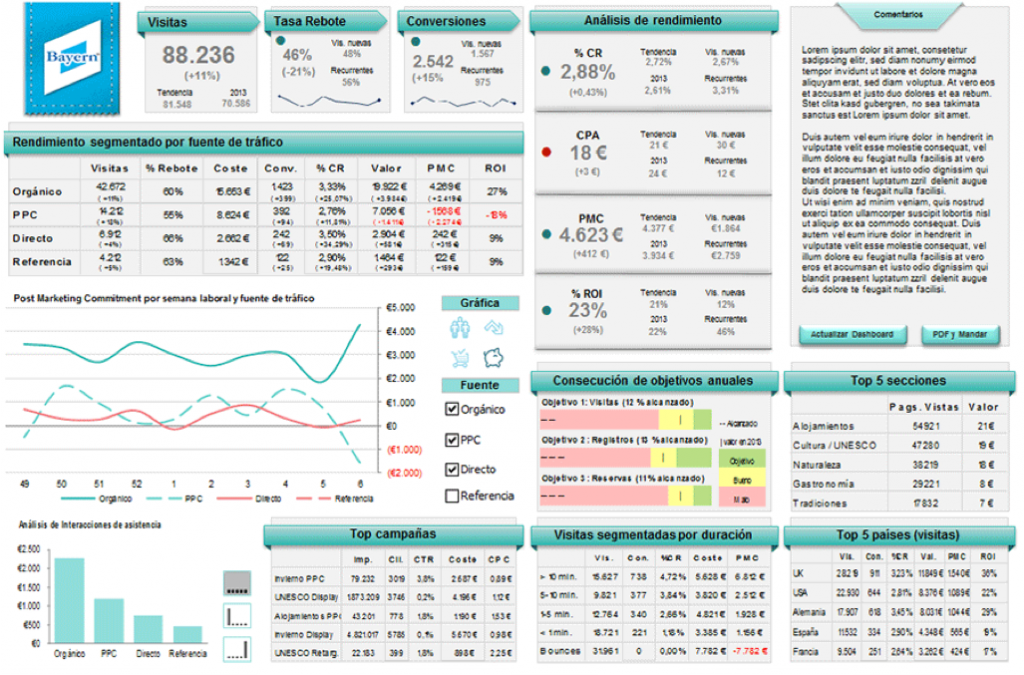

Borrador Dashboard de marketing – Tristán Elósegui

.

Cómo veis en este ejemplo de dashboard, podemos hacer un seguimiento desde el origen de la variación en las KPI principales, hasta el canal o campaña que las causó. Es decir, hemos definido un cuadro de mando que nos cuenta la “historia” de lo que ha ocurrido en el periodo analizado.

Caso práctico real (PCcomponentes.com):

El proceso real es algo más complejo, pero voy a simplificarlo para facilitar la lectura y comprensión.

NOTA: No tengo relación alguna con PCcomponentes.com, por lo que todo lo que vais a ver a continuación son supuestos que realizo para poder explicaros la definición de un Dashboard de indicadores.

Siguiendo la metodología que os acabo de explicar tendríamos que definir:

- Objetivos: para definir el cuadro de mando vamos a partir de una serie de objetivos por etapa que me he inventado.

- Macro y microconversiones: para definirlas para este ejemplo, vamos a hacerlo por medio de un análisis de las llamadas a la acción de la web. Una vez detectadas las más importantes, vamos a ordenarlas por etapa (normalmente lo haríamos analizando que llamadas a la acción han intervenido en las conversiones obtenidas, pero obviamente no tengo acceso de los datos).

- Representación de estas métricas en nuestro borrador de dashboard de métricas.

A continuación os dejo: el pantallazo de una página de producto, la definición de macro y microconversiones y el borrador de dashboard de control.

PCcomponentes página producto

.

Caso real PCcomponentes – Objetivos y métricas para Dashboard de marketing

.

Propuesta de Dashboard de marketing para PCcomponentes – Tristán Elósegui

Consejos para aportar valor con un Dashboard de marketing

Suponiendo que hemos cumplido con todo lo dicho hasta ahora en la parte estratégica y técnica, mis principales consejos son:

- Visualización correcta: el tablero de control tiene que ser perfectamente entendible por la persona que lo va a analizar y su cliente (ya sea interno o externo).

Recuerda que no se trata de hacer cosas bonitas o espectaculares (aunque ayuden a hacerlo más fácil), si no de tomar decisiones. Por lo tanto, esta debe ser nuestra prioridad. - Correcta selección métricas: además de acertar con las métricas que mejor describen la actividad de marketing, debemos pensar en nuestro cliente ¿qué le interesa? ¿qué métrica reporta a su jefe?

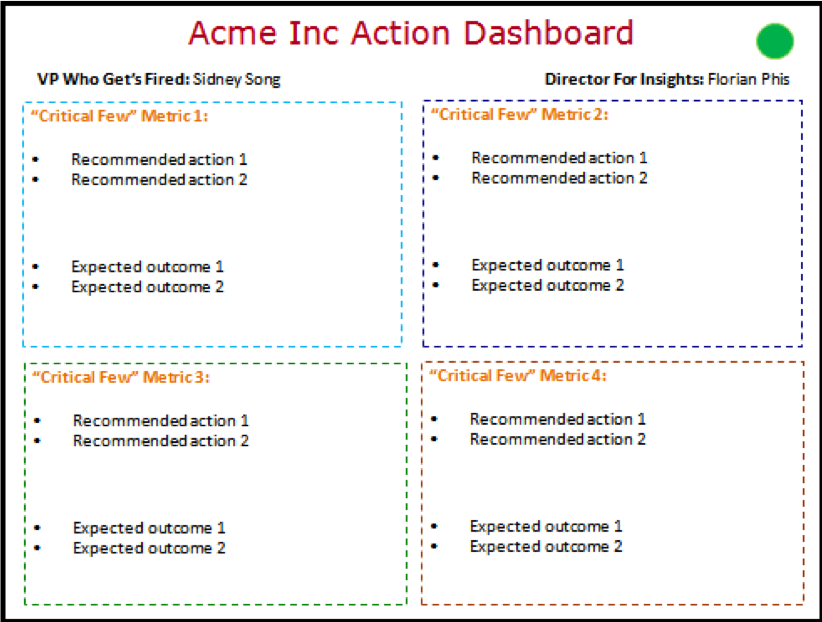

Es la mejor forma de fidelizarle y provocar que cada semana o mes, lo primero que haga sea abrir el dashboard comercial o de marketing que acaba de recibir. - Analiza, no describas: el análisis es lo más importante del cuadro de mando. Describir los datos que estás viendo no aporta valor alguno. Para hacerlo, debes hablar de cuatro cosas:

- ¿Qué ha pasado?

- ¿Por qué ha pasado?

- Recomendaciones basadas en datos.

- Resultados esperados de poner en práctica tus recomendaciones.

Ejemplos de dashboard

Para terminar el artículo, os dejo con varios ejemplos de varios tipos de cuadros de mando.

Avinash Kaushik dashboard para gerencia de empresa

.

Agustín Suárez – Dashboard de Marketing

.

Fuente: tristanelosegui.com, 2019.

___________________________________________________________________

Vincúlese a nuestras Redes Sociales:

LinkedIn YouTube Facebook Twitter

___________________________________________________________________

.

.