Tendencias de Inteligencia de Negocios para 2018

julio 23, 2018 · Imprimir este artículo

El ritmo y la evolución de las soluciones de inteligencia de negocios implican que lo que hoy funciona podría requerir ciertas modificaciones el día de mañana. Entrevistamos a clientes y a miembros del personal de Tableau para identificar las 10 tendencias que están teniendo mayor impacto y de las cuales se hablará en 2018, desde el procesamiento del lenguaje natural hasta el crecimiento del aseguramiento de los datos. Ya sea una superestrella de los datos, un héroe de TI o un ejecutivo que crea su propio imperio de BI, estas tendencias destacan las prioridades estratégicas que podrían ayudar a llevar a su organización a un nivel superior.

1. No le tema a la inteligencia artificial

Cómo el aprendizaje automático mejorará el trabajo del analista

La cultura popular alimenta una concepción distópica del poder del aprendizaje automático. Sin embargo, mientras la investigación y la tecnología continúan mejorando, este se convierte rápidamente en un valioso complemento para el analista. De hecho, es el mejor asistente que cualquier analista podría tener.

Imagine que se necesita consultar de manera rápida el impacto de la modificación de un precio en cierto producto. Para ello, podríamos ejecutar una regresión lineal de los datos. Antes de la existencia de Excel, R o Tableau, eso debía hacerse de forma manual, lo que llevaba horas. Gracias al aprendizaje automático, ahora puede visualizarse el consumo del producto en cuestión de minutos, o incluso segundos. Como analista, no tiene la necesidad de hacer el trabajo arduo y puede pasar a la siguiente pregunta: ¿los meses de alto consumo fueron el resultado de un factor extrínseco, como un día festivo? ¿Hubo algún nuevo lanzamiento? ¿Hubo noticias en los medios de comunicación que influyeron sobre las compras o el conocimiento del producto? Ya no es necesario preocuparse por si se pasó el tiempo suficiente perfeccionando el modelo de regresión.

El aprendizaje automático permite explorar muchas posibilidades cuando uno necesita ayuda para encontrar una respuesta.

Hay dos maneras en que el aprendizaje automático ayuda al analista. En primer lugar, aumenta su eficiencia. En el ejemplo anterior, el analista no pierde un tiempo valioso en hacer cálculos matemáticos básicos. Ahora el analista tiene más tiempo para pensar en cuáles son las implicaciones de su negocio y los siguientes pasos lógicos. En segundo lugar, ayuda al analista a explorar y mantenerse en el flujo del análisis de datos, porque ya no debe detenerse para hacer cálculos. En cambio, el analista se dedica a hacer la siguiente pregunta. Según Ryan Atallah, ingeniero de software de Tableau: “El aprendizaje automático permite explorar muchas posibilidades cuando uno necesita ayuda para encontrar una respuesta”.

La capacidad del aprendizaje automático para ayudar a un analista es innegable. No obstante, debe adoptarse cuando los resultados estén claramente definidos. “El aprendizaje automático no funciona especialmente bien con datos subjetivos”, afirma Andrew Vigneault, administrador de productos de Tableau. Por ejemplo, en una encuesta de satisfacción del cliente con respecto a ciertos productos, el aprendizaje automático no siempre reconoce las palabras cualitativas.

Además, el analista debe comprender las métricas de éxito de los datos para poder actuar en consecuencia. En otras palabras, lo que se introduce en una máquina no produce resultados con un significado claro. Solo un ser humano es capaz de comprender si se cuenta con suficiente contexto. Por lo tanto, el aprendizaje automático no puede aplicarse de manera aislada (sin comprender el modelo que se usa, las entradas y los resultados que se obtienen).

Es posible que los analistas teman ser reemplazados, pero realmente, el aprendizaje automático potenciará su trabajo y les permitirá ser más eficientes y precisos, y tener un mayor impacto sobre los negocios. En vez de temer a esta tecnología, aproveche las oportunidades que le ofrece.

IDC prevé ingresos derivados de los sistemas de inteligencia artificial y aprendizaje automático por un total de USD 46 000 millones para 2020.

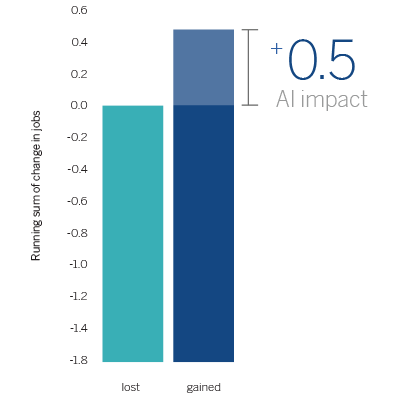

En 2020, la inteligencia artificial se convertirá en uno de los motores de la creación de empleo neto, ya que creará 2,3 millones de puestos de trabajo, pero eliminará solo 1,8 millones. (Gartner)

2. El impacto de las humanidades

El impacto de las humanidades en el sector del análisis

El sector del análisis continúa buscando personas capacitadas para trabajar con datos, y las organizaciones desean fortalecer sus equipos de análisis. Es posible que hayamos tenido una plétora de talento al alcance de nuestras manos. Sabemos que las humanidades y la narración de historias han influido sobre el sector del análisis de datos. No es ninguna sorpresa. Lo que sí sorprende es que los usuarios con conocimientos sobre el arte de contar historias (que suelen provenir de las humanidades) se están apoderando de los aspectos técnicos de la creación de dashboards analíticos. Antes, esos aspectos estaban reservados para los profesionales de TI y los usuarios avanzados. Además, las organizaciones ya no se limitan a contratar personas con conocimientos analíticos. Ahora, dan mayor importancia a quienes son capaces de usar los datos y la información para promover cambios y propiciar la transformación mediante el arte y la persuasión.

A medida que se simplifica el uso de las plataformas tecnológicas, disminuye el interés en las especialidades técnicas. Cualquiera puede jugar con los datos sin necesidad de disponer de los avanzados conocimientos técnicos que se requerían anteriormente. Ahora, entran en escena las personas con conocimientos más amplios, incluso procedentes de las humanidades. Estas generan un impacto en los sectores y las organizaciones donde escasea el personal que trabaje con datos. Cada vez más organizaciones priorizan el análisis de datos en sus negocios. En este contexto, los administradores de datos que provienen de las humanidades ayudarán a las empresas a descubrir que, si capacitan a su personal, obtendrán una mayor ventaja competitiva.

Advertimos un gran interés en la contratación de una nueva generación del personal que trabaja con datos. También detectamos varios casos de empresas de tecnología dirigidas o influenciadas por líderes capacitados en humanidades. Entre esos líderes se incluyen fundadores y ejecutivos de Slack, LinkedIn, PayPal, Pinterest y otras empresas de tecnología de alto rendimiento.

Crear un dashboard y realizar análisis requiere cierta habilidad, pero es algo que no se puede enseñar. Realmente consiste en contar una historia con los datos.

En el libro de Scott Hartley, “The Fuzzy and the Techie”, puede encontrarse un ejemplo interesante de la incorporación de las humanidades a una empresa eminentemente tecnológica. Nissan contrató a Melissa Cefkin, doctora en antropología, para liderar su investigación sobre la interacción entre las máquinas y las personas. Específicamente, Cefkin estudió la interacción entre los automóviles que se conducen solos y los seres humanos. La tecnología en la que se basa ese tipo de vehículos avanzó mucho. Sin embargo, aún debe hacer frente a dificultades en los entornos mixtos donde los seres humanos cohabitan con las máquinas. Por ejemplo, en un cruce con señales de tráfico de “stop” (o “pare”) en las cuatro direcciones, los seres humanos analizan cada una de las posibles situaciones. Eso es casi imposible de enseñar a una máquina. A fin de contrarrestar esa situación, se le pidió a Cefkin que aplicara sus conocimientos sobre antropología para identificar patrones de comportamiento humano. Esos comportamientos se enseñarían a los automóviles que se manejan solos y, a su vez, se comunicarían a las personas que viajan en ellos.

En su evolución, el análisis dejó de ser puramente científico para hacerse más humanístico. El enfoque pasó de la comunicación de datos a la narración de historias basadas en ellos para así facilitar la toma de decisiones. Las organizaciones usan datos más que nunca y, lógicamente, dan más importancia a su preparación y a las historias que estos transmiten. Llegó la era dorada de la narración de historias con datos. Seguro que en su organización hay un gran contador de historias ávido de hacer su próximo gran descubrimiento.

Los graduados del área de humanidades se están uniendo a la fuerza laboral tecnológica con una velocidad un 10 % mayor que los graduados de áreas técnicas. (LinkedIn)

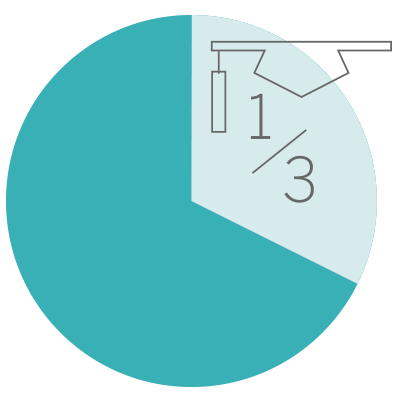

Un tercio de los directores ejecutivos de las empresas de Fortune 500 se graduaron en el área de humanidades. (Fast Company)

3. La promesa del procesamiento del lenguaje natural

La promesa del procesamiento del lenguaje natural

En 2018, el procesamiento del lenguaje natural (NLP) será más prevalente, sofisticado y ubicuo. Los desarrolladores y los ingenieros continuarán ampliando sus conocimientos sobre el procesamiento del lenguaje natural, que se integrará en nuevos sectores. La creciente popularidad de Amazon Alexa, Google Home y Microsoft Cortana alimentó las expectativas de las personas con respecto a hablarle al software y que este las comprenda. Por ejemplo, puede dar la orden “Alexa, reproduce ‘Yellow Submarine’”, y el clásico de los Beatles se escuchará en su cocina mientras prepara la cena. Este concepto también se aplica a los datos. Así, cualquiera puede hacer preguntas y análisis con mayor facilidad.

Según Gartner, hacia el año 2020, el 50 % de las consultas analíticas se generará mediante búsqueda, procesamiento del lenguaje natural o voz. En consecuencia, será mucho más sencillo para el director ejecutivo que esté fuera de la oficina pedirle información rápida a su dispositivo móvil. Por ejemplo, “total de ventas por cliente que compró grapas en Nueva York”. Luego, puede filtrar los resultados por “pedidos realizados en los últimos 30 días” y, después, agrupar por “departamento del responsable del proyecto”. Además, el director de la escuela de sus hijos podría preguntar: “¿cuál fue la calificación promedio de los estudiantes este año?”, filtrarla por los “estudiantes de 8.º”, y agruparla por “materia del profesor”. El procesamiento del lenguaje natural permitirá a las personas hacer distintos tipos de preguntas sobre los datos y recibir respuestas relevantes. Así obtendrán mejor información y podrán tomar decisiones más acertadas.

El procesamiento del lenguaje natural puede abrirle los ojos al analista y darle cierta confianza en lo que es capaz de hacer.

Al mismo tiempo, los desarrolladores y los ingenieros harán grandes progresos que les permitirán descubrir y comprender cómo las personas usan el procesamiento del lenguaje natural. Evaluarán qué tipos de preguntas hacen las personas. Tal vez buscan una satisfacción inmediata (“¿Qué producto tuvo más ventas?”) o prefieren explorar (“No sé qué me pueden decir los datos. ¿Cómo le va a mi departamento?”). Ryan Atallah, ingeniero de software de Tableau, explica: “Este comportamiento depende en gran medida del contexto en el que se hace la pregunta”. Si el usuario final usa un dispositivo móvil, es más probable que haga una pregunta que genere una satisfacción inmediata. En cambio, si está en su despacho observando un dashboard, es probable que desee explorar y hacer preguntas más profundas.

Se obtendrán mayores beneficios analíticos si se comprenden los distintos flujos de trabajo que el procesamiento del lenguaje natural puede mejorar. Vidya Setlur, ingeniera de software de Tableau, afirma: “La ambigüedad es un problema grave”. Por lo tanto, la comprensión de los flujos de trabajo es más importante que la formulación de una pregunta específica. Cuando existen distintas maneras de hacer la misma pregunta (por ejemplo, “¿Qué vendedor logró más ventas este trimestre?” o “¿Quién logró más ventas este trimestre?”), el usuario final no quiere pensar en la forma “correcta” de formularla. Solo quiere la respuesta.

Por ello, no será necesario contar con el procesamiento del lenguaje natural en todas las situaciones. Las oportunidades surgirán cuando esté disponible en los flujos de trabajo adecuados y su uso resulte familiar.

Para 2019, el 75 % de los trabajadores cuyas tareas diarias implican el uso de aplicaciones empresariales tendrán acceso a asistentes personales inteligentes que les permitirán aumentar sus capacidades y conocimientos. (IDC)

Para 2021, más del 50 % de las empresas gastarán más al año en la creación de robots (incluidos los “chatbots”) que en el desarrollo de aplicaciones móviles tradicionales. (Gartner)

4. El debate sobre la multiplicidad de nubes

El debate sobre la multiplicidad de nubes continúa

Si su organización está considerando y evaluando una estrategia de varias nubes para el año 2018, no es la única.

“Las organizaciones que trasladan sus datos y aplicaciones a la nube lo están haciendo en estampida”, comenta François Ajenstat, director de productos. “Tanto si realizan un simple traslado o si hacen un cambio de plataforma, los clientes están adoptando la nube más rápido que nunca”.

Según un estudio reciente de Gartner, “el 70 % de las empresas elegirá una estrategia de varias nubes hacia 2019, a diferencia del 10 % actual”. Los clientes rechazan cada vez más la idea de limitarse a una única solución de software heredada que pueda no ajustarse a sus necesidades futuras. No obstante, los cambios y las migraciones son ahora relativamente más fáciles con API similares y estándares abiertos, como Linux, Postgres, MySQL y otros.

Probablemente, su organización también esté evaluando cómo se diseñan y dirigen los centros de datos. Su departamento de TI está evaluando entornos de hospedaje sobre la base del riesgo, la complejidad, la velocidad y el costo. Son factores que aumentan la dificultad a la hora de encontrar una única solución para todas las necesidades de su organización.

Evaluar e implementar un entorno de varias nubes puede ayudarlo a determinar quién proporciona el mayor rendimiento y la mayor compatibilidad para su situación específica. Según el Boston Herald, GE modificó su estrategia de hospedaje en la nube para usar Microsoft Azure y Amazon Web Services. Su objetivo era identificar el entorno de hospedaje en la nube de mayor rendimiento y descubrir qué contrato le permitía trasladar el menor costo posible a sus clientes.

Esta estrategia multinube o híbrida está adquiriendo cada vez más relevancia para ayudar a reducir el riesgo, y proporcionar más opciones y flexibilidad a los clientes.

No obstante, es necesario conocer a fondo las ventajas y las desventajas de adoptar este tipo de entorno de varias nubes. Aunque se gana en flexibilidad, el uso de varias nubes aumenta los gastos generales debido a la división de la carga de trabajo de su organización entre distintos proveedores. Además, el equipo de desarrolladores internos se ve obligado a conocer distintas plataformas e implementar procesos de gobernanza adicionales, según los diferentes entornos que se deban admitir.

Asimismo, una estrategia de varias nubes podría reducir el poder adquisitivo de su empresa u organización. Si una empresa divide sus compras entre varios proveedores, se reducirá el número de descuentos por volumen que estos le ofrezcan. Así, se creará un modelo en que la empresa comprará menos a un mayor precio.

Las encuestas y las estadísticas, como el estudio de Gartner antes mencionado, indican que la adopción de la estrategia de varias nubes va en aumento. Sin embargo, no revelan cuánto se adoptó de cada plataforma. En muchos casos en los que se usan varias nubes, las organizaciones satisfacen la mayor parte de sus necesidades con los servicios de un proveedor y una parte muy inferior con los del resto. Sin embargo, en la mayoría de las organizaciones, se implementa un segundo entorno de hospedaje en la nube a modo de respaldo en caso de que el principal entorno no funcione o presente errores.

La adopción de varias nubes aumentará en 2018. Aun así, las organizaciones deberán tomarse la molestia de evaluar si su estrategia mide el volumen de adopción de cada plataforma de nube, el uso interno, las demandas de carga de trabajo y los costos de implementación.

El 70 % de las empresas implementará una estrategia de varias nubes para 2019. (Gartner)

El 74 % de los directores financieros de tecnología afirman que la informática en la nube tendrá el mayor impacto cuantificable en el negocio en 2017. (Forbes)

5. El auge del director de datos

El auge del director de datos

Los datos y el análisis se están convirtiendo en elementos fundamentales de todas las organizaciones. Eso es indiscutible. A medida que las organizaciones evolucionan, priorizan una mayor atención estratégica y responsabilidad en relación con el análisis.

Históricamente, el director de tecnologías de la información (CIO) era responsable de la mayoría de las tareas de inteligencia de negocios (BI). Este profesional supervisaba la estandarización, la consolidación y la gobernanza de los activos de datos de toda la organización, lo cual requería de informes coherentes. En consecuencia, las iniciativas de BI (la gobernanza de datos, el diseño de modelos de análisis, etc.) competían con otras iniciativas estratégicas (como la arquitectura de TI, la seguridad de los sistemas o las estrategias de redes) por captar la atención del CIO. Con frecuencia, eso limitaba el éxito y el impacto de la BI.

En algunos casos, se generaron dificultades entre el CIO y la empresa debido a la falta de sincronía entre la velocidad con que se obtiene la información, la seguridad y la gobernanza de los datos. Por lo tanto, cada vez más organizaciones reconocen la necesidad de que la dirección ejecutiva se haga responsable de la creación de una cultura de análisis. Esta debe permitir obtener información útil a partir de los datos gracias a las inversiones en análisis. Para esas organizaciones, la clave consiste en designar a un director de datos (CDO) o un director de análisis (CAO). Este profesional debe modificar los procesos empresariales, superar los obstáculos culturales y comunicar el valor del análisis en toda la organización. Así, el CIO podrá concentrar su atención estratégica en otros asuntos, como la seguridad de los datos.

Mi trabajo consiste en introducir herramientas y tecnologías para ayudar al equipo a avanzar.

El hecho de que se designen CDO o CAO y que estos tengan responsabilidad sobre el impacto de los negocios y la mejora de los resultados demuestra, además, el valor estratégico de los datos y del análisis en las organizaciones modernas. Hoy en día, la dirección ejecutiva debate de manera proactiva cómo implementar una estrategia de análisis. En vez de esperar solicitudes de informes específicos, los CDO se preguntan: “¿Cómo podemos anticiparnos o adaptarnos rápidamente a las necesidades de la empresa?”.

Las organizaciones están destinando más dinero y recursos a la conformación de un equipo de gran eficacia para cubrir estos puestos de nivel directivo. Según Gartner, el 80 % de las grandes empresas tendrá una oficina de dirección de datos completamente operativa en 2020. En la actualidad, el número promedio de empleados en esa oficina es de 38. Sin embargo, el 66 % de las organizaciones encuestadas espera que el presupuesto asignado a dicha oficina aumente.

Josh Parenteau, director de inteligencia de mercado de Tableau, advierte que la actividad del CDO “se centra en los resultados”. Parenteau afirma: “No se trata solo de colocar datos en un almacén y esperar a que alguien los use. El CDO debe definir el uso de los datos y asegurarse de que estos aporten valor”. Concentrarse en los resultados es fundamental, especialmente porque concuerda con los tres objetivos principales identificados en la encuesta sobre CDO que realizó Gartner en 2016. Estos profesionales desean incrementar la privacidad del cliente, la ventaja competitiva y la eficacia. Esos objetivos motivan a distintas empresas, como Wells Fargo, IBM, Aetna y Ancestry, a designar puestos de CDO para perfeccionar su estrategia de datos. En consecuencia, la función del director de datos será esencial para el negocio en 2018.

En 2019, el 90 % de las grandes empresas tendrá un director de datos. (Gartner)

En 2020, el 50 % de las organizaciones principales tendrá un director de datos con niveles de autoridad e influencia en las estrategias similares a los del director de TI.

6. Participación colectiva en la gobernanza

El futuro de la gobernanza de datos es la participación colectiva

La inteligencia de negocios moderna pasó de restringir datos y contenido a capacitar a los usuarios corporativos en todo el mundo. Estos usuarios saben que deben trabajar con datos gobernados y confiables para obtener información. A medida que las personas aprenden a usar los datos en diferentes situaciones, su contribución a la optimización de los modelos de gobernanza ha otorgado una fuerza colosal a las organizaciones.

Nos quedamos cortos al decir que el análisis de autoservicio revolucionó el mundo de la inteligencia de negocios. El paradigma cambió totalmente. Ahora, cualquier persona puede diseñar análisis que permitan hacer y responder preguntas críticas a todos los miembros de su organización. La misma revolución se está produciendo con la gobernanza. Gracias a la expansión del análisis de autoservicio, una gran variedad de información y perspectivas comienza a inspirar métodos nuevos e innovadores para implementar la gobernanza.

La gobernanza consiste en aplicar la sabiduría colectiva para proporcionar los datos correctos a las personas adecuadas y, al mismo tiempo, evitar accesos indebidos.

La gobernanza consiste en aplicar la sabiduría colectiva para proporcionar los datos correctos a las personas adecuadas y, al mismo tiempo, evitar accesos indebidos.

Los usuarios corporativos no desean responsabilizarse de la seguridad de los datos. Las políticas de gobernanza óptimas les permiten hacer o responder preguntas y, a su vez, encontrar los datos que necesitan en el momento oportuno.

Las estrategias de BI y de análisis incluirán el modelo de gobernanza moderno. Los departamentos de TI y los ingenieros de datos seleccionarán, ajustarán y prepararán fuentes confiables. Además, dado que el autoservicio es la tendencia dominante, los usuarios tendrán libertad para explorar datos seguros y confiables. Los procesos verticales controlados por el departamento de TI serán reemplazados por un proceso de desarrollo colaborativo que combina el talento de los profesionales de TI con el de los usuarios finales. Todos ellos identificarán los datos más importantes para gobernar y crearán reglas y procesos que maximicen el valor empresarial del análisis sin renunciar a la seguridad.

El 45 % de los ciudadanos de los datos afirma que menos de la mitad de sus informes contienen datos de buena calidad. (Collibra)

El 61 % de los directivos afirma que la toma de decisiones en sus empresas rara vez está impulsada por los datos. (PwC)

7. El aseguramiento de datos

La vulnerabilidad propicia un mayor aseguramiento de los datos

Para muchas empresas, los datos son activos fundamentales. Pero ¿cómo se mide el valor de esos datos? ¿Qué sucede si se pierden o si alguien los roba? Como hemos visto en los casos de grandes filtraciones de datos recientemente, una amenaza para los datos de una compañía puede ser devastadora y causar daños irreparables a la marca.

Según un estudio de 2017 realizado por el Ponemon Institute, se calcula que el costo total promedio de una filtración de datos es de USD 3,62 millones.

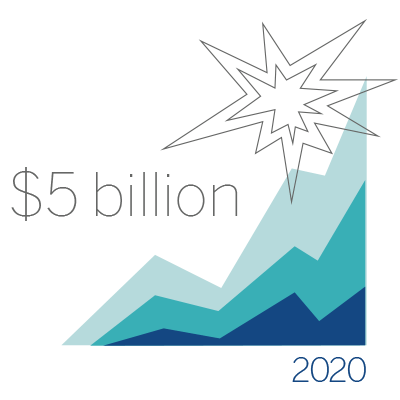

Sin embargo, ¿hacen las empresas todo lo posible para proteger y asegurar sus datos? El mercado de los seguros informáticos es un sector que crece con rapidez como consecuencia de las filtraciones de datos. Este sector experimentó un crecimiento año tras año del 30 %, y se espera que sus primas brutas emitidas en el año 2020 alcancen los USD 5600 millones. (AON)

Los seguros informáticos y de privacidad cubren las responsabilidades de una empresa ante una filtración de datos en la que un pirata informático robe o divulgue la información personal de sus clientes.

Sin embargo, incluso ante el crecimiento del mercado y la amenaza continua de filtraciones de datos, solo el 15 % de las empresas estadounidenses cuenta con una póliza de seguros que cubra dichas filtraciones y otros problemas de ciberseguridad. Además, la mayor parte de ese 15 % de empresas cubiertas está constituida por grandes instituciones financieras consolidadas.

Debemos decidir cuál es el punto débil. ¿Cuál es el verdadero riesgo para su empresa?

Claramente, las instituciones financieras necesitan este tipo de pólizas. Sin embargo, la necesidad llegará a otros mercados verticales porque nadie es inmune a las amenazas de las filtraciones de datos.

Recientemente, Doug Laney, analista de Gartner, escribió un libro titulado “Infonomics: How to Monetize, Manage, and Measure Information for Competitive Advantage”. En él presenta distintos modelos (financieros y no financieros) con los que las empresas de cualquier sector pueden calcular el valor de sus datos.

Los modelos no financieros se centran en el valor intrínseco, el valor de negocio y el valor de rendimiento de los datos. Con estos valores, se puede medir la singularidad, la precisión, la relevancia, la eficacia interna y el impacto general del uso que la empresa da a esos datos.

Los modelos financieros se centran en el valor del costo, el valor económico y el valor de mercado de los datos. Con estos valores, se puede medir el costo de adquirir datos y administrarlos de manera interna, así como el valor de venderlos o de otorgarlos bajo licencia.

El hecho de considerar los datos como un producto implica que su valor aumentará. Además, se originarán nuevas preguntas y conversaciones acerca de cómo esta materia prima ayuda a las empresas a conseguir mayores éxitos y ventajas. Al igual que cualquier producto, ¿de qué sirven si pueden robarse sin consecuencias?

El costo total promedio estimado de las filtraciones de datos es de USD 3,62 millones. (Ponemon)

Solo el 15 % de las empresas estadounidenses cuenta con una póliza de seguros para proteger específicamente sus datos. (Ponemon)

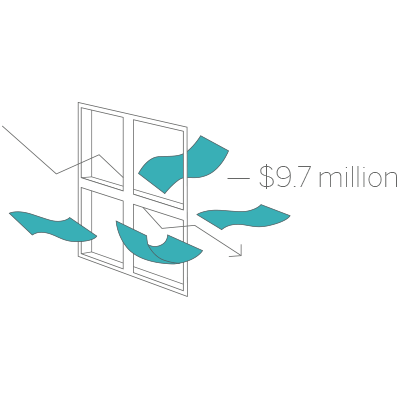

8. La función del ingeniero de datos

Mayor prominencia de la función del ingeniero de datos

Una cosa es cierta: nadie puede crear un dashboard sin los gráficos necesarios para comprender la historia que intenta comunicar. Otro principio que quizá conozca afirma que no se puede tener una fuente de datos confiable sin haber comprendido qué datos se introducen en el sistema y cómo sacarlos de allí.

En cualquier organización, los ingenieros de datos seguirán siendo fundamentales para promover el uso de datos y tomar mejores decisiones de negocios. Entre 2013 y 2015, el número de esos ingenieros creció más del doble. Y, en octubre de 2017, había más de 2500 puestos vacantes con las palabras “ingeniero de datos” en el título en LinkedIn, lo que indica el nivel de crecimiento en la demanda de esta especialidad.

Los ingenieros de datos desempeñan un papel fundamental a la hora de hacer posible el autoservicio en una plataforma de análisis moderno.

¿En qué consiste esta función y por qué es tan importante? El ingeniero de datos es responsable de diseñar, crear y administrar las bases de datos operativas y de análisis de la empresa. En otras palabras, es responsable de extraer datos de los sistemas básicos de la empresa de manera que estos puedan usarse y aprovecharse para obtener información y tomar decisiones. El volumen de datos y la capacidad de almacenamiento van en aumento. Por lo tanto, cada vez es más importante contar con alguien que tenga amplios conocimientos técnicos de los distintos sistemas y arquitecturas, y que sea capaz de comprender los intereses y las necesidades de la empresa.

La función del ingeniero de datos requiere un conjunto de conocimientos muy particular. Tiene que comprender el back-end, qué contienen los datos y de qué manera pueden ser de utilidad para el usuario corporativo. El ingeniero de datos también tiene que desarrollar soluciones técnicas para que los datos puedan utilizarse.

Michael Ashe, reclutador sénior de Tableau, explica: “No soy ningún novato. Me dedico a la contratación de profesionales técnicos desde hace más de 17 años. No me sorprende que los datos y la capacidad de almacenamiento hayan crecido. Fui testigo de su salto de gigante. Los datos siempre necesitarán ajustes. Las empresas deben incorporar a profesionales capaces de realizar esos ajustes, ya que necesitan explorar datos específicos para tomar decisiones de negocios. Sin duda, la función del ingeniero de datos continuará creciendo”.

En un estudio realizado por Gartner en 2016, se llegó a la conclusión de que las organizaciones encuestadas estaban perdiendo un promedio de USD 9,7 millones anuales como resultado de la calidad deficiente de sus datos.

Los analistas y los científicos de datos pueden dedicar hasta el 80 % de su tiempo a limpiar y preparar datos. (TechRepublic)

9. La ubicación de las cosas

La ubicación de las cosas impulsará la innovación en la IoT

Afirmar que la proliferación de la Internet de las cosas (IoT) ocasionó un enorme crecimiento del número de dispositivos conectados en todo el mundo sería decir poco. Todos esos dispositivos tienen capacidad de interacción y recopilan datos que ofrecen una mejor experiencia de conexión. De hecho, Gartner predice que, en el año 2020, el número de dispositivos conectados con la IoT y disponibles para los consumidores será más del doble del actual. “Habrá más de 20 400 millones de dispositivos en línea con la IoT”.

Incluso con ese crecimiento, los datos de los casos de uso y la implementación de la IoT no han seguido la misma trayectoria deseada. A las empresas les preocupa la seguridad. Sin embargo, la mayoría de ellas no cuenta con los conocimientos y habilidades organizacionales adecuados o con la infraestructura técnica interna (acompañada de otras aplicaciones y plataformas) para admitir datos de la IoT.

La mayoría de las personas piensa en los conceptos de ubicación o geoespacio como una dimensión. Es algo que voy a analizar… La nueva tendencia es que se está convirtiendo en una contribución al proceso analítico.

De todos modos, se observa una tendencia positiva que consiste en el uso de los datos de ubicación de los dispositivos con IoT y los beneficios derivados de ese uso. Esta subcategoría, denominada “ubicación de las cosas”, permite a los dispositivos con IoT detectar y comunicar su posición geográfica. Cuando se conoce la ubicación de un dispositivo con IoT, es posible agregar contexto, comprender mejor la situación y predecir lo que sucederá en ese lugar específico.

Las empresas y las organizaciones que desean recopilar esos datos usan distintas tecnologías. Por ejemplo, los hospitales, las tiendas y los hoteles comenzaron a usar la tecnología Bluetooth de bajo consumo (BLE) para los servicios de ubicación en interiores, ya que el GPS solía tener dificultades para proporcionar la ubicación contextual. La tecnología BLE puede usarse para realizar el seguimiento de personas y activos específicos. También permite interactuar con dispositivos móviles, como relojes inteligentes, distintivos o localizadores, para ofrecer experiencias personalizadas.

Dado que se relacionan con el análisis de datos, los números correspondientes a la ubicación pueden considerarse entradas, en lugar de salidas (resultados). Si los datos están disponibles, los analistas pueden incorporarlos en sus análisis para comprender mejor qué sucede y dónde, y qué se espera en una zona contextualizada.

Los puntos de referencia de la IoT crecerán hasta alcanzar los 30 000 millones en 2020. (IDC)

Se prevé un crecimiento explosivo de la IoT, que superará los USD 5 000 millones para finales de 2020. (Gartner)

10. La inversión del sector académico

Las universidades redoblan la apuesta con programas de análisis y ciencia de los datos

En la Universidad Estatal de Carolina del Norte, se encuentra el primer programa de maestría en análisis científico (MSA). La MSA se lleva a cabo en el Institute of Advanced Analytics (IAA). Este centro de datos tiene la misión de “formar a los mejores profesionales del análisis de todo el mundo: personas que dominen herramientas y métodos complejos para el modelado de datos a gran escala, y que sientan pasión por resolver problemas que representen retos…”. Dado que el programa estatal de Carolina del Norte constituye una iniciativa sin precedentes, augura una generosa inversión del sector académico en el currículo de análisis y ciencia de los datos.

Hace unos meses, la Universidad de California en San Diego dio un importante primer paso para su institución: inauguró una especialidad y cursos complementarios de grado universitario en ciencia de los datos. Y eso no fue todo. Gracias a la magnífica donación de un exalumno, la universidad también presentó planes para crear un instituto de ciencia de los datos. En la Universidad de California en Berkeley, Davis y Santa Cruz, se siguió ese ejemplo y se ampliaron las opciones de análisis y ciencia de los datos que se ofrecen a los estudiantes. La demanda de estas superó las expectativas. ¿Por qué?

A menudo me sorprendo con las cosas que descubren los estudiantes y la forma tan intuitiva en que pueden ver datos, jugar con ellos y hasta realizar visualizaciones.

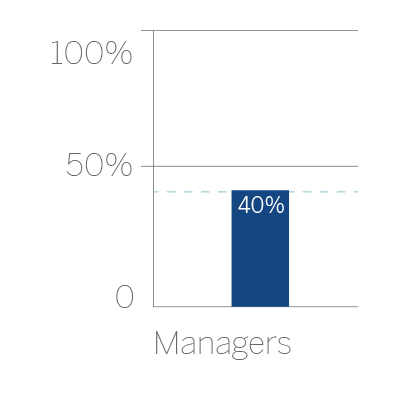

Según un estudio reciente de PwC, en el año 2021, el 69 % de los empleadores exigirá que los candidatos a sus puestos de trabajo tengan conocimientos de análisis y ciencia de los datos. En 2017, Glassdoor también informó que la “ciencia de los datos” fue uno de los “principales empleos” por segundo año consecutivo. A medida que crecen las demandas de los empleadores, se intensifica la necesidad de contar con especialistas en datos altamente capacitados. Sin embargo, existe una desconexión con la realidad. El mismo informe de PwC indica que solo el 23 % de los graduados universitarios tendrá los conocimientos necesarios para competir al nivel que exigen los empleadores. Una reciente encuesta del MIT revela que el 40 % de los administradores tiene dificultades para contratar a especialistas en análisis.

Las habilidades técnicas para el análisis ya no son optativas, sino fundamentales. En 2018, se comenzará a aplicar una metodología más rigurosa a fin de garantizar que los estudiantes adquieran los conocimientos necesarios para su inserción en el mercado laboral moderno. Además, las empresas continuarán optimizando sus datos para sacarles el máximo partido. En consecuencia, surgirá y crecerá la demanda de una fuerza laboral experta en datos.

En el año 2021, el 69 % de los empleadores exigirá que los candidatos a sus puestos de trabajo posean conocimientos de análisis y ciencia de los datos. (PWC)

i

Una reciente encuesta del MIT revela que el 40 % de los administradores han tenido dificultades para contratar a especialistas en análisis. (MIT)

Fuente: tableau.com, 2018.

Vincúlese a nuestras Redes Sociales:

Google+ LinkedIn YouTube Facebook Twitter

.

.

[…] Tendencias de Inteligencia de Negocios para 2018 […]

[…] Tendencias de Inteligencia de Negocios para 2018 […]