Contrainteligencia para todos: del Cono del Silencio al Santor Harp

abril 10, 2025

Por Gustavo Ibáñez Padilla.

En un mundo donde hasta tu tostadora podría estar espiándote (¡y no solo por tu gusto por el pan quemado!), proteger nuestras conversaciones cara a cara se ha convertido en una cuestión de supervivencia informativa. Vivimos en la era del micrófono omnipresente: teléfonos, relojes, asistentes virtuales, auriculares, bolígrafos espías y hasta lámparas con alma de James Bond. La privacidad, ese bien intangible que antes dábamos por hecho, hoy se ha convertido en un lujo… o en una estrategia de contrainteligencia.

¿Recuerdan el Cono del Silencio de Superagente 86? Ese armatoste transparente que descendía del techo para que el Agente 86 y el Jefe pudieran hablar en secreto… aunque, en realidad, nunca funcionaba. Pues bien, afortunadamente la tecnología ha avanzado desde entonces, y hoy tenemos opciones reales —y portátiles— para mantener nuestras charlas fuera del alcance de oídos indiscretos. Señoras y señores, les presento al Santor HARP: el ninja acústico del siglo XXI.

.

Cuando las paredes oyen (y graban)

No es paranoia si realmente te están escuchando. Cualquiera que haya pronunciado la frase “creo que necesito una aspiradora nueva” cerca de su teléfono y haya visto una avalancha de anuncios al respecto, lo sabe. ¿Y si esa conversación hubiera sido sobre una fusión empresarial, un plan de innovación o una traición amistosa en el póker del viernes? Pues ahí está el peligro.

En este escenario de vigilancia ubicua, la contravigilancia no es solo cosa de espías con gabardina y gafas oscuras. Es una necesidad estratégica tanto para directivos como para cualquier ciudadano que valore su privacidad. Y ahí es donde entra en acción el Santor HARP: un dispositivo diseñado con precisión quirúrgica para proteger conversaciones cara a cara en tiempo real.

La sinfonía del desconcierto: cómo funciona el Santor HARP

El Santor HARP no bloquea micrófonos como si fuera un inhibidor de señal al estilo de un tanque de guerra. No, eso sería demasiado burdo y, además, ilegal en muchos lugares. Lo que hace es mucho más elegante: confunde, desorienta y sabotea cualquier intento de grabación.

Modo de Mezcla de Voz: imagina una fiesta de cumpleaños en la que todos cantan a distintas velocidades y tonos. Eso es lo que escucha cualquier dispositivo espía cuando el HARP entra en acción: una cacofonía premeditada que se superpone a la conversación real, impidiendo su aislamiento mediante softwares de limpieza forense.

Modo Discreto: para los que prefieren el sigilo absoluto, este modo emite un ruido casi imperceptible, como un susurro constante que es suficiente para sabotear grabaciones sin molestar a los interlocutores. Y, por si fuera poco, puedes camuflarlo reproduciendo música desde tu lista de Spotify. ¡Espía eso, Siri!

Escudo Acústico Personalizado: con la app Santor Connect, puedes cargar tus propias frecuencias de voz al dispositivo. Así, la protección se ajusta a ti, como un traje a medida para tus cuerdas vocales. ¿Te imaginas a tu voz generando su propio campo de fuerza? Ya no hace falta imaginarlo.

Portabilidad letal (en el buen sentido)

El Santor HARP es tan compacto como un altavoz de escritorio y tan fácil de usar como una tostadora (esperemos que más seguro). No necesita cables interminables ni técnicos con destornilladores. Lo colocas sobre la mesa, eliges el modo que más te guste, y listo: tienes un escudo de invisibilidad auditiva.

Además, su diseño sobrio y minimalista no delata su verdadero poder, algo fundamental si no quieres que parezca que estás haciendo una película de espías en plena reunión de presupuesto.

Espías corporativos, abstenerse

No es casualidad que este dispositivo ya esté en manos de agencias gubernamentales y unidades militares alrededor del mundo. Pero su verdadera revolución está en acercar ese nivel de protección al ciudadano común, al ejecutivo preocupado por la filtración de una patente o al abogado que sabe que las paredes tienen oídos y micrófonos 4K.

La empresa detrás de esta maravilla es SANTOR Security Inc., una compañía canadiense fundada en 2011 y especializada en técnicas de contramedidas de vigilancia. ¿Su objetivo? Hacer que lo que se dice cara a cara, se quede cara a cara. Nada de archivos .mp3 con tu voz diciendo cosas comprometedoras.

¿Exageración o precaución sensata?

Algunos dirán que todo esto es paranoia tecnológica. Otros, que es simplemente sentido común adaptado al siglo XXI. Lo cierto es que, en un contexto donde la información puede valer más que el oro y donde cualquier micrófono puede convertirse en un testigo no deseado, proteger nuestras conversaciones debería ser una prioridad, no un lujo.

No se trata solo de evitar el espionaje empresarial o gubernamental. Se trata de proteger nuestras ideas, decisiones y planes. De preservar la confianza que surge en una conversación íntima o profesional. De no dejar que las máquinas escuchen lo que está reservado para los humanos.

.

Contrainteligencia: una necesidad, no una moda

Vivimos en tiempos donde la vigilancia pasiva ha dejado de ser ciencia ficción y se ha instalado cómodamente en nuestros bolsillos, escritorios y salones. Frente a esta realidad, la contrainteligencia no es solo un juego de espías ni una táctica militar. Es un acto de libertad personal y profesional. Es la manera en que recuperamos el control sobre nuestras propias palabras.

Así que la próxima vez que tengas una conversación importante, no invoques al Cono del Silencio ni te refugies en una cabina telefónica del siglo pasado. Hazlo con inteligencia. Hazlo con contrainteligencia. Hazlo con el Santor HARP.

Porque en un mundo donde todos te escuchan, el verdadero poder está en saber cuándo y cómo no ser escuchado. ¿Privacidad o complacencia? Tú decides.

Fuente: Ediciones EP, 10/04/25.

Más información:

Contrainteligencia empresarial

Vivir en un mundo incierto y complejo

Inteligencia y Contrainteligencia empresarial

La Seguridad Personal y Familiar en el Siglo XXI

Carlos Atachahua, el narcotraficante experto en Contrainteligencia

Contrainteligencia y Contravigilancia: cómo proteger tus conversaciones

Seguridad Humana Multidimensional: Una clave para enfrentar los retos contemporáneos

.

.

Una Taxonomía del concepto Inteligencia

septiembre 13, 2024

El término inteligencia proviene del latín intelligentia, que a su vez deriva de inteligere. Esta es una palabra compuesta por otros dos términos: intus (“entre”) y legere (“escoger”). Por lo tanto, el origen etimológico del concepto de inteligencia hace referencia a quien sabe elegir: la inteligencia posibilita la selección de las alternativas más convenientes para la resolución de un problema. De acuerdo a lo descrito en la etimología, un individuo es inteligente cuando es capaz de de escoger la mejor opción entre las posibilidades que se presentan a su alcance para resolver un problema.

Tipos de Inteligencia

Por Rafael Jiménez.

Análisis GESI, 43/2018

Resumen: El tratamiento de cualquier materia induce muy pronto a clasificar todas sus formas o modalidades. Este hecho es más acusado cuando se trata de una materia como la inteligencia, cuya aparición en el dominio público es relativamente reciente, aunque su práctica se remonte al principio de los siglos.

Este capítulo relaciona una amplia taxonomía de la inteligencia, que abarca las dimensiones que puede presentar (a qué se puede referir el concepto inteligencia: producto, proceso u organización); las clases que puede presentar el producto según el nivel de decisión de sus destinatarios; la identificación de ese mismo producto según su finalidad; los tipos de dicho producto según la necesidad de información que satisface; las formas de determinar el producto según el medio en el que se encuentre la información de la que parte; la identificación del mismo producto en función del método de obtención de la información de partida; las modalidades de la inteligencia según el territorio sobre el que se elabora; y cómo se la puede identificar en función de la materia o campos del conocimiento.

*****

1. Dimensiones de la inteligencia

Antes de abordar la clasificación de los tipos de inteligencia es preciso referirse a las dimensiones o conceptos que se pueden expresar con el término inteligencia.

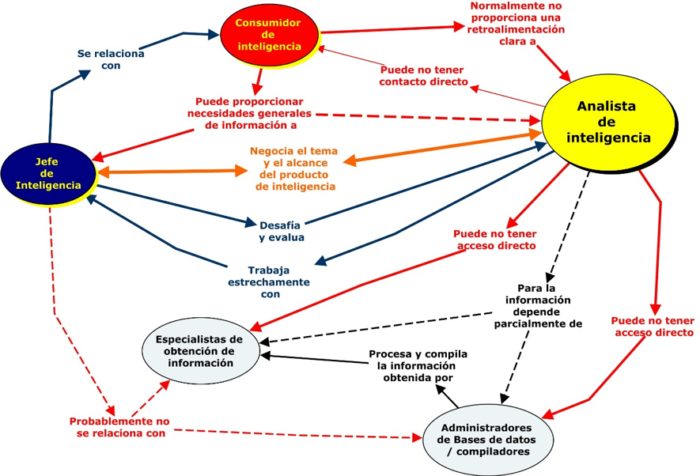

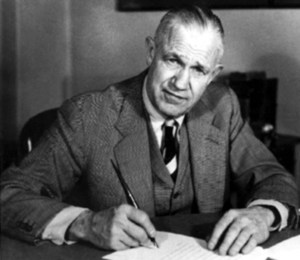

El primero que lo hizo, siempre referido a la inteligencia como componente de la seguridad nacional, fue Sherman Kent en 1949[1], que identificó el término con tres conceptos: a) el producto derivado de la transformación de la información y el conocimiento en inteligencia; b) la organización que realiza esta tarea; y c) el procesomediante el que se lleva a cabo.

La inteligencia como producto es el resultado que se obtiene al someter los datos, la información y el conocimiento a un proceso intelectual que los convierte en informes adecuados para satisfacer las necesidades de los decisores políticos, militares, policiales, empresariales, etc., así como para proteger a aquellos mediante las tareas de contrainteligencia.

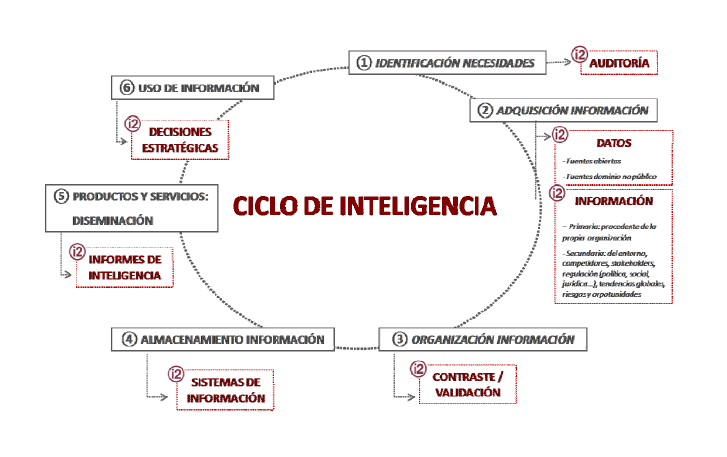

La inteligencia como proceso comprende los procedimientos y medios que se utilizan para definir las necesidades de los decisores, establecer la búsqueda de información, su obtención, valoración, análisis, integración e interpretación hasta convertirla en inteligencia, y su difusión a los usuarios. También incluye los mecanismos y medidas de protección del proceso y de la inteligencia creada por medio de las actividades de contrainteligencia necesarias.

La inteligencia como organización se refiere a los organismos y unidades que realizan las anteriores actividades de transformar la información en inteligencia y la protegen.

2. La Inteligencia según el nivel de decisión

Una vez determinado el concepto de inteligencia como producto, su contenido puede referirse a materias políticas y generales del Estado o más detalladas. Por tanto, en función del nivel de decisión del usuario para quien se elabora, la inteligencia puede ser de los siguientes tipos:

2.1. Inteligencia nacional

Es la que precisa el Gobierno de la Nación para definir y desarrollar su política en el más alto de sus niveles de decisión. La inteligencia nacional la elaboran los servicios de inteligencia de nivel nacional, cuya dependencia funcional suele ser del Presidente del Gobierno, aunque administrativamente estén adscritos o integrados en algún departamento ministerial.

2.2. Inteligencia departamental

Es la que necesitan los titulares de los distintos Ministerios del Gobierno de la Nación para ejecutar la política de sus respectivos departamentos. La elaboran los servicios de información e inteligencia dependientes de los respectivos departamentos ministeriales, cuyos productos tienen una aplicación directa en la ejecución de las correspondientes políticas ministeriales. A diferencia de la inteligencia nacional, que se elabora para decisores externos, la departamental constituye un insumo propio de los titulares y altos cargos de los Ministerios en su responsabilidad de ejecución de la política ministerial, así como de los mismos servicios que la elaboran.

2.3. Inteligencia operativa

Es la inteligencia que se genera y se utiliza para planear y ejecutar cualquier tipo de operaciones, tanto de carácter militar como policial o de inteligencia. Su nivel de elaboración y utilización es el más elemental y tiene una aplicación directa en el desarrollo de las operaciones de cualquier organismo o unidad.

3. La inteligencia según su finalidad

De forma similar a la que se ha definido anteriormente según el nivel de decisión del usuario para quien se elabora la inteligencia, esta puede tener distintas finalidades, que permiten clasificarla de la siguiente manera:

3.1. Inteligencia estratégica

Es la inteligencia que se elabora para facilitar la definición de los objetivos de la política y los planes generales de un Estado, para lo que debe tenerse en cuenta el entorno en que se encuentra y las metas que ha fijado el Gobierno.

Para ello, la inteligencia estratégica debe identificar los actores que intervienen en ese entorno, sus características y cómo pueden evolucionar. De esta manera presta una atención especial a los indicios que pueden significar riesgos y derivar en amenazas, o proporcionar oportunidades para la Nación.

La inteligencia estratégica se halla muy vinculada a la prevención y a la prospectiva, advirtiendo de amenazas a los intereses vitales de la seguridad nacional y de las oportunidades para el Estado, con lo que se convierte en la principal herramienta en poder de los gobernantes para diseñar y desarrollar las políticas exterior y la de seguridad nacional.

En el ámbito militar, la inteligencia estratégica tiene como finalidad facilitar la elaboración de los planes relativos a la conducción de las operaciones de nivel estratégico.

En el ámbito empresarial, la inteligencia estratégica tiene la finalidad de facilitar la toma de decisiones de sus directivos ante las amenazas o riesgos para la empresa, o aquellas que puedan facilitar un éxito u oportunidad de desarrollo. En concreto, se especializa en el análisis de los competidores para entender sus éxitos futuros, estrategias actuales, la posible evolución industrial y comercial, y sus capacidades. También incluye la inteligencia sobre los principales clientes, proveedores y socios.

Un caso particular de la inteligencia estratégica lo constituye la denominadainteligencia de alerta, que es la que tiene por finalidad prevenir al usuario de las amenazas contra los intereses nacionales o empresariales, para que pueda decidir con tiempo las medidas políticas, diplomáticas, militares, económicas, industriales, comerciales o de cualquier otro tipo que puedan neutralizarlas o hacerles frente.

3.2. Inteligencia táctica

La inteligencia táctica es la que se elabora para contribuir a la planificación y el diseño de las acciones concretas que permitan alcanzar un objetivo de alcance limitado, subordinado a los grandes objetivos de la inteligencia estratégica.

En el ámbito militar, la inteligencia táctica está destinada a la elaboración de los planes que permitan la conducción de las operaciones tácticas.

En el ámbito empresarial tiene un carácter más operacional, al consistir en la adopción de acciones concretas para conseguir un objetivo en una situación inmediata. Incluye aspectos como los términos de venta de los competidores, sus políticas de precios y los planes que tienen para cambiar la forma en que se diferencian sus productos de los propios.

3.3. Inteligencias operativa y operacional

La inteligencia operativa es la que se elabora para permitir la organización y ejecución de acciones para el cumplimiento de una misión, entendiendo por esta la que le es encomendada a un oficial de inteligencia, solo o dirigiendo un grupo, para lograr un propósito determinado.

En el ámbito militar, el término apropiado es inteligencia operacional y se encuentra en una posición intermedia entre la estratégica y la táctica. Su elaboración tiene como finalidad apoyar la planificación y la realización de campañas en el teatro de operaciones, en el nivel operativo.

3.4. Inteligencia prospectiva

La inteligencia prospectiva se inicia a partir de la inteligencia estratégica y está orientada a determinar de modo anticipado las opciones de evolución de una situación y las posibilidades y probabilidades de actuación de los elementos involucrados en ella, con objeto de reducir la incertidumbre por el futuro en entornos caracterizados por la complejidad, el cambio y la inestabilidad.

El término de inteligencia prospectiva se emplea específicamente para precisar los objetivos estratégicos de una organización y planificar las acciones necesarias para lograrlos. Asimismo, se utiliza para adoptar decisiones que contribuyan a conducir una realidad determinada hacia un escenario futuro deseable.

Tiene un alto componente de estimación, por lo que también se la conoce comointeligencia estimativa o predictiva.

Se trata de una inteligencia muy compleja y costosa, por la necesidad de contar con especialistas instruidos en las técnicas de la prospectiva y en los diversos campos que influyen en el futuro de una organización, así como por la necesidad de contar con tiempo para elaborarla. Ambas circunstancias condicionan de tal modo su generación que no es habitual que se elabore en las organizaciones ni servicios de inteligencia, más ocupados por los demandantes en elaborar inteligencia actual y de inmediato futuro.

4. La inteligencia según la necesidad de información que satisface

La elaboración de inteligencia se produce como consecuencia de la aparición de un requerimiento concreto, sea de los potenciales usuarios o del propio servicio de inteligencia que debe elaborarla. De esta forma, la inteligencia puede ser:

4.1. Inteligencia básica

La inteligencia básica es la que se produce para satisfacer los requerimientos de inteligencia permanentes y generales de la organización de que se trate.

Se emplea sobre todo para responder a las necesidades de información que se plantean durante la producción de inteligencia estratégica e inteligencia prospectiva o estimativa. Por tanto, se elabora atendiendo a los objetivos estratégicos de la organización. Dado que se convierte en un importante almacén de inteligencia, también se utiliza para atender demandas de información durante la producción de inteligencia táctica, operativa y operacional.

La producción de inteligencia básica se realiza de un modo rutinario y programado a partir de fuentes de información abiertas, generalmente obras de referencia, estados y descripciones generales, guías de seguimiento, etc., como enciclopedias, bases de datos, anuarios, directorios, etc.

Esta inteligencia tiene un grado de permanencia mayor que cualquier otra y a ella se incorpora la que se extrae de la inteligencia estratégica que se ha elaborado durante el desarrollo de la actividad de la organización, por lo que también suele recibir la denominación de inteligencia general de la organización, convirtiéndose en un activo informacional de esta.

4.2. Inteligencia actual

Es la inteligencia que tiene por finalidad satisfacer los requerimientos de inteligencia puntuales y concretos de una organización. Presenta el estado de una situación o de un acontecimiento en un momento dado y puede señalar opciones de evolución en un corto plazo, así como indicios de riesgos inmediatos.

Se emplea principalmente para responder a las demandas de información que surgen durante la aparición de un fenómeno o acontecimiento imprevisto, durante un proceso de toma de decisiones sobre un acontecimiento de interés nacional o durante la planificación y el desarrollo de una misión.

Suele ser la más demandada por los gobernantes, cuyos plazos de previsión y decisión son generalmente cortos.

Como fin complementario, la inteligencia actual pone al día la inteligencia básica y los análisis realizados por la inteligencia estratégica. Esto permite disminuir las necesidades de información durante las gestiones de crisis.

Los productos de la inteligencia actual suelen adoptar la forma de informes específicos para atender una demanda concreta y actual de información; o la de informes breves y periódicos, muchas veces diarios, sobre cuestiones de interés general y frecuente sobre las que los decisores políticos desean mantener un conocimiento permanente.

4.3. Inteligencia crítica

Como un caso particular de la inteligencia actual surge el concepto de inteligencia crítica, que es la que se elabora para satisfacer los requerimientos informativos que se producen durante la gestión de una crisis.

El tiempo dedicado a la obtención y procesamiento de datos e información y a la valoración, análisis, integración e interpretación durante una crisis se reduce al mínimo imprescindible con objeto de dar a conocer el estado de la situación con la máxima urgencia posible, que además suele evolucionar con rapidez. Por tanto, elaborar inteligencia que permita al responsable político tomar decisiones rápidas y acertadas exige tanto disponer de información concreta sobre lo que ocurre como contar con unas buenas reservas de inteligencias básica y actual que permitan contextualizar el sentido de la nueva información disponible y mejorar su comprensión.

Los productos más habituales durante la gestión de crisis son alertas e informes de situación sobre la evolución de los acontecimientos. La forma de materialización de dichos informes se convierte muchas veces en modo de gráficos, mapas, esquemas, croquis, etc., que, convenientemente ilustrados, permiten un rápido conocimiento de dicha evolución de la situación.

En situaciones de crisis puede ocurrir que, ante la perentoria necesidad de tomar una decisión, se suministre información a los responsables sin analizar ni interpretar suficientemente, o con una estimación provisional muy sujeta a la evolución de los acontecimientos. En estos casos se deja a dichos responsables la tarea de valorar la información que se les suministra, en beneficio de la urgencia con que se puede poner a su disposición. Esta excepcionalidad es motivo de debate, por lo que supone de trasladar la responsabilidad del análisis de inteligencia a los decisores políticos, modificando el funcionamiento habitual del ciclo de inteligencia.

5. La Inteligencia según el medio en el que se encuentra la información

La información de partida para la elaboración de inteligencia puede encontrarse en muy diferentes medios, dando lugar a distintos tipos de inteligencia que reciben el nombre de la que haya sido su componente principal. De esta manera, la inteligencia puede clasificarse del siguiente modo:

5.1. Inteligencia HUMINT o de fuentes humanas

Es la que se elabora a partir de información recogida o suministrada directamente por personas. Sus resultados dependen fundamentalmente de la actuación del hombre mediante sus sentidos, ayudándose o no con medios auxiliares (cámaras, grabadoras, fotocopiadoras, etc.).

En los servicios de inteligencia se consideran diversos tipos de fuentes humanas, cuya actividad facilita en algún grado la obtención de información. En el CNI esta diversidad ha dado lugar a la siguiente clasificación:

- Contacto: persona ajena a un servicio de inteligencia al que proporciona información, de modo consciente o inconsciente y de forma ocasional o regular, pero cuya dirección no es posible o conveniente realizar por parte del servicio. Puede recibir algún tipo de contraprestación.

- Informador: persona ajena a un servicio de inteligencia al que proporciona información, de modo consciente o inconsciente y de forma ocasional o regular, bajo la dirección de un miembro del servicio. Suele percibir algún tipo de contraprestación.

- Colaborador: persona ajena a un servicio de inteligencia, que coopera para este, de modo consciente o inconsciente y de forma ocasional o regular, realizando una serie de actividades, dirigidas por un oficial de inteligencia, en beneficio de los cometidos asignados al servicio. También suele percibir algún tipo de contraprestación. Por tanto, se diferencia del informador en que no suele facilitar información, o al menos no es su cometido principal, sino que facilita tareas que debe realizar el servicio.

- Agente: persona ajena a un servicio de inteligencia que realiza alguna actividad abierta o encubierta en beneficio del servicio y bajo la dirección de un miembro del mismo, tras recibir adiestramiento especial. Los agentes se reclutan habitualmente para llevar a cabo o dar asistencia en tareas de obtención de información y en operaciones de contrainteligencia. Normalmente el agente recibe algún tipo de contraprestación. No debe confundirse el tipo de agentecomo fuente humana, con la misma denominación de agente con que se identifica a los miembros de los servicios de inteligencia que realizan actividades secretas, abiertas o encubiertas, generalmente encuadrados en unidades operativas de obtención de información.

La información obtenida a partir de fuentes humanas es muy útil porque puede proporcionar datos imposibles de obtener por otros medios. Para ello es necesario que se encuentren situadas en el lugar y momento adecuados para adquirir esa información, formación suficiente para apreciarla y poseer un buen y oportuno sistema de comunicación para hacerla llegar al servicio.

La obtención de información por medios humanos, para que sea valiosa, debe superar dos momentos críticos: a) la captación o infiltración de la fuente en el lugar donde pueda acceder a la información deseable; y, b) la valoración de la información adquirida por parte del oficial de relación y de los analistas; el primero es responsable de evaluar la fiabilidad de la fuente, de la que debe conocer su formación, capacidades, vulnerabilidades, intereses, posibilidades, condiciones (facilidades y riesgos) en las que actúa, etc.; mientras que los segundos, los analistas que reciban el fruto de su adquisición, son los principales responsables de evaluar la calidad de la información proporcionada, así como de remitir al órgano de obtención donde se encuentre el oficial de relación su valoración de la información recibida y, unida a ella, la percepción sobre la fiabilidad de la fuente que la ha proporcionado.

5.2. Inteligencia OSINT o de fuentes abiertas

Es la que se elabora a partir de información obtenida de recursos informativos de carácter público.

Por fuente abierta se entiende todo documento con cualquier tipo de contenido, fijado en cualquier clase de soporte que se transmite por diversos medios y al que se puede acceder en modo digital o no, puesto a disposición pública, con independencia de que esté comercializado, se difunda por canales restringidos o sea gratuito.

La información que transmiten las fuentes abiertas se caracteriza por su singularidad, su rápido modo de obtención, su fácil actualización, su bajo coste en relación con la procedente de otras fuentes y su adquisición sin correr riesgos. Es un axioma que no se debería recoger información pública mediante medios clandestinos, complejos, arriesgados y costosos en términos económicos y políticos.

La información procedente de fuentes abiertas es la más utilizada para la producción de inteligencia estratégica, inteligencia básica, inteligencia económica e inteligencia científica. Además, esta información es indispensable para analizar adecuadamente la información clandestina.

La actual y creciente reivindicación de la importancia de la información OSINT se debe a la confluencia de dos fenómenos: a) la aparición del concepto de multinteligencia, que rechaza el uso de una única autoridad informativa para crear inteligencia; y b) la ampliación del concepto de seguridad obliga a los servicios de inteligencia a recabar, analizar y evaluar información de índole muy variada y en materias donde las fuentes abiertas son imprescindibles.

Dada la amplitud y variedad de fuentes públicas, la tipología clásica la clasifica del siguiente modo[2]:

5.2.1. Fuentes de información primaria

Son las que contienen información original, de primera mano y que, por tanto, no han recibido ningún tipo de tratamiento. Dentro de este grupo se suele distinguir: fuentes de información primaria editadas, que forman parte de los circuitos habituales de publicación y distribución y cuya existencia queda verificada por procedimientos legales (ISSN, ISBN, NIPO), entre las que destacan los libros, las revistas, las películas o los discos; y las fuentes de información primaria inéditas, que pertenecen a lo que se ha dado en llamar literatura gris, y que está compuesta por tesis doctorales, presentaciones, pre-prints, actas de congresos o informes científico-técnicos, entre otras, que por lo general tienen una visibilidad menor y suelen carecer de control bibliográfico.

5.2.2. Fuentes de información secundaria

Son las resultantes del tratamiento documental de las fuentes de información primaria y proceden de la aplicación de técnicas documentales que proporcionan valor añadido (los resúmenes, la agrupación en clasificaciones de materias, la correspondencia con otros idiomas y, sobre todo, la relación de unos documentos con otros). Entre este tipo de fuentes se encuentran las bases de datos, los catálogos, los repertorios bibliográficos y los repertorios legislativos.

5.2.3. Fuentes de información terciaria

Podrían asimilarse a las fuentes secundarias, pero el Programa General de Información de la UNESCO les atribuye una finalidad específica: la consolidación de la información mediante productos que analizan críticamente el conjunto de unidades documentales propias de una disciplina, extrayendo de cada una de ellas lo más relevante en cuanto a innovación y progreso. Formarían parte de este tipo de fuentes las revisiones (review) y los estados de la cuestión.

5.2.4. Obras de referencia

Son las que fueron ideadas para la consulta puntual de algunas de sus entradas y entre ellas destacan: enciclopedias, diccionarios, anuarios, glosarios, o las modernasFrequently Asked Questions (FAQ).

Además de esta clasificación académica, otras tipologías se fijan en el emisor (fuentes gubernamentales, parlamentarias, judiciales, policiales, académicas, etc.), en el soporte (impresas, audio, video, informáticas, etc.), en el coste (venales o gratuitas), en la periodicidad, en el destinatario o en el grado de especialización (fuentes generales y fuentes especializadas). De esta manera se pueden clasificar las fuentes OSINT de la siguiente forma:

5.2.5. Fuentes de información institucional

Publicaciones oficiales (boletines oficiales, del registro mercantil, etc.), estadísticas, legislación, jurisprudencia, sistemas de seguimiento legislativo, documentación parlamentaria, y documentación emitida por organismos internacionales.

5.2.6. Fuentes de información económica

Estudios de mercado, informes económico-comerciales de países, información sobre contratación pública, etc.

5.2.7. Fuentes de información geopolítica

Barómetros de conflictos, documentos de comités de expertos y de think tanks.

5.2.8. Fuentes de información sociológica

Estudios de opinión pública, participación electoral, flujos migratorios, encuestas demoscópicas, congresos de partidos políticos y sindicatos, etc.

5.2.9. Fuentes de información de seguridad y defensa

Blanqueo de capitales, tráfico ilícito, terrorismo, infraestructuras críticas, corrupción, ciberdelincuencia, etc.

5.2.10. Fuentes de información bibliográfica

Bases de datos bibliográficas.

5.2.11. Fuentes de información de prensa

Editoriales y editorialistas, análisis de la prensa, servicios de seguimiento de medios, recortes (clipping).

5.2.12. Fuentes de redes sociales y páginas web

Monitorización de redes y páginas informáticas.

5.2.13. Fuentes archivísticas

Destinadas a recoger la producción de documentación de las administraciones modernas y de las empresas; están sometidas a procesos de selección y constitución de colecciones.

5.3. Inteligencia SIGINT o de señales

Es la inteligencia que se elabora a partir de la obtención y el procesamiento de datos provenientes de la detección, interceptación y descifrado de señales y transmisiones de cualquier clase. Es un término genérico, pues dada la gran cantidad de posibles orígenes de señales electromagnéticas y acústicas, una primera clasificación de la inteligencia SIGINT puede diferenciar las siguientes:

5.3.1. Inteligencia COMINT o de comunicaciones

Es la inteligencia obtenida a partir de emisiones electromagnéticas de equipos y sistemas de tecnologías de la información y de las comunicaciones (STIC); por ejemplo, ordenadores, impresoras, faxes, teléfonos, télex, líneas de comunicaciones, agendas electrónicas, tarjetas inteligentes, etc.

Un caso particular de inteligencia COMINT lo constituye la inteligencia cibernética o CYBINT[3], que es la inteligencia elaborada a partir de datos, protegidos o no, del espacio cibernético. Este, a su vez, está definido como el espacio virtual compuesto por dispositivos computacionales conectados en red, donde las informaciones digitales se transmiten, son procesadas o almacenadas. Un ejemplo muy claro de inteligencia CYBINT es la que puede obtenerse a partir de datos adquiridos en las redes sociales. La inteligencia cibernética está íntimamente ligada a la de fuentes abiertas.

Cuando las emisiones de las que se obtiene la información son involuntarias o no deseadas por el emisor se denominan TEMPEST, como por ejemplo las emitidas por las líneas de conducción de comunicaciones, los teclados de ordenador, las radiaciones de las pantallas, etc.

5.3.2. Inteligencia ELINT o electrónica

Es la inteligencia obtenida a partir de emisiones electromagnéticas de medios ajenos a las telecomunicaciones (radares, equipos de ayuda a la navegación, perturbadores de sistemas de comunicación, etc.).

Este tipo de inteligencia, a su vez se subdivide en las siguientes clases:

5.3.2.1. Inteligencia RADINT o de emisiones radar

Es la inteligencia que se obtiene a partir de las emisiones de los radares.

5.3.2.2. Inteligencia TELINT o telemétrica

Es la que se obtiene a partir de emisiones de equipos electromagnéticos de telemetría.

5.3.3. Inteligencia MASINT o de medición de señales

Es la que se elabora a partir de la obtención y el procesamiento de datos provenientes de sensores destinados a recoger las señales que emiten fenómenos físicos distintos a las emisiones electromagnéticas, como el sonido, el movimiento, la radiación, etc. Estas señales se denominan firma del equipo o equipos. Los sensores se dedican a identificar toda característica distintiva asociada con la fuente o el emisor y facilitar la detección y la localización de este último.

De acuerdo con la señal que mide se distinguen diversos tipos específicos de medición de señales:

5.3.3.1. Inteligencia ACINT o acústica

Es la inteligencia derivada de la obtención y el análisis de los fenómenos acústicos producidos por cualquier emisor (buque de superficie, submarino, torpedo, aeronave, dron, vehículo terrestre, proyectil, maquinaria, etc.).

5.3.3.2. Inteligencia TELINT o telemétrica

Ya citada anteriormente (ver 5.3.2.2), permite el análisis de la firma de equipos telemétricos, instalados, por ejemplo, en misiles, satélites, armas de precisión, etc.

5.3.3.3. Inteligencia NUCINT o de radiaciones nucleares

Es la que se obtiene a partir de la medición de señales procedentes de radiaciones nucleares (bombas radiológicas o sucias, bombas atómicas, etc.).

5.4. Inteligencia IMINT o de imágenes

Es la inteligencia que se elabora a partir del análisis de imágenes adquiridas por medios técnicos, como cámaras fotográficas, medios de grabación de imágenes, radares, sensores electro-ópticos, visores térmicos o infrarrojos, ubicados en plataformas terrestres, navales, aéreas o espaciales. En este tipo de inteligencia destacan:

5.4.1. Inteligencia GEOINT o geoespacial

La observación geoespacial, identificada como GEOINT, es el resultado de la explotación y análisis de la información de imágenes y geoespacial para describir, valorar y visualizar características físicas y georreferenciar (situar) actividades en el planeta.

5.4.2. Inteligencia PHOTINT o fotográfica

Es el tipo de inteligencia obtenida mediante el análisis e interpretación de la fotografía aérea, realizada por aviones, helicópteros o drones (JSTARS) de detección y seguimiento de objetivos terrestres o móviles provistos de videofotografía y termografía. Los JSTARS son plataformas aéreas (aviones, helicópteros o drones) que disponen de medios de detección, identificación y seguimiento de objetivos terrestres y móviles, así como de medios de comunicación y señalamiento a los vectores de lanzamiento para atacar a dichos objetivos terrestres o móviles (aéreos y navales).

5.5. Inteligencia TECHINT o técnica

Es el tipo de inteligencia que se elabora a partir de la obtención y el procesamiento de información mediante el uso de medios técnicos. Es un término genérico con el que se designa el uso conjunto de datos provenientes de las inteligencias SIGINT e IMINT.

6. La inteligencia según el método de obtención

La inteligencia también puede clasificarse según el método utilizado para obtener los datos y la información que le sirven de base. Las denominaciones de estos tipos de inteligencia coinciden con los descritos en el punto anterior, excepto que no existe inteligencia OSINT, sino que esta puede obtenerse por métodos HUMINT, SIGINT o IMINT, o varios de ellos simultáneamente.

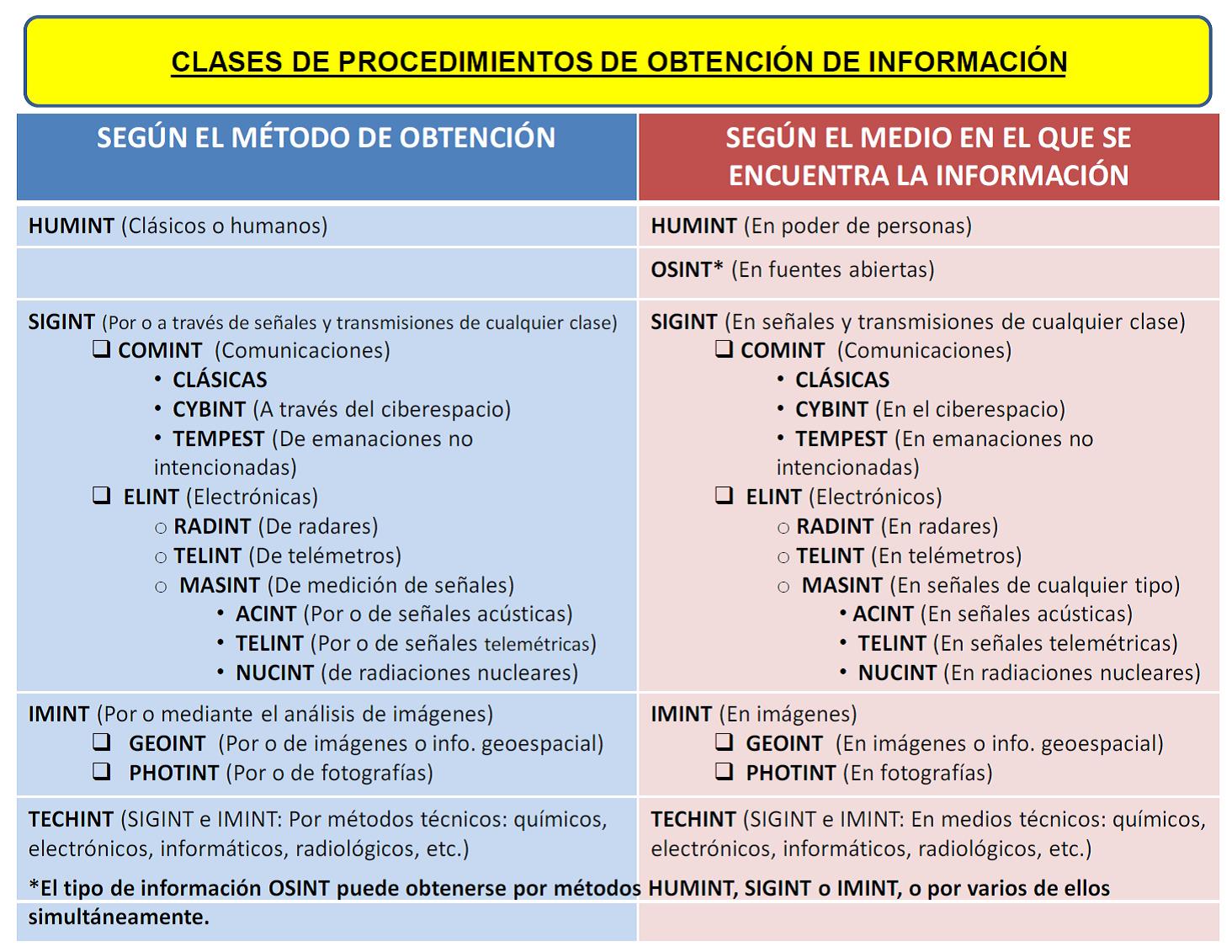

De esta manera, se pueden clasificar los procedimientos de obtención de información según el método utilizado para su adquisición y según el medio en que se encuentra, dando lugar a la siguiente tabla comparativa:

La inteligencia según el método de obtención y comparación con el medio en el que se encuentra la información que le dará nombre: procedimientos de obtención de información.

La inteligencia que se elabora con la información obtenida según un método o contenida en un medio determinado adquiere el mismo nombre. Por ejemplo, la inteligencia elaborada a partir de información obtenida, única o predominantemente, por métodos o en medios HUMINT se denomina Inteligencia HUMINT.

7. La Inteligencia según el territorio sobre el que se elabora

Aunque las amenazas sean globales, los servicios de inteligencia pueden especializar sus tareas en el territorio nacional o fuera de él, dando lugar a una nueva clasificación de la inteligencia por el lugar sobre el que se elabora. Asimismo, la cada vez mayor intervención de organismos multinacionales en misiones internacionales de mantenimiento de la paz ha obligado a generar un tipo de inteligencia específico, adaptado a las necesidades de las misiones abordadas, en el que intervienen varios de los servicios de inteligencia de los países que conforman dichos organismos multinacionales.

Generalmente, los países desarrollados tienden a contar con dos o más servicios de inteligencia de nivel nacional, mientras que la mayor parte de los países sólo cuentan con uno que atiende las necesidades del Gobierno de su país en todo el mundo. Una clasificación de la inteligencia según el territorio del que se ocupa es la siguiente:

7.1. Inteligencia interior

Es el tipo de inteligencia que se ocupa de identificar y seguir la evolución de los riesgos y amenazas a la seguridad procedentes del interior del Estado al que pertenece el servicio de inteligencia, con el fin de apoyar el proceso de adopción de medidas preventivas o de neutralización por parte del Gobierno.

Para ello, la inteligencia interior centra su atención en la investigación de las intenciones, las actividades y la capacidad de individuos y organizaciones que tienen o pueden evolucionar hacia finalidades desestabilizadoras o de franca agresión al orden político establecido o a los intereses nacionales.

7.2. Inteligencia exterior

La inteligencia exterior se ocupa de identificar y seguir la evolución de los riesgos y amenazas a la seguridad procedentes del exterior del Estado al que pertenece el servicio de inteligencia, con el fin de apoyar la adopción de medidas preventivas o de neutralización por parte del Gobierno, así como las que pueda diseñar para promover los intereses nacionales.

Para ello, la inteligencia exterior centra su atención en la investigación de las intenciones, las actividades y la capacidad de personas, organizaciones y naciones extranjeras que puedan atentar contra la soberanía, el orden político establecido, los intereses nacionales y la integridad territorial. Igualmente, se ocupa de detectar oportunidades favorables para la promoción y defensa de los intereses nacionales fuera de las propias fronteras.

7.3. Inteligencia multinacional

Es el tipo de inteligencia realizada sobre un conjunto de naciones o región geográfica, en la que intervienen servicios de distintos países con una finalidad común, como puede ser la que precisan organizaciones multinacionales, como la OTAN, la Unión Europea, la ONU, los países integrantes del Acuerdo UKUSA, etc. Los servicios que elaboran este tipo de inteligencia reciben el nombre de centros de fusión de inteligencia.

8. La Inteligencia según la materia o campos del conocimiento

Los múltiples campos sobre los que tienen que actuar los servicios y otros organismos que producen inteligencia, permiten identificar una nueva clasificación de su producto en función de la materia o campo del conocimiento sobre el que se centra. De esta forma, se pueden hallar los siguientes tipos de inteligencia:

8.1. Inteligencia geográfica

Es la que procede del estudio de las características naturales y artificiales de un espacio o zona geográfica determinada. Generalmente es complementaria de otros tipos de inteligencia.

8.2. Inteligencia política

Es la que trata la política interior y exterior de los gobiernos y las actividades de los movimientos políticos. En los servicios de inteligencia de nivel nacional ocupa una gran parte de su actividad productora.

8.3. Inteligencia sociológica

Se fundamenta en el conocimiento de la estructura y de todos los factores sociales de una nación o zona determinada.

8.4. Inteligencia militar

Identificada como MILINT, es la que se elabora a partir de la información relativa a naciones extranjeras, fuerzas o elementos hostiles o potencialmente hostiles y áreas de operaciones reales o potenciales. Es un ámbito de la inteligencia propio de las fuerzas armadas, por lo que la información que cobra mayor importancia es la relativa a la doctrina, organización, orden de batalla, capacidades, fuerzas, medios, estrategias y tácticas de fuerzas armadas u organizaciones de cualquier tipo, que empleen o puedan emplear procedimientos militares, hostiles o potencialmente hostiles.

La finalidad de la inteligencia militar es facilitar la toma de decisiones en los procesos de dirección y ejecución de las operaciones militares, disminuyendo las incertidumbres de los jefes y sus estados mayores, proporcionándoles la inteligencia oportuna, pertinente, precisa, predictiva y adaptada sobre el enemigo y otros aspectos del área de operaciones que permitan la planificación, ejecución y conducción de las operaciones.

La inteligencia militar, en el siglo XXI, no es la mera descripción de las fuerzas enemigas, de sus medios y capacidades de combate, sino que consiste también en el entendimiento de su cultura, motivaciones, finalidad y objetivos que persiguen. Es decir, no sólo se debe conocer y entender al adversario, sino que es imprescindible conocer y valorar la población de la que surge o proviene, el apoyo que recibe o puede recibir de ella y el apoyo que pueden recibir las fuerzas propias. Se trata de entender el entorno en el que se realizan las acciones de una operación, el llamado entorno operativo.

8.5. Inteligencia científica y tecnológica

Es la que se ocupa de la obtención y el procesamiento de información de carácter científico y tecnológico en los ámbitos civil y militar de interés para la seguridad. Su finalidad es detectar y efectuar el seguimiento de proyectos y actividades de investigación y de desarrollo científico y tecnológico emprendidos por organizaciones o países extranjeros, que puedan derivar en situaciones de riesgo para la seguridad nacional e internacional, con objeto de poder adoptar contramedidas efectivas. Mediante sus análisis puede valorarse el carácter y la capacidad armamentística de posibles adversarios, así como los avances científicos y tecnológicos que pueden derivar en la creación de armas u otros productos susceptibles de representar una amenaza para la seguridad.

La inteligencia científica y tecnológica está ampliando cada vez más su objetivo de atención tradicional, el armamento y los sistemas de armas, para abarcar los campos de las inteligencias económica y competitiva, lo que supone que se ocupe también de la identificación, seguimiento y evaluación de los avances científicos y tecnológicos, dentro de los marcos legales, que se producen en los distintos sectores de interés económico público o privado, con independencia de su posible uso militar.

Una última finalidad de la inteligencia científica y tecnológica lo constituye la que permite adoptar avances tecnológicos ajenos para evitar pasar por largas y costosas etapas previas de investigación.

La inteligencia científica usa de modo intensivo las fuentes de información abiertas, ya que se dedica a vigilar las investigaciones que se realizan en los mundos académico y empresarial antes de que se efectúe su aplicación industrial. En cambio, la inteligencia tecnológica, por estar más relacionada con el seguimiento de las aplicaciones que realizan empresas y organismos públicos de investigación de los conocimientos obtenidos en la investigación básica, también utiliza información procedente del espionaje industrial o de medios técnicos, como la fotografía aérea, la observación por satélite, la cibernética y la interceptación y escucha de señales acústicas.

La inteligencia tecnológica no se debe confundir con la inteligencia técnica (TECHINT), que, como se expresa en el punto 6, es la que se elabora a partir de información obtenida por métodos técnicos (SIGINT e IMINT).

8.6. Inteligencia económica

La creciente integración de los asuntos económicos en el concepto de seguridad ha dado lugar a la necesidad de elaborar inteligencia sobre ellos. Sin que exista unanimidad en el concepto de inteligencia económica, esta puede entenderse como la que se ocupa de la obtención y el procesamiento de la información financiera, económica y empresarial de un Estado para permitir una eficaz salvaguarda de los intereses nacionales, tanto en el interior como en el exterior.

En el mismo ámbito de la inteligencia económica también se incluyen otras acciones complementarias más específicas, como la sensibilización de las empresas nacionales sobre la necesidad de adoptar medidas preventivas contra el espionaje económico, la realización de análisis macroeconómicos de los Estados en los que se pretende invertir o hay inversiones de empresas del país, la protección interna y la promoción y protección externa en el mercado de la industria nacional, el control del tráfico de material de defensa y de doble uso civil y militar, y la creación de una cultura de inteligencia económica.

Las fuentes de información abiertas predominan para la producción de inteligencia económica, pero también se hace uso, cuando es necesario, de información secreta obtenida por medios encubiertos. Esto último es lo que diferencia la inteligencia económica que realizan los servicios de inteligencia y la que producen otros órganos de la Administración o empresas privadas especializadas.

La acepción «inteligencia económica» tuvo su origen en la década de 1970-80 en Francia, entendiéndola como los conocimientos que precisan el Estado o las empresas para alcanzar sus objetivos estratégicos. El Informe Martre[4] (1994), enfocado esencialmente al desarrollo de la inteligencia económica y estratégica de las empresas, definió la inteligencia económica como «el conjunto de acciones coordinadas de investigación, tratamiento y distribución, en vista a su explotación, de la información útil a los actores económicos −ya sean empresas u organizaciones estatales−. Informaciones que se han de aportar mediante métodos legales, con todas las garantías de protección necesarias para preservar el patrimonio empresarial en las mejores condiciones de coste y marco temporal».

La inteligencia económica «implica ir más allá de acciones parciales provenientes del análisis documental, de acciones de vigilancia, de la protección del patrimonio competitivo, de acciones de influencia, etc., para lograr una intencionalidad estratégica y táctica»[5]. De esta forma se entronca con la estrategia y su puesta en acción (táctica), y es el elemento esencial de investigación e interpretación de las intenciones y capacidades de los competidores, ya sea como defensa de la posición actual del Estado o empresa que la practica, o como medio para obtener una supremacía concreta de acuerdo con los intereses estratégicos. La inteligencia económica, por tanto, se apoya en la vigilancia del entorno competitivo, diferenciándose de otros procesos o sistemas de inteligencia en tres elementos principales: sus fines son exclusivamente económicos; trabaja con fuentes abiertas; y debe ser ética en todas sus acciones.

No obstante estas descripciones de la inteligencia económica en sus orígenes, en el presente siglo se ha empezado a determinar la inteligencia económica como la obtenida a partir de información financiera, económica y empresarial de un Estado, diferenciándola de la competitiva o empresarial, que la realizan las empresas. De esta forma, la inteligencia económica la llevan a cabo tanto los servicios de inteligencia −que utilizan información secreta obtenida por medios encubiertos−, como otros órganos de la Administración, fundamentalmente de los Ministerios de Hacienda y de Economía (o sus órganos adscritos), y empresas especializadas, que sólo utilizan fuentes abiertas.

8.7. Inteligencia competitiva

De la misma forma que se produce con la inteligencia económica, no hay unanimidad en la definición de inteligencia competitiva, que, además, se ha visto identificada en su definición como inteligencia empresarial, como término más moderno que englobaría a la inteligencia competitiva y a la inteligencia de negocios (business intelligence).

El Equipo Económico del CNI definió en 2009 la inteligencia competitiva como «una herramienta de gestión o práctica empresarial que consiste en un proceso sistemático, estructurado, legal y ético, por el que se recoge y analiza información que, una vez convertida en inteligencia, se difunde a los responsables de la decisión para facilitar esta, de forma que se mejora la competitividad de la empresa, su poder de influencia y su capacidad de defender sus activos materiales e inmateriales».

Los objetivos de la inteligencia competitiva son planificar y adoptar medidas para mantener la competitividad de la empresa y afrontar con mayores garantías los rápidos y continuos cambios a los que se ve sometida toda organización. Para lograrlo se ocupa de la obtención y el procesamiento de información sobre los elementos que caracterizan la realidad política, social, económica, cultural, legal y tecnológica que rodea a la empresa y sobre los agentes que actúan en ella. Presta una especial atención a la identificación y el seguimiento de señales indicadoras de cambios significativos en el entorno, por lo que trabaja con datos procedentes del exterior de la organización, que obtiene sobre todo de fuentes de información abiertas.

Por tanto, la diferencia principal entre la inteligencia económica y la inteligencia competitiva es que la económica la realiza el Estado fundamentalmente, mientras que la competitiva la realizan las empresas.

Por otra parte, la diferencia entre la inteligencia competitiva y la de negocios estriba en que la competitiva analiza el entorno de la empresa, utilizando fuentes externas e información abierta; mientras que la inteligencia de negocios se realiza a partir de los datos internos de la propia actividad de la empresa, para mejorar su rendimiento, fidelizar clientes y obtener beneficios.

La práctica de la inteligencia de negocios se basa en el empleo de tecnologías y aplicaciones informáticas que permiten buscar, recuperar, analizar y visualizar de modo unificado datos heterogéneos y dispersos entre diferentes sistemas, con independencia de las aplicaciones empleadas para su creación y almacenamiento y de que estén en ficheros de texto o estructurados en bases de datos. Estas herramientas, haciendo uso de técnicas de minería de información, establecen asociaciones entre los datos y desvelan patrones ocultos, de acuerdo con el cumplimiento de unos criterios estadísticos y preestablecidos, que ayudan a la interpretación. La inteligencia de negocios sirve de apoyo para la gestión de diversas áreas de las empresas, como producción, finanzas, relación con clientes y proveedores, ventas, recursos humanos o logística.

Dentro de la inteligencia competitiva se encuentra incluida la inteligencia de mercados,que se obtiene a partir de la información relevante sobre el mercado en el que la empresa desarrolla su actividad y cuyo fin inmediato es proporcionar conocimiento permanente sobre el mismo, para facilitar el proceso de toma de decisiones al trabajar sobre necesidades específicas de la empresa.

8.8. Inteligencia criminal

También este término concita varias interpretaciones y se presta a confusión con otros conceptos, como inteligencia policial, inteligencia de seguridad pública, investigación criminal, criminología, criminalística, etc.

Inicialmente se entendía como inteligencia policial a la destinada al mantenimiento de la seguridad interior, el orden público y la persecución de la delincuencia. Pero desde finales del siglo XX y en este XXI, la inteligencia criminal abarca un ámbito mucho mayor que el estrictamente policial, al constituir una inteligencia que hoy elaboran, en distintos países, los servicios de inteligencia, las fuerzas armadas, unidades policiales, los servicios de aduanas, el sistema penitenciario, las instituciones financieras e incluso empresas privadas de seguridad.

De esta forma, la inteligencia criminal es un tipo de inteligencia útil para obtener, evaluar e interpretar información y difundir inteligencia necesaria para proteger y promover los intereses nacionales de cualquier naturaleza (políticos, comerciales, empresariales), frente al crimen organizado, al objeto de prevenir, detectar y posibilitar la neutralización de aquellas actividades delictivas, grupos o personas que, por su naturaleza, magnitud, consecuencias previsibles, peligrosidad o modalidades, pongan en riesgo, amenacen o atenten contra el ordenamiento constitucional y los derechos y libertades fundamentales.[6]

En cuanto a su diferenciación con la investigación criminal/policial, también identificada como actividad de policía judicial, la diferencia principal estriba en que esta se realiza al suscitarse un caso y se culmina con los logros investigativos obtenidos, alcanzando su esclarecimiento y resolución, mientras que la inteligencia es permanente; no reacciona ante la comisión de un delito, sino que opera continuamente sobre toda persona, actividad u organización que pueda parecer sospechosa de constituirse en una amenaza o implique un riesgo para la seguridad. Cuando hay ausencia de inteligencia o las medidas que propone no se aplican, el delito ya se ha cometido; el trabajo de inteligencia ha resultado infructuoso y el delito efectivamente materializado pasa a ser objeto de la investigación criminal/policial.

Por consiguiente, la inteligencia no persigue la resolución de un hecho delictivo. No opera en el ámbito de los tipos penales, sino en la esfera de las situaciones predelictuales; intenta aportar conocimiento para anticiparse y permitir a las autoridades neutralizar o disuadir las amenazas, riesgos y conflictos (carácter preventivo). La investigación criminal/policial actúa de forma absolutamente represiva, ya que interviene después de la comisión de un delito específico para identificar a sus autores y aportar las pruebas legales que posibiliten su procesamiento penal.

Otro aspecto que facilita la confusión de los términos lo constituye el hecho de que una misma información puede tener una doble finalidad: constituir indicios y pruebas para descubrir los elementos integrantes del hecho criminal para su enjuiciamiento (investigación criminal/policial), o constituir insumos que empleará el analista de inteligencia, que no el investigador policial, en la elaboración del producto de inteligencia, con independencia del momento exacto en el que se produce el conocimiento, sea este anterior o posterior al hecho delictivo. La afluencia continua de nuevos datos fruto de la comisión de delitos genera la imagen errónea de que siempre se llega tarde, resultando infructuoso cualquier esfuerzo por elaborar inteligencia.

Esta confusión se produce porque la fase de recolección de información para la elaboración de inteligencia (policial y criminal) y la fase de recolección de información, indicios y pruebas de la investigación criminal/policial, en muchas ocasiones discurren de forma simultánea versando sobre los mismos objetivos. Esta circunstancia genera confusos episodios de solapamiento al resultar harto complejo establecer las líneas de demarcación entre ambas, para identificar con nitidez donde empieza una y acaba la otra, por lo que el elemento esclarecedor reside en identificar sus utilidades y fines, que sí están bien diferenciados[7].

Por su parte, la inteligencia de seguridad pública, conocida por el acrónimo CRIMINT, puede definirse como la que sirve para identificar y neutralizar las amenazas reales y potenciales a la seguridad del Estado o a su orden constitucional resultante de actos de subversión, terrorismo y espionaje cometidos por personas, Estados o grupos nacionales o extranjeros. Asimismo, este término se aplica a las actividades de apoyo a las funciones de la policía, el mantenimiento del orden público y de la justicia criminal.

También relacionada con la inteligencia criminal y dentro de la CYBINT (ver punto 5.3.1) se encuentra la inteligencia de medios sociales (SOCMINT), que es la que está referida a las redes sociales y medios de comunicación de plataforma digital y los datos que las mismas generan. Contribuye a la seguridad pública a través de la identificación de actividades criminales, de la alerta temprana sobre desórdenes y amenazas al orden público, o a la construcción de conocimiento inmediato en situaciones rápidamente cambiantes. Es un tipo de inteligencia reciente que precisa un desarrollo legal.

8.9. Inteligencia sanitaria

Conocida como MEDINT y de aplicación fundamentalmente militar, es la que se deriva de la obtención y análisis de los elementos de epidemiología y ambientales en una determinada zona, así como los riesgos nucleares, biológicos, químicos y radiológicos (NBQR) para las fuerzas propias; de las capacidades sanitarias disponibles, propias y adversarias; de la infraestructura sanitaria y del personal sanitario existente en el teatro donde se efectúan las operaciones, tanto para su explotación en beneficio propio, como para la atención de la población civil de futuras zonas ocupadas[8].

8.10. Inteligencia de objetivos

Identificada con el acrónimo inglés TARINT es el tipo de inteligencia que facilita la selección de objetivos militares y realiza la evaluación de daños. En el apoyo a la selección de objetivos, trata de describirlos y situarlos. En caso de un objetivo compuesto por varias partes, o conjunto de blancos, indica sus vulnerabilidades, importancia relativa y la elección más conveniente de medios y momento de ataque para producir los efectos deseados. Los aspectos que deciden el ataque a un objetivo son su facilidad para ser identificado, la importancia relativa para contribuir a obtener el resultado final y el cumplimiento de la misión.

La evaluación de daños proporciona la información necesaria para conocer si se han logrado los efectos deseados.

8.11. Inteligencia psicológica

Conocida como PSYOPS es el tipo de inteligencia necesaria para la planificación, conducción y evaluación de las operaciones psicológicas, que proporciona información relativa a opiniones, creencias, actitudes o aspiraciones de las audiencias objetivo, así como sobre aspectos de carácter político, económico, militar, social y cultural de interés para las operaciones y para determinar los efectos que los productos y actividades de las operaciones psicológicas tienen en las audiencias objetivo.

8.12. Inteligencia sociocultural

Identificada por el acrónimo SOCINT, se elabora a partir de la información sobre asuntos sociales, políticos, económicos y demográficos para comprender las creencias, valores, actitudes y comportamientos de un actor o grupo social determinado, con el fin de prevenir y neutralizar amenazas a la seguridad. Es un tipo de inteligencia complementario de otras.

8.13. Inteligencia cultural

Bajo el acrónimo CULINT se identifica la inteligencia elaborada a partir de información social, política, económica y demográfica que proporciona un conocimiento que permite comprender la forma de actuar y las motivaciones de cualquier tipo de actor (aliado, neutral o enemigo), así como anticipar sus reacciones ante determinados acontecimientos. Analiza su cultura para entender mejor su visión del mundo, sus comportamientos y su forma de tomar decisiones. Ello hace posible interpretar mejor sus acciones y, por tanto, diseñar estrategias de cooperación o reacción mucho más efectivas. Es también un tipo de inteligencia identificado recientemente, que se está desarrollando debido a las cada vez más numerosas actividades multinacionales en respuesta a la globalización de las amenazas.

8.14. Inteligencia holística

Es la que se elabora por cualquier servicio que debe abordar el análisis y la interpretación de un asunto o de una situación con una perspectiva multidisciplinar, integrando información proveniente de múltiples fuentes y realizada por un equipo de trabajo de especialidades y procedencias diversas formado exclusivamente para la ocasión.

El concepto de inteligencia holística es relativamente reciente y está motivado por la continua ampliación del concepto de seguridad y, por tanto, el aumento de la complejidad de los asuntos que atienden los servicios de inteligencia, a lo que cabe añadir la sobreabundancia de información que se obtiene por medios técnicos.

Rafael Jiménez Villalonga es Emérito del Centro Nacional de Inteligencia y profesor delMáster on-line en Estudios Estratégicos y Seguridad Internacional de la Universidad de Granada.

Bibliografía

Díaz Fernández, Antonio M. (director): Conceptos fundamentales de inteligencia. Tirant lo Blanch, Valencia, 2016.

Díaz Fernández, Antonio M. (director de obra): Diccionario LID INTELIGENCIA Y SEGURIDAD. LID Editorial Empresarial, 2013.

Esteban Navarro, Miguel Ángel (coordinador): Glosario de inteligencia. Ministerio de Defensa, Madrid, 2007.

González Cussac, José Luis (coordinador): Inteligencia. Tirant lo blanch, Valencia, 2012.

Inteligencia Militar Terrestre-Manual de Fundamentos, Exército Brasileiro, 2015. En línea,http://bdex.eb.mil.br/jspui/bitstream/123456789/95/1/EB20-MF-10.107.pdf(Consultado 24jun2017).

Jiménez Moyano, Francisco. Manual de Inteligencia y Contrainteligencia. CISDE Editorial, 2012.

Kent, Sherman: Strategic Intelligence for American World Policy. Princeton, NJ, 1949. Edición en castellano 4ª Edic.: Buenos Aires, Editorial Pleamar, 1986.

Martre, Henri. Intelligence économique et stratégie de enterprises. Rapport du Commisariat Général au Plan. París. La Documentation franÇaise, 1994. En línea,http://www.entreprises.gouv.fr/files/files/directions_services/informati…. (Consultado 02jul2017).

[1] Kent, Sherman: Strategic Intelligence for American World Policy. Princeton, NJ, 1949. Edición en castellano: 4ª Edic. Buenos Aires, Editorial Pleamar, 1986.

[2] Sánchez Blanco, E.: OSINT (inteligencia de fuentes abiertas), en Díaz Fernández, A. M.:Conceptos fundamentales de inteligencia. Tirant lo blanch, Valencia, 2016, pp. 274-276.

[3] Inteligencia Militar Terrestre-Manual de Fundamentos, Exército Brasileiro, 2015. En línea, http://bdex.eb.mil.br/jspui/bitstream/123456789/95/1/EB20-MF-10.107.pdf(consultado 24jun2017).

[4] Martre, Henri (1994), Intelligence économique et stratégie de enterprises. Rapport du Commisariat Général au Plan. París. La Documentation franÇaise. En línea,http://www.entreprises.gouv.fr/files/files/directions_services/informati…. (Consultado 02jul2017).

[5] Op. cit.

[6] Sansó-Rubert Pascual, D. ¿Inteligencia criminal?: Líneas de demarcación y áreas de confusión. La necesidad de reevaluar su rol en la esfera de la seguridad y en la lucha contra la criminalidad organizada, en Velasco, Fernando y Rubén Arcos (eds.), Cultura de Inteligencia, un elemento para la reflexión y la colaboración internacional, Plaza y Valdés. Madrid. 2012. pp. 347-360.

[7] Sansó-Rubert Pascual, D. Inteligencia criminal, en Díaz Fernández, Antonio, (Dtor).Conceptos fundamentales de inteligencia. Tirant lo blanch. Valencia. 2016. pp. 223-231.

[8] Jiménez Moyano, F. Manual de Inteligencia y Contrainteligencia. CISDE Editorial. 2012. p. 33.

Editado por: Grupo de Estudios en Seguridad Internacional (GESI). Lugar de edición: Granada (España). ISSN: 2340-8421.

Fuente: seguridadinternacional.es, 26/11/18.

Más información:

Inteligencia es anticipación

Antecedentes del Ciclo de Inteligencia de Sherman Kent

La Inteligencia y sus especialidades en la Sociedad del conocimiento

______________________________________________________________________________

______________________________________________________________________________

Vincúlese a nuestras Redes Sociales: LinkedIn YouTube Twitter

______________________________________________________________________________

.

.

La Inteligencia y sus especialidades en la Sociedad del conocimiento

octubre 20, 2023

De los espías a las computadoras, el creciente uso de la inteligencia en el siglo XXI

Por Gustavo Ibáñez Padilla.

Vivimos en un mundo de datos, los cuales crecen día a día en forma exponencial.

Cada transacción, cada interacción, cada acción es registrada y genera a su vez nuevos datos (la hora del registro por ejemplo) llamados metadatos. Todo este creciente cúmulo información puede ahora ser procesado a gran velocidad (big data) a fin de extraer conclusiones.

.

Captar y procesar datos, organizarlos, transformarlos en información y luego en conocimiento para facilitar la toma de decisiones es lo que se conoce como ‘inteligencia’. Hace algún tiempo se consideraba una función estratégica al servicio de las máximas autoridades, para asegurar la defensa de la nación. Así fue en los inicios, cuando se profesionalizó la actividad de la mano de Sherman Kent en los Estados Unidos y dio nacimiento a la agencia central de inteligencia, más conocida como la CIA. Por supuesto no era algo nuevo, ya nos hablaba sobre ello Sun Tzu en el siglo VI antes de Cristo. Pero fueron los estudios de Kent los que le dieron la formalidad de una disciplina, a mediados del siglo pasado.

Con el paso de los años la inteligencia se fue expandiendo al tiempo que crecía la capacidad de procesar información. Así surgieron los adjetivos que califican al sustantivo ‘inteligencia’ para diferenciar su múltiples variedades, llegando entonces a una compleja taxonomía del concepto inteligencia.

Al extender su ámbito la inteligencia se hizo accesible a la sociedad en general y comenzaron a usarla las empresas y organizaciones en general (business intelligence), para esta democratización de sus usos colaboró en forma importante la tremenda baja en los costos de adquisición y procesamiento de la información, que corría al ritmo de los avances informáticos.

Podemos mencionar como casos de éxito de inteligencia de negocios los sistemas de precios dinámicos en las aerolíneas, que acoplan los precios a las variaciones de oferta y demanda; la plataforma de venta online de Amazon, que recomienda otros artículos según los intereses del comprador y Netflix, que sugiere películas y series y orienta el rumbo de las nuevas producciones.

Es así que con la evolución de la disciplina comienzan a solaparse las áreas de influencia de la inteligencia de negocios, con la inteligencia criminal, la inteligencia financiera, la inteligencia estratégica y podríamos seguir hasta el cansancio…

Vemos que con el paso del tiempo el concepto de inteligencia ha ganado fuerza, profundidad, densidad y trascendencia. En una sociedad del conocimiento esto resulta absolutamente lógico y natural.

Pero dejemos ahora el análisis en abstracto y veamos algunos ejemplos concretos que nos muestren el enorme potencial de este concepto.

Imaginemos una organización criminal que comienza a operar una instalación clandestina de marihuana, en los suburbios, mediante el cultivo hidropónico. Esta nueva actividad se evidenciará por un consumo eléctrico superior al usual de una zona residencial, que quedará registrado en las bases de datos de la compañía de electricidad.

.

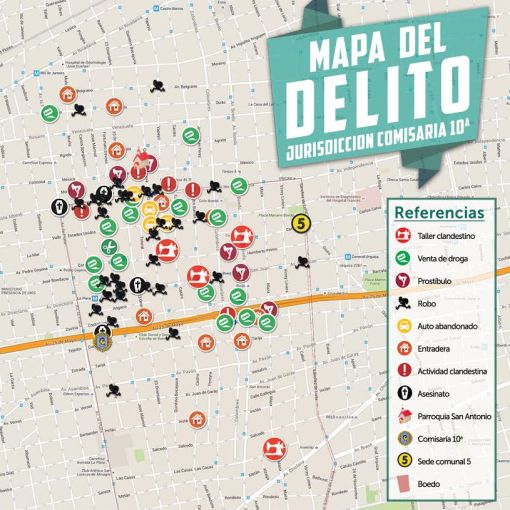

Al mismo tiempo, es probable que el nuevo suministro de droga ilegal a buen precio incremente el tránsito de consumidores y se produzca un aumento de la conflictividad y de delitos menores, lo cual podría percibirse en los registros de un eficiente mapa del delito.

.

También podrían aumentar las consultas a los servicios de guardias de los hospitales de la zona, motivados por un creciente número de intoxicaciones por estupefacientes.

Todas estas pequeñas variaciones en los registros de datos podrían detectarse gracias al eficaz empleo de la inteligencia de negocios, que permite relacionar múltiples bases de datos haciendo evidente la anomalía generada por el nuevo invernadero clandestino.

.

Es interesante prestar atención a que no fue necesario realizar acciones tradicionales de inteligencia criminal, ni disponer de informantes o agentes encubiertos, que realicen las usuales tareas de inteligencia en búsqueda de los narcotraficantes. Tan solo fue preciso disponer de un sistema de información que relacione distintas bases de datos, que registran en forma habitual y monótona inmensas cantidades de información, y de esta forma poner en evidencia la “perturbación” generada por el accionar de los malvivientes.

Vemos como la superposición de inteligencia de negocios con inteligencia criminal permite obtener resultados en forma casi automática y a mucho menor costo.

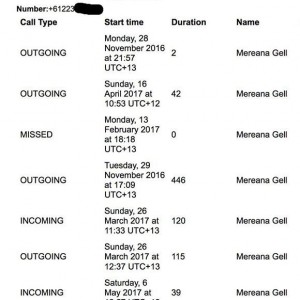

También puede tomarse como ejemplo el cruce de datos de llamadas telefónicas que nos permite evidenciar relaciones entre distintas personas y prácticamente descubrir acciones conspirativas, sin necesidad de conocer el contenido de las comunicaciones y sin tener que recurrir a escuchas judiciales (ej: asesinato del fiscal Alberto Nisman, enero 2015).

.

Evidentemente, la sociedad en general y la seguridad nacional pueden beneficiarse cada día más del empleo de sistemas avanzados de análisis de inteligencia, capaces de explotar de manera eficaz y eficiente los crecientes volúmenes de datos derivados de los omnipresentes sistemas de captación y procesamiento de información.

La inteligencia en todas sus variantes es indispensable para el desempeño óptimo de las empresas y organizaciones en general y el eficaz accionar de las agencias gubernamentales que persiguen al crimen organizado, los grupos terroristas y cualquier otra amenaza contra la nación.

Fuente: Ediciones EP, 2019.

Información sobre Gustavo Ibáñez Padilla

Más información:

¿Qué es la inteligencia criminal?

La geolocalización y la investigación policial

Antecedentes del Ciclo de Inteligencia de Sherman Kent

Business Intelligence aplicada en el análisis de Inteligencia Criminal

______________________________________________________________________________

Vincúlese a nuestras Redes Sociales: LinkedIn YouTube Twitter

______________________________________________________________________________

.

.

.

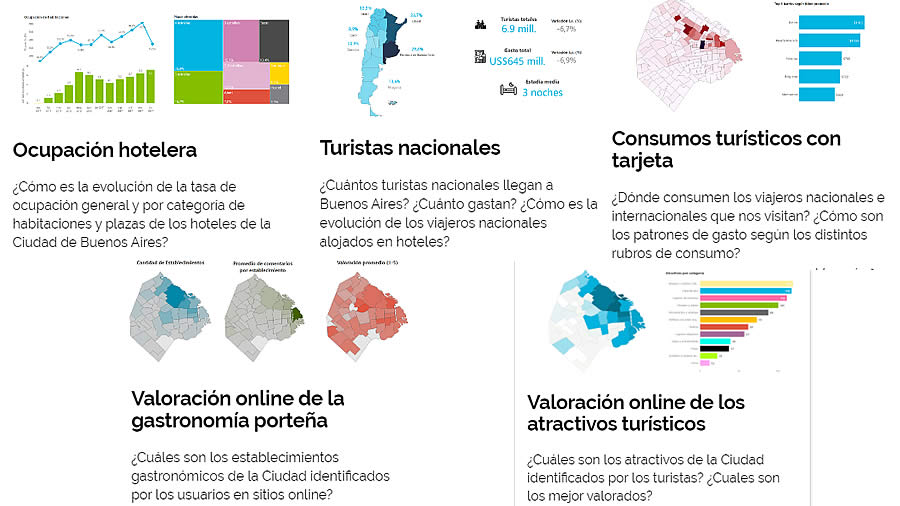

¿Qué es la Inteligencia Turística?

junio 15, 2023

Por Inteligencia Turística hacemos referencia a la utilización de los análisis de datos globales y actualizados al proceso de toma de decisiones en el sector del turismo. Gracias a la utilización de esta información en tiempo real reducimos el margen de error en nuestras futuras iniciativas pudiendo prever futuros desenlaces.

.

La Inteligencia Turística por tanto es la aplicación directa del Big Data, una tecnología que ya desde hace años está teniendo una gran repercusión en las compañías.

Las empresas turísticas disponen día a día de una inmensa cantidad de datos a través de múltiples canales, pudiendo ahora gracias a esta tecnología aprovecharse de esta información valiosa para dar un mejor servicio a sus clientes, aumentar su satisfacción e incrementar los ingresos de la empresa.

Estos datos nos dan una oportunidad para identificar patrones de demanda del viajero a lo largo de todo su proceso de compra, pudiendo adaptarse de esta forma el propio destino.

Gracias a este tipo de herramientas podemos entender el tráfico de turistas y comprender a su vez la cantidad y la calidad de la demanda. Ahora podemos conocer sus pautas de comportamiento digital y a través de estos datos decidir las posteriores estrategias.

La capacidad de medición del Big Data puede ser fundamental para los destinos y para todos los negocios que forman parte de él. Así, cualquier punto de interacción con el viajero puede ser un punto de recogida de datos de satisfacción de nuestros clientes.

El éxito en la gestión de un destino depende en gran parte de la gestión de la información, ya que la calidad del proceso de toma de decisiones se encuentra condicionado por la calidad de la información que tenemos. Frecuentemente, no se toma una decisión adecuada por carecer de datos adecuados, o por la dificultad de analizarlos a tiempo.

.

Para un destino, la cuestión ya no es sólo de disponer de información de valor sobre el entorno, sino disponer de la misma antes que sus potenciales competidores.

Por tanto para competir con otros destinos tenemos la necesidad de diferenciarnos, apoyándonos en el análisis ad hoc de la información para generar conocimiento y crear ventajas competitivas y nuevas oportunidades.

Conociendo el Customer Journey de nuestro huésped podremos personalizar nuestro trato y servicio, fidelizándole y acompañándole desde el momento en que decide viajar, su método de transporte, alojamiento y recomendando servicios/lugares en el destino.

Hay que tener en cuenta que el comportamiento de los viajeros está cambiando, más aún tras el impacto del COVID-19 que ha afectado en gran medida al sector turístico. Tenemos por un lado a los viajeros de negocios y a los vacacionales, o por ejemplo el de las familias, parejas o personas que viajan solas que son diferentes perfiles. Además tenemos dos grandes grupos a tener en cuenta: los resilientes (viajeros que están activamente buscando para poder viajar tan pronto como les sea posible) y los conservadores (que están inseguros y se les tendrá que volver a ganar la confianza para conseguir que tengan ganas de viajar).

Fuente: curieplatform.com, 2021

La Inteligencia Turística es la aplicación del concepto de Inteligencia de Negocios en el área del Turismo.

www.economiapersonal.com.ar

.

¿Qué clases de datos turísticos se analizan?

Existe un enorme y creciente caudal de datos que pueden ser utilizados para identificar y predecir las tendencias turísticas. Éstos se complementan con datos históricos y estadísticos que ya se empleaban tradicionalmente.

En tiempo real se trabaja para agregar fuentes de datos que aportan una visión global y representativa del turismo a nivel mundial. Las siguientes son algunas de las tipologías de datos turísticos estudiadas:

- Datos de Conectividad Aérea: programaciones de vuelos, precios, búsquedas y reservas de vuelos.

- Datos de Comportamiento turístico en Redes Sociales: interacciones espontáneas en Redes que nos muestran tendencias de percepciones e intereses turísticos.

- Datos de Alojamiento: hoteles, alquiler vacacional, precios y comentarios.

- Datos de Gasto: gasto turístico a través de tarjetas de crédito, débito y otros canales de pago.

- Datos de Movilidad: conectividad de dispositivos móviles a las antenas de un destino para cuantificar visitantes y movilidad real de los turistas.

La superposición de todas estas capas de datos permite construir un conocimiento sin precedentes a cerca de las dinámicas turísticas, facilitando las decisiones de los operadores turísticos y mejorando el retorno directo de la inversión.

EP.

Más información:

Inteligencia de Negocios

La Inteligencia y sus especialidades en la Sociedad del conocimiento

La Ciudad de Buenos Aires presentó un nuevo sistema de inteligencia turística

Tableros de Control: https://turismo.buenosaires.gob.ar/es/observatorio

Presentación del sistema: https://youtu.be/C1LBAH2gq2A (Ver desde el minuto 31)

___________________________________________________________________

.

.

.

Propaganda y Contrapropaganda

febrero 16, 2022

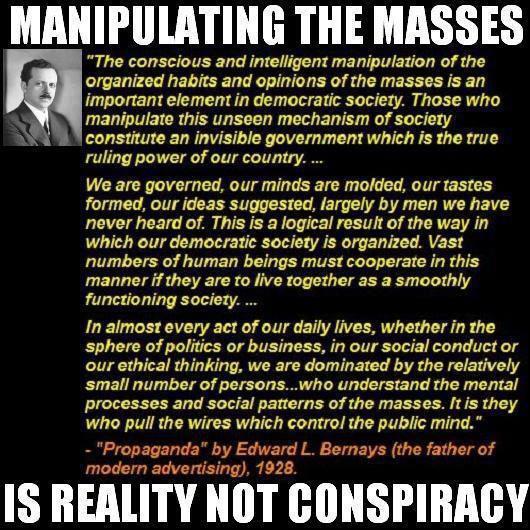

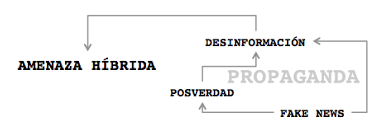

El objetivo de la Propaganda es la consecución, mantenimiento o refuerzo de una posición de poder por parte de un sujeto emisor; la ideología desempeña un papel funcional en el cumplimiento de ese objetivo en tanto que contenido discursivo de la comunicación propagandística.

.

.

La propaganda es una forma de comunicación que pretende influir en la actitud de las personas respecto a alguna causa o posición, presentando solamente un lado de un argumento.

.

.

La Propaganda es un discurso de poder.

.

.

.

.

.

.

Más información:

Rumores y mentiras al estilo Goebbels

Desinformación versus Decepción

Manipulación mediática

Un mundo que cambia. César Vidal

Ciberespionaje, influencia política y desinformación

.

.

Los sesgos cognitivos y la Inteligencia de Negocios

enero 26, 2022

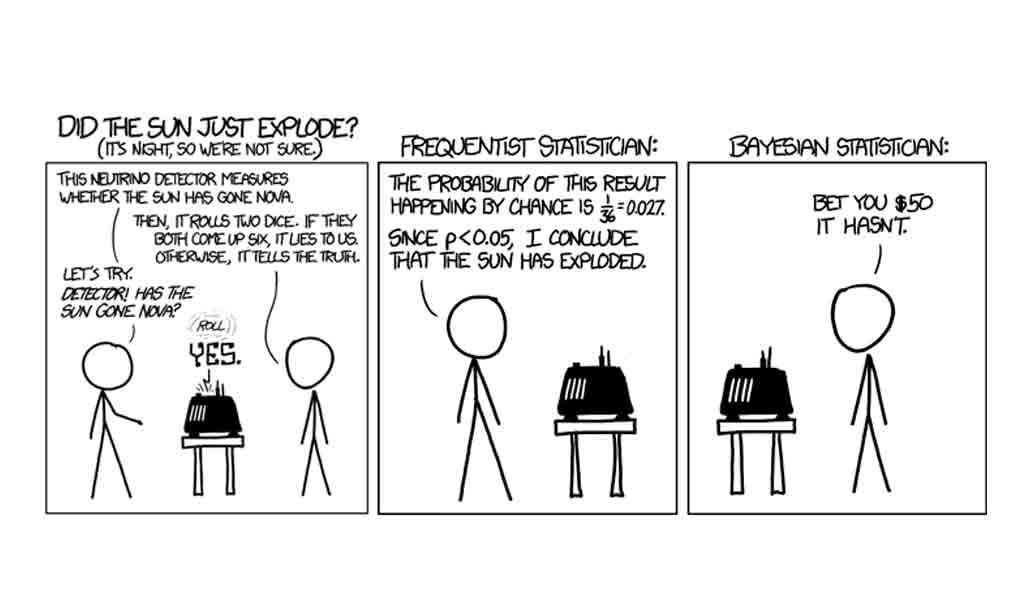

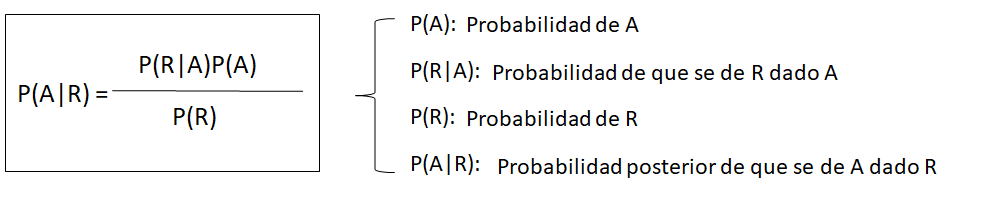

Sesgos Cognitivos en la fase de obtención de Inteligencia

Por Cristina López Tarrida.

Analista e Investigadora especializada en Influencia, Desinformación y Propaganda.

.

Desde que la tecnología ha irrumpido con fuerza en el ámbito de la Inteligencia, cada vez es más frecuente observar cómo existe cierta tendencia en algunos círculos a considerar, equivocadamente, que las herramientas de software constituyen los cimientos sobre los que se sustenta el análisis, relegando a la mente del analista a un mero complemento de dichas herramientas.