El nuevo orden mundial es desolador

junio 15, 2014

Ian Bremmer: «El nuevo orden mundial es bastante desolador».

Por Juan Landaburu

El gurú de la geopolítica cree que los problemas de hoy no tienen solución a la vista por la falta de liderazgo global

Los jihadistas avanzan hacia Bagdad. En Siria, un dictador comete todo tipo de atrocidades para salir ileso de la guerra civil. Ucrania se hunde en un conflicto que amenaza a Europa. El mundo emergente va de protesta en protesta. El cambio climático no encuentra respuestas. Ian Bremmer no tiene dudas: «El orden mundial actual es bastante desolador», dijo a la nacion el presidente de Eurasia Group, la consultora de riesgo político más importante del mundo, y gurú de la geopolítica.

-¿Qué opciones tiene Occidente para combatir el avance jihadista en Irak? ¿Lo que está pasando es consecuencia de una mala estrategia norteamericana?

-Desafortunadamente, Occidente se quedó con muy pocas opciones para combatir el avance jihadista en Irak; hay una severa falta de apoyo popular a cualquier intervención. Algunos de los avances de los extremistas sunnitas pueden achacarse a la política norteamericana en Irak. Instituciones que fueron destruidas e inadecuadamente reconstruidas, o simplemente no reconstruidas, así como el vacío que provocó la retirada militar norteamericana dejaron un espacio en el que los milicianos pudieron expandir sus capacidades.

-Desafortunadamente, Occidente se quedó con muy pocas opciones para combatir el avance jihadista en Irak; hay una severa falta de apoyo popular a cualquier intervención. Algunos de los avances de los extremistas sunnitas pueden achacarse a la política norteamericana en Irak. Instituciones que fueron destruidas e inadecuadamente reconstruidas, o simplemente no reconstruidas, así como el vacío que provocó la retirada militar norteamericana dejaron un espacio en el que los milicianos pudieron expandir sus capacidades.

-La crisis de Ucrania es vista como otra Guerra Fría o el reflejo de un nuevo orden mundial. ¿Cree que es para tanto?

-La crisis en Ucrania constituye probablemente la situación geopolítica más peligrosa que hemos atravesado desde el 11 de Septiembre, pero decir que se trata de un nuevo orden mundial o incluso una Segunda Guerra Fría es una absoluta exageración. Así que la buena noticia es que no nos encaminamos a una Segunda Guerra Fría. La mala es que el orden mundial actual es bastante desolador. Es lo que yo llamo un mundo «G-0» («Grupo de los Cero»), o sea un mundo en el que ningún país o grupo de países quiere o puede asumir un liderazgo global y marcar la agenda internacional. En este escenario, los conflictos como el de Ucrania o Siria arderán con más fuerza, frecuencia y duración.

-¿Cree que la de Obama es la estrategia adecuada para que Estados Unidos revierta el declive de su liderazgo?

-La política exterior, lisa y llanamente, no es su prioridad. En parte, eso se debe a que la opinión pública norteamericana está harta de involucrarse en problemas extranjeros. Su discurso no resuelve ni envía una respuesta clara a la pregunta fundamental que se hacen los aliados -y enemigos- de los norteamericanos: ¿qué representa y que defiende Estados Unidos? Responder a esa pregunta implicaría un compromiso y un accionar, y eso es lo que Estados Unidos no se puede permitir debido a impedimentos que no desaparecen: obstáculos en la política interna, una estructura internacional más dura y un equipo de política exterior más débil en este mandato.

-¿Por qué cree que un mundo G-0 es peor que uno con potencias líderes?

-Hay desafíos que necesitan apoyo de un grupo suficiente de superpotencias para enfrentarlos. Sin un liderazgo mundial coordinado es imposible resolver desafíos como el cambio climático, los Estados díscolos, la proliferación nuclear, o crisis como las de Siria o Ucrania.

-¿China puede llenar ese vacío?

-No, China no está en condiciones por el momento. No tiene capacidad para hacerlo. Es sólo una superpotencia económica que carece de todos los otros ingredientes necesarios, como ser la habilidad diplomática y militar, así como de «poder blando». Incluso en lo económico, a pesar de su crecimiento, su ingreso per cápita sigue muy retrasado. Tampoco quieren ocupar ese espacio de poder, ya que están demasiado ocupados en mantener el crecimiento en su propio país.

-Brasil, Turquía y otros países emergentes han sido escenario de masivas protestas. ¿Qué tienen en común esas protestas?

-Después de 10 años de boom de crecimiento, esos países tienen ahora una clase media más amplia y sólida, y gobernantes de larga data. Esas clases medias ya no se conforman con un éxito económico básico, sino que tienen demandas más sofisticadas, como el cuidado medioambiental, la corrupción y la responsabilidad de gobierno. Y ahora que el crecimiento comenzó a desacelerarse, los gobiernos tienen menos capacidad de cumplir con las expectativas.

-El Papa demuestra mucho interés por la paz entre árabes e israelíes. ¿Puede conducir con éxito un proceso que destrabe las conversaciones?

-Francisco es, de alguna manera, una mejor opción que la mediación de Estados Unidos. Sería visto como un mediador más honesto e imparcial por ambas partes. Pero esas conversaciones seguirían chocando con los mismos obstáculos insalvables: simplemente no existe suficiente consenso entre los líderes para que se llegue a buen puerto.

-¿Considera que es un líder político o un líder espiritual?

-Francisco demostró cierto liderazgo político, y está al frente de una institución con poder e influencia. Las enseñanzas y prioridades de esa institución pueden impulsar el diálogo en muchos países, a veces para bien y otras para mal. Yo diría que fue una de las sorpresas más positivas en el escenario del liderazgo internacional.

-Me gustaría saber cuál es su opinión sobre la Argentina. ¿Por qué fallamos repetidas veces?

-La Argentina es un gran país para vivir, la calidad de vida es excepcional, y uno se siente alejado de los problemas del mundo. Eso contribuye a una sensación de falta de urgencia en la resolución de graves desafíos. Los problemas de la Argentina son mayormente políticos. La debilidad institucional acorta el horizonte temporal de los políticos y facilita bruscos cambios en las políticas, lo que dificulta la consecución de un desarrollo sustentable. La amplia clase media hace que la demanda de gasto [y el populismo] sea elevada. Los recursos naturales y un sector privado habilidoso hacen que el país pueda recuperarse fácilmente de sus crisis, algo que limita los deseos de cambios estructurales que harían que la crisis no se desatara en primer lugar. Las cosas probablemente mejorarán en 2015, y eso podría ayudar a estabilizar la economía, pero el deseo de ajustes y reformas de fondo sigue siendo muy bajo..

Fuente: La Nación, 15/06/14.

Un acertijo chino

junio 15, 2014

Un acertijo chino que resuelven pronto los chicos y complica a los adultos

Lavado de Dinero con empresas fachada y banca on line

junio 15, 2014

Caso de Estudio: Empresa fachada y Banca en línea utilizadas para legitimar dinero en Hong Kong

La antigua colonia británica de Hong Kong enfrenta a poderosas mafias que se valen del comercio internacional, de una moderna estructura financiera y de la “banca online” para legitimar dinero sucio. Incluso muchas veces se aprovechan de la necesidad de las personas para armar esquemas criminales.

El pasado mes de febrero una corte de Hong Kong condenó al joven Luo Juncheng, un chino de 22 años, por haber movilizado € 13 millones de dinero ilícito a través de la banca en línea.

El joven chino creó una empresa y abrió una cuenta bancaria comercial en el Chiyu Banking Corporation, una subsidiaria del Bank of China. A pesar de que todos los documentos estaban a su nombre, el beneficiario final era realmente un sujeto conocido como “Tío Pang”, quien en el pasado había ayudado a Luo pagando las cuentas hospitalarias su fallecido padre.

El “Tío Pang” instruyó al joven a realizar numerosas transferencias de dinero y depósitos con dinero de procedencia ilícita. Durante un período de 8 meses entre 2009 y 2010, el joven realizó 4.800 depósitos y más de 3.500 transferencias utilizando su cuenta empresarial y la plataforma de banca electrónica del Chiyu Banking Corporation.

Es importante estar alerta para detectar este tipo de casos que pueden reflejar un patrón utilizado por los grupos criminales, quienes pueden estar ayudando a personas necesitadas en momentos de crisis, para luego exigirles como pago por los favores recibidos su participación en esquemas de lavado de dinero, fraude y otros delitos.

Aspectos claves de cumplimiento

En este caso hay varios aspectos claves que deben haber sido contemplado por el personal de cumplimiento del banco emisor (Chiyu Banking Corporation) y de los otros bancos que participaron en las miles de transacciones:

-Perfil del Cliente: un joven de solo 22 años que no proviene de familias adineradas, ni posee actividades comerciales conocidas que justifiquen movimientos millonarios en sus cuentas, debe ser manejado como un cliente de alto riesgo desde el mismo momento que se detecta el movimiento de dinero irregular en sus cuentas.

-Empresa Fachada: el personal bancario debe constatar que las nuevas empresas sean realmente firmas reales, que tienen operaciones legítimas.

-Transacciones Sospechosas: difícilmente una empresa nueva pueda realizar más de 10.000 operaciones mensuales por más de un millón de euros. Salvo que el banco encuentre una justificación muy razonable, el personal de cumplimiento debe presentar reportes de operaciones sospechosas asociados al nuevo cliente.

-El Beneficiario Final: uno de los grandes desafíos de cumplimiento es llegar a detectar cuando una persona está siendo utilizada como “testaferro”, “naranja”, “front”… es decir, cuando el titular de una cuenta y supuesto dueño de una empresa no es quien realmente controla las operaciones. En estos casos como el reseñado, los software antilavado que detectan patrones transaccionales son una pieza clave para revelar procesos de estructuración y movimientos de dinero que pueden conducir al verdadero beneficiario final.

-Sistema de Monitoreo: los sistemas automatizados de control y monitoreo de transacciones deben detectar patrones de movimientos excesivos en las cuentas individuales y comerciales, especialmente si el perfil del cliente y el tipo de negocio no justifican un flujo intenso de dinero y de operaciones.

Las debilidades de Hong Kong

Durante los últimos años se ha señalado a Hong Kong como uno de los centros financieros más riesgosos del mundo asiático. El pasado año las autoridades implementaron una ley antilavado de dinero y contra el financiamiento del terrorismo, como respuesta a las críticas emitidas por el Grupo de Acción Financiera.

El aumento de las operaciones asociadas al lavado de dinero en Hong Kong y las condenas poco severas contempladas para los delitos financieros han blanco de críticas. Así lo señaló la misma jueza Esther Toh, mientras dictaba sentencia contra el joven Luo Juncheng: «El ejecutivo de Hong Kong podría considerar la institución de penas más severas», para que se mantenga la reputación como centro financiero íntegro”.

Otro de los grandes desafíos del centro financiero asiático es el gran movimiento de dinero producto de la corrupción de los funcionarios públicos de China, quienes movilizan gran cantidad de transacciones a través del sistema bancario de Hong Kong, valiéndose principalmente de su moderna banca electrónica.

Según indicaron las autoridades, durante el año pasado los sujetos obligados presentaron 20.287 reportes de operaciones sospechosas.

Fuente: LavadoDinero.com, 31/01/13.

Amado Boudou y la corrupción K

junio 14, 2014

Amado Boudou: causas y consecuencias.

Por Jorge Lanata.

Enfrascados en las idas y vueltas del affaire Ciccone, nadie le pregunta a Boudou por la causa que se le instruye en paralelo: la de enriquecimiento ilícito.

Enfrascados en las idas y vueltas del affaire Ciccone, nadie le pregunta a Boudou por la causa que se le instruye en paralelo: la de enriquecimiento ilícito.

La fortuna del vicepresidente aumentó un 300% en poco más de tres años.

Por el departamento que alquila desde el 2009 en el séptimo piso I de Madero Center, donde vive con su novia Agustina Kampfer, el vicepresidente acordó pagar 3.000 dólares mensuales con cotización al tipo de cambio de Montevideo, a lo que hay que sumarle unos 6.000 pesos de expensas comunes. Boudou alquila este departamento a la firma Searen S.A., casualmente socia de London Supply, la compañía que puso 1.800.000 pesos para levantar la quiebra de Ciccone. Boudou vive acorralado por las casualidades. Amado Rubén Boudou, su padre, salió de garante de su hijo con un departamento que compró en 2009 en Puerto Madero, en el edificio Madero Bayres, donde el metro cuadrado cotiza en unos 4.500 dólares. Don Amadeo Rubén está jubilado y cobra 1.700 pesos al mes. El y su mujer son investigados a requerimiento del fiscal Di Lello, ya que la figura de enriquecimiento ilícito habla también de “personas interpuestas”, esto es testaferros que puedan haber colaborado con el funcionario. Juan Bautista Boudou, su hermano, también quedó en la mira por los viajes al extranjero pagados por The Old Fund, controlante de Ciccone hasta su expropiación. Boudou justifica parte de sus ingresos en las ganancias de las dos empresas que declara, Aspen y Habitat Natural, ambas en sociedad con su mejor amigo, Nariga Núñez Carmona. Pero esas ganancias deberían reflejarse en la facturación y en los libros diarios de contabilidad de las empresas: eso es lo que analiza el juez Lijo.

Los legisladores Graciela Ocaña y Manuel Garrido denunciaron judicialmente a Boudou por falsear la información de su declaración jurada de bienes. “La diferencia de los activos declarados entre 2007 y 2011 asciende a la suma de 2.071.773 pesos, la diferencia de los pasivos es de 3.755.741 pesos, y la diferencia entre los patrimonios declarados asciende a un total de 1.316.031”. “Los activos del vicepresidente sufrieron un aumento del 714,93%, pasando de escasos 236.000 pesos a más de 1.680.000”, afirman Ocaña y Garrido. Otra cuestión que señalan es la “grosera inclusión” de viáticos oficiales en pesos y en dólares como parte del patrimonio, para intentar justificar su evolución patrimonial. En un escrito declara 180.900 pesos por este concepto, pero nunca los declaró ante la Oficina Anticorrupción.

Según el expediente que instruye el juez Lijo, en el acta correspondiente al 10 de enero de 2012 del directorio de la empresa Aspen S.A., el accionista Núñez Carmona toma la palabra y dice “Es de público y notorio conocimiento por parte de este directorio que las firmas Rock Argentina S.A.; WSM S.A.; Beaver Cheek S.A.; Embarcaciones Argentinas S.A. y Action Media S.A., que se encuentran comercialmente vinculadas a Aspen, han gestionado ante el Banco Macro el otorgamiento de asistencias crediticias… etc”. Lo suficientemente claro como para preguntarse si las empresas de Boudou y Núñez Carmona no son dos sino siete, y también para entender por qué, a la hora de sugerir el rumbo de la ruta del dinero, Boudou mencionó solamente a Moneta y no a Jorge Brito. El expediente por enriquecimiento ilícito tiene sobradas pruebas de los incrementos patrimoniales injustificados del vicepresidente desde el 2007, año en que duplicó su patrimonio respecto al 2006, lo mismo que en 2008 respecto al año anterior.

Coincidentemente, de las declaraciones juradas aportadas por la AFIP se desprende que el patrimonio de Núñez Carmona se incrementó en el mismo período un 836%. Esto permite inferir que durante 2010/2011, los años en que Boudou se desempeñó como ministro de Economía, también se observaron incrementos millonarios en el patrimonio de su socio, Núñez Carmona.

Otra de las empresas investigadas, WSM, en 2007 cambió su razón social a “servicios de publicidad”, y se mudó a Belgrano 2115 piso 12 depto B, antiguo domicilio personal de Boudou. Durante el segundo semestre de 2011 recibió en concepto de publicidad en vía pública 1.815.000 pesos, en el primer semestre de 2012 fueron 3.267.403 pesos, y en el segundo semestre de ese mismo año 453.750 pesos. WSM no tiene personal registrado y, al parecer, resulta una empresa vehículo para traspasar fondos al vicepresidente.

De ser así, la Justicia debería preguntarse por la eventual complicidad de quien entonces repartía la pauta oficial, el jefe de Gabinete Juan Manuel Abal Medina.

¿Podrán responder a estas preguntas el vicepresidente o su socio, Nariga Núñez Carmona? Este último fue citado a declarar el jueves, pero aún hoy se desconoce su paradero y se presume que viajó al exterior la semana pasada. ¿Volverá al país?

Investigación: JL/María Eugenia Duffard/Amelia Cole

Fuente: Clarín, 14/06/14

El Impuesto a las Ganancias es un robo

junio 14, 2014

Impuesto al salario y voracidad fiscal extrema

El perdurable y confiscatorio impuesto a las ganancias provoca enormes

inequidades como resultado de una gestión estatal ineficiente y manipuladora

La voracidad fiscal que corre detrás de un gasto público desbordado se manifiesta hoy muy crudamente en el impuesto a las ganancias. Lo perciben no sólo las empresas impedidas de hacer ajuste por inflación de sus balances, sino también los asalariados que, en número cada vez mayor, superan el mínimo no imponible. El gobierno nacional no sólo falseó la medición de la inflación durante siete años, sino que ignoró sus propios índices en la necesaria actualización de los parámetros y las escalas aplicables para la determinación del impuesto. En todo caso, lo ha hecho tardíamente y en forma muy insuficiente. Además, todavía no ha tenido en cuenta que con una inflación que supera el 35 por ciento anual, las utilidades de las sociedades medidas en sus balances pueden ser inexistentes y el gravamen que se pague sobre ellas implica la cesión al fisco de una parte del capital.

La voracidad fiscal que corre detrás de un gasto público desbordado se manifiesta hoy muy crudamente en el impuesto a las ganancias. Lo perciben no sólo las empresas impedidas de hacer ajuste por inflación de sus balances, sino también los asalariados que, en número cada vez mayor, superan el mínimo no imponible. El gobierno nacional no sólo falseó la medición de la inflación durante siete años, sino que ignoró sus propios índices en la necesaria actualización de los parámetros y las escalas aplicables para la determinación del impuesto. En todo caso, lo ha hecho tardíamente y en forma muy insuficiente. Además, todavía no ha tenido en cuenta que con una inflación que supera el 35 por ciento anual, las utilidades de las sociedades medidas en sus balances pueden ser inexistentes y el gravamen que se pague sobre ellas implica la cesión al fisco de una parte del capital.

La legislación dictada en la convertibilidad, aún vigente, impide los ajustes automáticos. Por ese motivo, mediante una ley de 2011, el Congreso Nacional facultó al Poder Ejecutivo a aumentar los montos establecidos en el artículo 23 de la ley del impuesto a las ganancias. Ya a fines de 2009 se había derogado la famosa «tablita de Machinea», que imponía deducciones decrecientes del impuesto a las ganancias en función de niveles de ingreso. Las escalas habían sido superadas por la realidad y agravaban la incidencia sobre los trabajadores. La evidencia de un proceso inflacionario y el retraso del mínimo no imponible motivaron la delegación de la mencionada ley 26,731, que luego el Poder Ejecutivo no utilizó como era debido.

En las últimas semanas, fracasaron sucesivos intentos de legisladores nacionales de la oposición de avanzar con un reclamo al gobierno nacional para que modifique el confiscatorio impuesto a las ganancias. Fue el kirchnerismo el que sistemáticamente impidió que se concretara cualquier tipo de sesión para debatir una reforma tributaria y elevar el mínimo no imponible de ganancias.

Como se sabe, a fin de este mes los asalariados recibirán medio aguinaldo junto con su sueldo. Un trabajador casado, con dos hijos y un haber mensual bruto de 16.000 pesos, sufrirá una retención por el impuesto a las ganancias de 940 pesos. El fisco se llevará el 14% de su medio aguinaldo. Si el sueldo fuera de 25.000 pesos, la retención sería del 58%. Sorpresas tan injustas como éstas pueden surgir, para algunos, en un mes en que se realizan horas extras o se recibe una bonificación.

Para otros, esto ya ha pasado a ser una triste constante que se repite mes tras mes. En muchos casos se ha dado la paradoja de que no conviene lograr remuneraciones extraordinarias y tampoco un ascenso. Muchos hoy se preguntan si trabajan para alimentar a su familia o a un Estado deficiente y elefantiásico que tampoco logra satisfacer sus necesidades de seguridad, educación, salud o vivienda.

Tradicionalmente, muchos trabajadores destinaban el sueldo anual complementario a la compra de bienes durables, a refacciones en las viviendas o simplemente al ahorro, entre otros destinos. Hoy, la inflación que el Gobierno pretende ocultar, sumada a la falta de actualización de las escalas, diluirá una parte importante del ingreso que, en muchos casos, sólo les hubiera permitido ponerse al día con las deudas contraídas porque el sueldo no permite llegar mínimamente a fin de mes.

El impuesto a las ganancias deriva del impuesto a los réditos, creado en 1934 como un recurso transitorio y extraordinario para superar una estrechez presupuestaria. Su supuesta transitoriedad trocó en permanencia y la alícuota aplicada creció consistentemente. Nunca fue imaginado como un impuesto al salario, aunque posteriormente y en los hechos ese tipo de ingreso fue abarcado por la llamada cuarta categoría. La denominación posterior de impuesto «a las ganancias» intentó respetar el propósito de sólo gravar rentas del capital o utilidades empresarias. Este propósito queda absolutamente desvirtuado cuando el gravamen recae en sueldos que apenas son suficientes para una vida decorosa de un trabajador.

Fuente: La Nación, 14/06/14. Editorial.

Red social

junio 14, 2014

Red social

Fuente: Wikipedia, Marzo 2013.

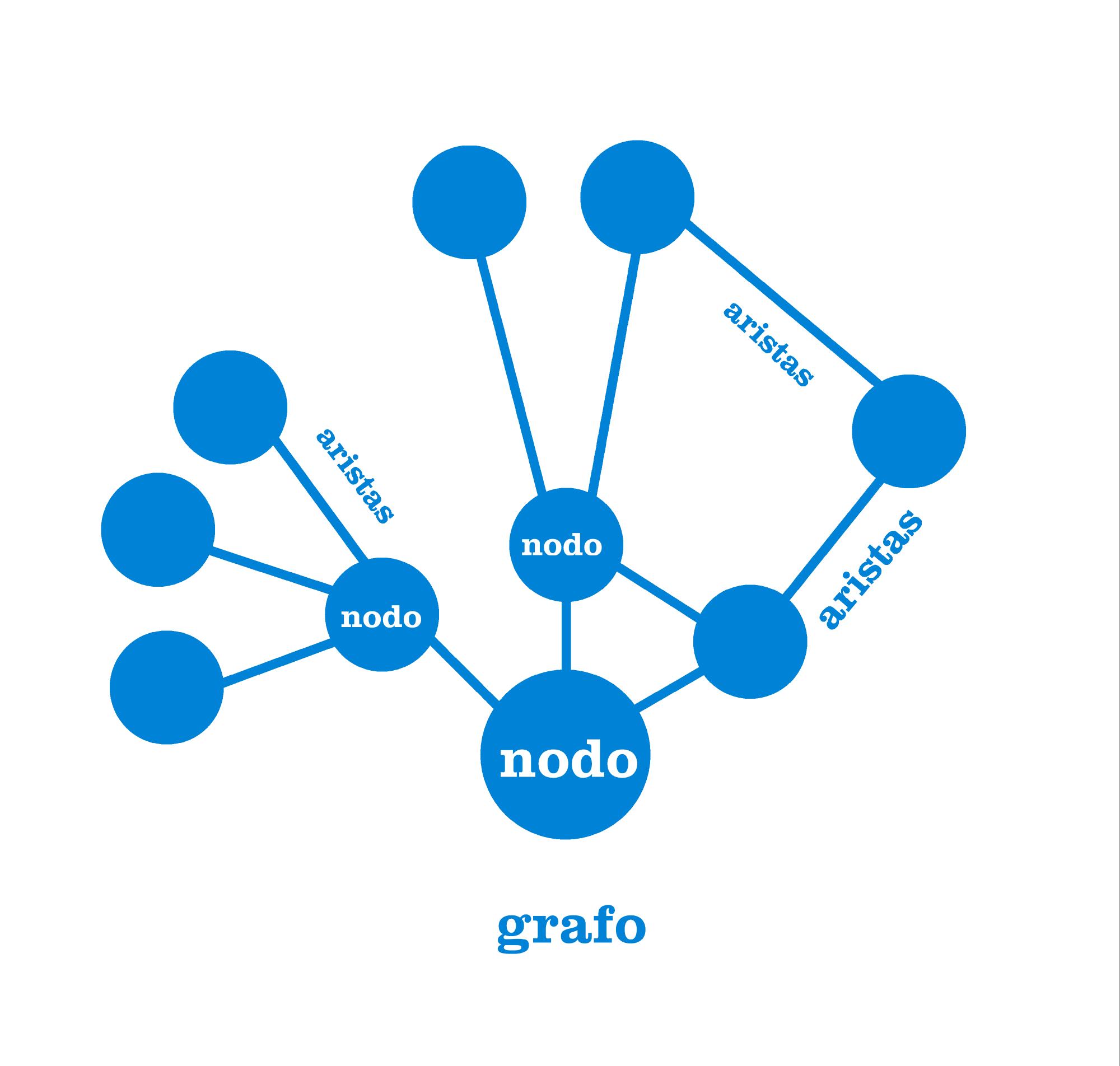

Una red social es una estructura social compuesta por un conjunto de actores (tales como individuos u organizaciones) que están conectados por díadas denominadas lazos interpersonales, que se pueden interpretar como relaciones de amistad, parentesco, entre otros.

La investigación multidisciplinar ha mostrado que las redes sociales operan en muchos niveles, desde las relaciones de parentesco hasta las relaciones de organizaciones a nivel estatal (se habla en este caso de redes políticas), desempeñando un papel crítico en la determinación de la agenda política y el grado en el cual los individuos o las organizaciones alcanzan sus objetivos o reciben influencias.

El análisis de redes sociales estudia esta estructura social aplicando la teoría de grafos e identificando las entidades como «nodos» o «vértices» y las relaciones como «enlaces» o «aristas». La estructura del grafo resultante es a menudo muy compleja. Como se ha dicho, En su forma más simple, una red social es un mapa de todos los lazos relevantes entre todos los nodos estudiados. Se habla en este caso de redes «socio céntricas» o «completas». Otra opción es identificar la red que envuelve a una persona (en los diferentes contextos sociales en los que interactúa); en este caso se habla de «red personal».

La red social también puede ser utilizada para medir el capital social (es decir, el valor que un individuo obtiene de los recursos accesibles a través de su red social). Estos conceptos se muestran, a menudo, en un diagrama donde los nodos son puntos y los lazos, líneas.

Red social también se suele referir a las plataformas en Internet. Las redes sociales de internet cuyo propósito es facilitar la comunicación y otros temas sociales en el sitio web.

Análisis de redes sociales

Ejemplo de un diagrama de una red social conocido como grafo social. El nodo con la más alta intermediación centralidad está marcado en amarillo.

El Análisis de redes sociales (relacionado con la teoría de redes) ha emergido como una metodología clave en las modernas Ciencias Sociales, entre las que se incluyen la sociología, la antropología, la psicología social, la economía, la geografía, las Ciencias políticas, la cienciometría, los estudios de comunicación, estudios organizacionales y la sociolingüística. También ha ganado un apoyo significativo en la física y la biología entre otras.

En el lenguaje cotidiano se ha utilizado libremente la idea de «red social» durante más de un siglo para denotar conjuntos complejos de relaciones entre miembros de los sistemas sociales en todas las dimensiones, desde el ámbito interpersonal hasta el internacional. En 1954, el antropólogo de la Escuela de Manchester J. A. Barnes comenzó a utilizar sistemáticamente el término para mostrar patrones de lazos, abarcando los conceptos tradicionalmente utilizados por los científicos sociales: grupos delimitados (p.e., tribus, familias) y categorías sociales (p.e., género, etnia). Académicos como S.D. Berkowitz, Stephen Borgatti, Ronald Burt, Kathleen Carley, Martin Everett, Katherine Faust, Linton Freeman, Mark Granovetter, David Knoke, David Krackhardt, Peter Marsden, Nicholas Mullins, Anatol Rapoport, Stanley Wasserman, Barry Wellman, Douglas R. White y Harrison White expandieron el uso del análisis de redes sociales sistemático.[1]

El análisis de redes sociales ha pasado de ser una metáfora sugerente para constituirse en un enfoque analítico y un paradigma, con sus principios teóricos, métodos de software para análisis de redes sociales y líneas de investigación propios. Los analistas estudian la influencia del todo en las partes y viceversa, el efecto producido por la acción selectiva de los individuos en la red; desde la estructura hasta la relación y el individuo, desde el comportamiento hasta la actitud. Como se ha dicho estos análisis se realizan bien en redes completas, donde los lazos son las relaciones específicas en una población definida, o bien en redes personales (también conocidas como redes egocéntricas, aunque no son exactamente equiparables), donde se estudian «comunidades personales».[2] La distinción entre redes totales/completas y redes personales/egocéntricas depende mucho más de la capacidad del analista para recopilar los datos y la información. Es decir, para grupos tales como empresas, escuelas o sociedades con membrecía, el analista espera tener información completa sobre quien está en la red, siendo todos los participantes egos y alteri potenciales. Los estudios personales/egocéntricos son conducidos generalmente cuando las identidades o egos se conocen, pero no sus alteri. Estos estudios permiten a los egos aportar información sobre la identidad de sus alteri y no hay la expectativa de que los distintos egos o conjuntos de alteri estén vinculados con cada uno de los otros.

Una red construida a partir de una bola de nieve se refiere a la idea de que los alteri son identificados en una encuesta por un conjunto de Egos iniciales (oleada cero) y estos mismos alteri se convierten en egos en la oleada 1 y nombran a otros alteri adicionales y así sucesivamente hasta que el porcentaje de alteri nuevos empieza a disminuir. Aunque hay varios límites logísticos en la conducción de estudios de bola de nieve, hay desarrollo recientes para examinar redes híbridas, según el cual egos en redes completas pueden nombrar a alteri que de otro modo no estarían identificados, posibilitando que éstos sean visibles para todos los egos de la red.[3] La red híbrida, puede ser valiosa para examinar redes totales/completas sobre las que hay la expectativa de incluir actores importantes más allá de los identificados formalmente. Por ejemplo, los empleados de una compañía a menudo trabajan con consultores externos que son parte de una red que no pueden definir totalmente antes de la recolección de datos.

En el análisis de redes sociales, se distinguen varias tendencias analíticas:[4]

No se parte de la hipótesis de que los grupos son los bloques en la sociedad: el enfoque está abierto a estudiar sistemas sociales menos definidos, desde comunidades no locales, hasta enlaces a través de websites.

En lugar de tratar a los individuos (personas, organizaciones, estados) como unidades discretas de análisis, se centra en cómo la estructura de las relaciones afecta a los individuos y sus relaciones.

En contraste con los análisis que asumen que la socialización de las normas determina el comportamiento, el análisis de redes se utiliza para observar el grado en que la estructura y composición de las relaciones entre los individuos afectan a las normas.

La forma de una red social ayuda a determinar la utilidad de la red para sus individuos. Las redes más pequeñas y más estrictas, pueden ser menos útiles para sus miembros que las redes con una gran cantidad de conexiones sueltas (vínculo débil) con personas fuera de la red principal. Las redes más abiertas, con muchos vínculos y relaciones sociales débiles, tienen más probabilidades de presentar nuevas ideas y oportunidades a sus miembros que las redes cerradas con muchos lazos redundantes. En otras palabras, un grupo de amigos que sólo hacen cosas unos con otros ya comparten los mismos conocimientos y oportunidades. Un grupo de individuos con conexiones a otros mundos sociales es probable que tengan acceso a una gama más amplia de información. Es mejor para el éxito individual tener conexiones con una variedad de redes en lugar de muchas conexiones en una sola red. Del mismo modo, los individuos pueden ejercer influencia o actuar como intermediadores en sus redes sociales, de puente entre dos redes que no están directamente relacionadas (conocido como llenar huecos estructurales).[5]

El poder de análisis de redes sociales estriba en su diferencia de los estudios tradicionales en las Ciencias Sociales, que asumen que los atributos de cada uno de los actores -ya sean amistosos o poco amistosos, inteligentes o tontos, etc- es lo que importa. El análisis de redes sociales produce una visión a la vez alternativa y complementaria, en la cual los atributos de los individuos son menos importantes que sus relaciones y sus vínculos con otros actores dentro de la red. Este enfoque ha resultado ser útil para explicar muchos fenómenos del mundo real, pero deja menos espacio para la acción individual y la capacidad de las personas para influir en su éxito, ya que gran parte se basa en la estructura de su red.

Las redes sociales también se han utilizado para examinar cómo las organizaciones interactúan unas con otras, caracterizando las múltiples conexiones informales que vinculan a los ejecutivos entre si, así como las asociaciones y conexiones entre los empleados de diferentes organizaciones. Por ejemplo, el poder dentro de las organizaciones, a menudo proviene más del grado en que un individuo dentro de una red se encuentra en el centro de muchas relaciones, que de su puesto de trabajo real. Las redes sociales también juegan un papel clave en la contratación, en el éxito comercial y en el desempeño laboral. Las redes son formas en las cuales las empresas recopilan información, desalientan la competencia, y connivencia en la fijación de precios o políticas.[6]

Linton Freeman ha escrito la historia del progreso de las redes sociales y del análisis de redes sociales.[7]

Los precursores de las redes sociales, a finales del siglo XVIII incluyen a Émile Durkheim y a Ferdinand Tönnies. Tönnies argumentó que los grupos sociales pueden existir bien como lazos sociales personales y directos que vinculan a los individuos con aquellos con quienes comparte valores y creencias (gemeinschaft), o bien como vínculos sociales formales e instrumentales (gesellschaft). Durkheim aportó una explicación no individualista al hecho social, argumentando que los fenómenos sociales surgen cuando los individuos que interactúan constituyen una realidad que ya no puede explicarse en términos de los atributos de los actores individuales. Hizo distinción entre una sociedad tradicional -con «solidaridad mecánica»- que prevalece si se minimizan las diferencias individuales; y una sociedad moderna -con «solidaridad orgánica»- que desarrolla cooperación entre individuos diferenciados con roles independientes.

Por su parte, Georg Simmel a comienzos del siglo XX, fue el primer estudioso que pensó directamente en términos de red social. Sus ensayos apuntan a la naturaleza del tamaño de la red sobre la interacción y a la probabilidad de interacción en redes ramificadas, de punto flojo, en lugar de en grupos.

Después de una pausa en las primeras décadas del siglo XX, surgieron tres tradiciones principales en las redes sociales. En la década de 1930, Jacob L. Moreno fue pionero en el registro sistemático y en el análisis de la interacción social de pequeños grupos, en especial las aulas y grupos de trabajo (sociometría), mientras que un grupo de Harvard liderado por W. Lloyd Warner y Elton Mayo exploró las relaciones interpersonales en el trabajo. En 1940, en su discurso a los antropólogos británicos, A.R. Radcliffe-Brown instó al estudio sistemático de las redes.[8] Sin embargo, tomó unos 15 años antes de esta convocatoria fuera seguida de forma sistemática.

El Análisis de redes sociales se desarrolló con los estudios de parentesco de Elizabeth Bott en Inglaterra entre los años 1950, y con los estudios de urbanización del grupo de antropólogos de la Universidad de Manchester (acompañando a Max Gluckman y después a J. Clyde Mitchell) entre los años 1950 y 1960, investigando redes comunitarias en el sur de África, India y el Reino Unido. Al mismo tiempo, el antropólogo británico Nadel SF Nadel codificó una teoría de la estructura social que influyó posteriormente en el análisis de redes.[9]

Entre los años 1960 y 1970, un número creciente de académicos trabajaron en la combinación de diferentes temas y tradiciones. Un grupo fue el de Harrison White y sus estudiantes en el Departamento de Relaciones Sociales de la Universidad de Harvard: Ivan Chase, Bonnie Erickson, Harriet Friedmann, Mark Granovetter, Nancy Howell, Joel Levine, Nicholas Mullins, John Padgett, Michael Schwartz y Barry Wellman. Otras personas importantes en este grupo inicial fueron Charles Tilly, quien se enfocó en redes en sociología política y movimientos sociales, y Stanley Milgram, quien desarrolló la tesis de los «seis grados de separación».[10] Mark Granovetter y Barry Wellman están entre los antiguos estudiantes de White que han elaborado y popularizado el análisis de redes sociales.[11]

Pero el grupo de White no fue el único. En otros lugares, distintos académicos desarrollaron un trabajo independiente significativo: científicos sociales interesados en aplicaciones matemáticas de la Universidad de California Irvine en torno a Linton Freeman, incluyendo a John Boyd, Susan Freeman, Kathryn Faust, A. Kimball Romney y Douglas White; analistas cuantitativos de la Universidad de Chicago, incluyendo a Joseph Galaskiewicz, Wendy Griswold, Edward Laumann, Peter Marsden, Martina Morris, y John Padgett; y académicos de la comunicación en la Universidad de Michigan, incluyendo a Nan Lin y Everett Rogers. En la década de 1970, se constituyó un grupo de sociología sustantiva orientada de la Universidad de Toronto, en torno a antiguos estudiantes de Harrison White: S.D. Berkowitz, Harriet Friedmann, Nancy Leslie Howard, Nancy Howell, Lorne Tepperman y Barry Wellman, y también los acompañó el señalado modelista y teorético de los juegos Anatol Rapoport. En términos de la teoría, criticó el individualismo metodológico y los análisis basados en grupos, argumentando que ver el mundo desde la óptica de las redes sociales ofrece un apalancamiento más analítico.[12]

Investigación

El análisis de redes sociales se ha utilizado en epidemiología para ayudar a entender cómo los patrones de contacto humano favorecen o impiden la propagación de enfermedades como el VIH en una población. La evolución de las redes sociales a veces puede ser simulada por el uso de modelos basados en agentes, proporcionando información sobre la interacción entre las normas de comunicación, propagación de rumores y la estructura social.

El análisis de redes sociales también puede ser una herramienta eficaz para la vigilancia masiva – por ejemplo, el Total Information Awareness realizó una investigación a fondo sobre las estrategias para analizar las redes sociales para determinar si los ciudadanos de EE.UU. eran o no amenazas políticas.

La teoría de difusión de innovaciones explora las redes sociales y su rol en la influencia de la difusión de nuevas ideas y prácticas. El cambio en los agentes y en la opinión del líder a menudo tienen un papel más importante en el estímulo a la adopción de innovaciones, a pesar de que también intervienen factores inherentes a las innovaciones.

Por su parte, Robin Dunbar sugirió que la medída típica en una red egocéntrica está limitado a unos 150 miembros, debido a los posibles límites de la capacidad del canal de la comunicación humana. Esta norma surge de los estudios transculturales de la sociología y especialmente de la antropología sobre la medida máxima de una aldea (en el lenguaje moderno mejor entendido como una ecoaldea). Esto está teorizado en la psicología evolutiva, cuando afirma que el número puede ser una suerte de límite o promedio de la habilidad humana para reconocer miembros y seguir hechos emocionales con todos los miembros de un grupo. Sin embargo, este puede deberse a la intervención de la economía y la necesidad de seguir a los «polizones», lo que hace que sea más fácil en grandes grupos sacar ventaja de los beneficios de vivir en una comunidad sin contribuir con esos beneficios.

Mark Granovetter encontró en un estudio que un número grande de lazos débiles puede ser importante para la búsqueda de información y la innovación. Los cliques tienen una tendencia a tener opiniones más homogéneas, así como a compartir muchos rasgos comunes. Esta tendencia homofílica es la razón por la cual los miembros de las camarillas se atraen en primer término. Sin embargo, de forma parecida, cada miembro del clique también sabe más o menos lo que saben los demás. Para encontrar nueva información o ideas, los miembros del clique tendrán que mirar más allá de este a sus otros amigos y conocidos. Esto es lo que Granovetter llamó «la fuerza de los lazos débiles».

Hay otras aplicaciones del término red social. Por ejemplo, el Guanxi es un concepto central en la sociedad china (y otras culturas de Asia oriental), que puede resumirse como el uso de la influencia personal. El Guanxi puede ser estudiado desde un enfoque de red social.[13]

El fenómeno del mundo pequeño es la hipótesis sobre que la cadena de conocidos sociales necesaria para conectar a una persona arbitraria con otra persona arbitraria en cualquier parte del mundo, es generalmente corta. El concepto dio lugar a la famosa frase de seis grados de separación a partir de los resultados del «experimento de un mundo pequeño» hecho en 1967 por el psicólogo Stanley Milgram. En el experimento de Milgram, a una muestra de individuos EE.UU. se le pidió que hiciera llegar un mensaje a una persona objetivo en particular, pasándolo a lo largo de una cadena de conocidos. La duración media de las cadenas exitosas resultó ser de unos cinco intermediarios, o seis pasos de separación (la mayoría de las cadenas en este estudio ya no están completas). Los métodos (y la ética también) del experimento de Milgram fueron cuestionados más tarde por un estudioso norteamericano, y algunas otras investigaciones para replicar los hallazgos de Milgram habrían encontrado que los grados de conexión necesarios podrían ser mayores.[14] Investigadores académicos continúan exploranto este fenómeno dado que la tecnología de comunicación basada en Internet ha completado la del teléfono y los sistemas postales disponibles en los tiempos de Milgram. Un reciente experimento electrónico del mundo pequeño en la Universidad de Columbia, arrojó que cerca de cinco a siete grados de separación son suficientes para conectar cualesquiera dos personas a través de e-mail.[15]

Los grafos de colaboración pueden ser utilizados para ilustrar buenas y malas relaciones entre los seres humanos. Un vínculo positivo entre dos nodos denota una relación positiva (amistad, alianza, citas) y un vínculo negativo entre dos nodos denota una relación negativa (odio, ira). Estos gráficos de redes sociales pueden ser utilizados para predecir la evolución futura de la gráfica. En ellos, existe el concepto de ciclos «equilibrados» y «desequilibrados». Un ciclo de equilibrio se define como aquél donde el producto de todos los signos son positivos. Los gráficos balanceados representan un grupo de personas con muy poca probabilidad de cambio en sus opiniones sobre las otras personas en el grupo. Los gráficos desequilibrados representan un grupo de individuo que es muy probable que cambie sus opiniones sobre los otros en su grupo. Por ejemplo, en un grupo de 3 personas (A, B y C) donde A y B tienen una relación positiva, B y C tienen una relación positiva, pero C y A tienen una relación negativa, es un ciclo de desequilibrio. Este grupo es muy probable que se transforme en un ciclo equilibrado, tal que la B sólo tiene una buena relación con A, y tanto A como B tienen una relación negativa con C. Al utilizar el concepto de ciclos balanceados y desbalanceados, puede predecirse la evolución de la evolución de un grafo de red social.

Un estudio ha descubierto que la felicidad tiende a correlacionarse en redes sociales. Cuando una persona es feliz, los amigos cercanos tienen una probabilidad un 25 por ciento mayor de ser también felices. Además, las personas en el centro de una red social tienden a ser más feliz en el futuro que aquellos situados en la periferia. En las redes estudiadas se observaron tanto a grupos de personas felices como a grupos de personas infelices, con un alcance de tres grados de separación: se asoció felicidad de una persona con el nivel de felicidad de los amigos de los amigos de sus amigos.[16]

Algunos investigadores han sugerido que las redes sociales humanas pueden tener una base genética.[17] Utilizando una muestra de mellizos del National Longitudinal Study of Adolescent Health, han encontrado que el in-degree (número de veces que una persona es nombrada como amigo o amiga), la transitividad (la probabilidad de que dos amigos sean amigos de un tercero), y la intermediación y centralidad (el número de lazos en la red que pasan a través de una persona dada) son significativamente hereditarios. Los modelos existentes de formación de redes no pueden dar cuenta de esta variación intrínseca, por lo que los investigadores proponen un modelo alternativo «Atraer y Presentar», que pueda explicar ese caracter hereditario y muchas otras características de las redes sociales humanas.[18]

El software germinal de las redes sociales parte de la teoría de los seis grados de separación, según la cual toda la gente del planeta está conectada a través de no más de seis personas. De hecho, existe una patente en EEUU conocida como six degrees patent por la que ya han pagado Tribe y LinkedIn. Hay otras muchas patentes que protegen la tecnología para automatizar la creación de redes y las aplicaciones relacionadas con éstas.

Estas redes sociales se basan en la teoría de los seis grados, Seis grados de separación es la teoría de que cualquiera en la Tierra puede estar conectado a cualquier otra persona en el planeta a través de una cadena de conocidos que no tiene más de seis intermediarios. La teoría fue inicialmente propuesta en 1929 por el escritor húngaro Frigyes Karinthy en una corta historia llamada Chains. El concepto está basado en la idea que el número de conocidos crece exponencialmente con el número de enlaces en la cadena, y sólo un pequeño número de enlaces son necesarios para que el conjunto de conocidos se convierta en la población humana entera.

El término red social es acuñado principalmente a los antropólogos ingleses John Barnes y Elizabeth Bott, ya que, para ellos resultaba imprescindible cosiderar lazos externos a los famliares, residenciales o de pertenencia a algún grupo social.[19]

Los fines que han motivado la creación de las llamadas redes sociales son varios, principalmente, es el diseñar un lugar de interacción virtual, en el que millones de personas alrededor del mundo se concentran con diversos intereses en común.

Recogida también en el libro «Six Degrees: The Science of a Connected Age” del sociólogo Duncan Watts, y que asegura que es posible acceder a cualquier persona del planeta en tan solo seis “saltos”.

Según esta Teoría, cada persona conoce de media, entre amigos, familiares y compañeros de trabajo o escuela, a unas 100 personas. Si cada uno de esos amigos o conocidos cercanos se relaciona con otras 100 personas, cualquier individuo puede pasar un recado a 10.000 personas más tan solo pidiendo a un amigo que pase el mensaje a sus amigos.

Estos 10.000 individuos serían contactos de segundo nivel, que un individuo no conoce pero que puede conocer fácilmente pidiendo a sus amigos y familiares que se los presenten, y a los que se suele recurrir para ocupar un puesto de trabajo o realizar una compra. Cuando preguntamos a alguien, por ejemplo, si conoce una secretaria interesada en trabajar estamos tirando de estas redes sociales informales que hacen funcionar nuestra sociedad. Este argumento supone que los 100 amigos de cada persona no son amigos comunes. En la práctica, esto significa que el número de contactos de segundo nivel será sustancialmente menor a 10.000 debido a que es muy usual tener amigos comunes en las redes sociales.

Si esos 10.000 conocen a otros 100, la red ya se ampliaría a 1.000.000 de personas conectadas en un tercer nivel, a 100.000.000 en un cuarto nivel, a 10.000.000.000 en un quinto nivel y a 1.000.000.000.000 en un sexto nivel. En seis pasos, y con las tecnologías disponibles, se podría enviar un mensaje a cualquier lugar individuo del planeta.

Evidentemente cuanto más pasos haya que dar, más lejana será la conexión entre dos individuos y más difícil la comunicación. Internet, sin embargo, ha eliminado algunas de esas barreras creando verdaderas redes sociales mundiales, especialmente en segmento concreto de profesionales, artistas, etc.

En la década de los 50, Ithiel de Sola Pool (MIT) y Manfred Kochen (IBM) se propusieron demostrar la teoría matemáticamente. Aunque eran capaces de enunciar la cuestión «dado un conjunto de N personas, ¿cual es la probabilidad de que cada miembro de estos N estén conectados con otro miembro vía k1, k2, k3,…, kn enlaces?», después de veinte años todavía eran incapaces de resolver el problema a su propia satisfacción.

En 1967, el psicólogo estadounidense Stanley Milgram ideó una nueva manera de probar la Teoría, que él llamó «el problema del pequeño mundo». El experimento del mundo pequeño de Milgram consistió en la selección al azar de varias personas del medio oeste estadounidense para que enviaran tarjetas postales a un extraño situado en Massachusetts, situado a varios miles de millas de distancia. Los remitentes conocían el nombre del destinatario, su ocupación y la localización aproximada. Se les indicó que enviaran el paquete a una persona que ellos conocieran directamente y que pensaran que fuera la que más probabilidades tendría, de todos sus amigos, de conocer directamente al destinatario. Esta persona tendría que hacer lo mismo y así sucesivamente hasta que el paquete fuera entregado personalmente a su destinatario final.

Aunque los participantes esperaban que la cadena incluyera al menos cientos de intermediarios, la entrega de cada paquete solamente llevó, como promedio, entre cinco y siete intermediarios. Los descubrimientos de Milgram fueron publicados en «Psychology Today» e inspiraron la frase seis grados de separación.

En The social software weblog han agrupado 120 sitios web en 10 categorías y QuickBase también ha elaborado un completo cuadro sobre redes sociales en Internet.

El origen de las redes sociales se remonta, al menos, a 1995, cuando Randy Conrads crea el sitio web classmates.com. Con esta red social se pretende que la gente pueda recuperar o mantener el contacto con antiguos compañeros del colegio, instituto, universidad, etcétera.

En 2002 comienzan a aparecer sitios web promocionando las redes de círculos de amigos en línea cuando el término se empleaba para describir las relaciones en las comunidades virtuales, y se hizo popular en 2003 con la llegada de sitios tales como MySpace o Xing. Hay más de 200 sitios de redes sociales, aunque Friendster ha sido uno de los que mejor ha sabido emplear la técnica del círculo de amigos.[cita requerida] La popularidad de estos sitios creció rápidamente y grandes compañías han entrado en el espacio de las redes sociales en Internet. Por ejemplo, Google lanzó Orkut el 22 de enero de 2004. Otros buscadores como KaZaZZ! y Yahoo crearon redes sociales en 2005.

En estas comunidades, un número inicial de participantes envían mensajes a miembros de su propia red social invitándoles a unirse al sitio. Los nuevos participantes repiten el proceso, creciendo el número total de miembros y los enlaces de la red. Los sitios ofrecen características como actualización automática de la libreta de direcciones, perfiles visibles, la capacidad de crear nuevos enlaces mediante servicios de presentación y otras maneras de conexión social en línea. Las redes sociales también pueden crearse en torno a las relaciones comerciales.

Las herramientas informáticas para potenciar la eficacia de las redes sociales online («software social»), operan en tres ámbitos, «las 3 Cs», de forma cruzada:

- Comunicación (nos ayudan a poner en común conocimientos).

- Comunidad (nos ayudan a encontrar e integrar comunidades).

- Cooperación (nos ayudan a hacer cosas juntos).

El establecimiento combinado de contactos (blended networking) es una aproximación a la red social que combina elementos en línea y del mundo real para crear una mezcla. Una red social de personas es combinada si se establece mediante eventos cara a cara y una comunidad en línea. Los dos elementos de la mezcla se complementan el uno al otro. Vea también computación social.

Las redes sociales continúan avanzando en Internet a pasos agigantados, especialmente dentro de lo que se ha denominado Web 2.0 y Web 3.0, y dentro de ellas, cabe destacar un nuevo fenómeno que pretende ayudar al usuario en sus compras en Internet: las redes sociales de compras. Las redes sociales de compras tratan de convertirse en un lugar de consulta y compra. Un espacio en el que los usuarios pueden consultar todas las dudas que tienen sobre los productos en los que están interesados, leer opiniones y escribirlas, votar a sus productos favoritos, conocer gente con sus mismas aficiones y, por supuesto, comprar ese producto en las tiendas más importantes con un solo clic. Esta tendencia tiene nombre, se llama Shopping 2.0.

No hay unanimidad entre los autores a la hora de proponer una tipología concreta. En algunos sitios se aplica la misma tipología que en su día se utilizó para los portales, dividirlos en horizontales y verticales:

- Horizontales: buscan proveer herramientas para la interrelación en general: Facebook, Google+, Hi5, Bebo .

- Verticales por tipo de usuario: dirigidos a un público específico, por ejemplo, profesionales Linkedin, amantes de los gatos MyCatSpace, etc

- Verticales por tipo de actividad: los que promueven una actividad particular. Videos YouTube, Microbloggin Twitter, compras, etc.

Un lazo puede ser llamado conector si su eliminación causa que los puntos que conecta se transformen en componentes distintos de un grafo.

Medidas de la importancia de un nodo dentro de una red, dependiendo de la ubicación dentro de ésta. Ejemplos de medidas de centralidad son la centralidad de grado, la cercanía, la intermediación y la centralidad de vector propio.

La diferencia entre el número de enlaces para cada nodo, dividido entre la cantidad máxima posible de diferencias. Una red centralizada tendrá muchos de sus vínculos dispersos alrededor de uno o unos cuantos puntos nodales, mientras que una red descentralizada es aquella en la que hay poca variación entre el número de enlaces de cada nodo posee.

Una medida de la probabilidad de que dos personas vinculadas a un nodo se asocien a sí mismos. Un coeficiente de agrupación más alto indica un mayor «exclusivismo».

Cohesión

El grado en que los actores se conectan directamente entre sí por vínculos cohesivos. Los grupos se identifican como ‘cliques’ si cada individuo está vinculado directamente con con cada uno de los otros, ‘círculos sociales’ si hay menos rigor en el contacto directo y este es inmpreciso, o bloques de cohesión estructural si se requiere la precisión.[20]

(Nivel individual) Densidad

El grado de relaciones de un demandado de conocerse unos a otros / proporción de lazos entre las mencione de un individuo. La densidad de la red, o densidad global, es la proporción de vínculos en una red en relación con el total de vínculos posibles (redes escasas versus densas)

Flujo de centralidad de intermediación

El grado en que un nodo contribuye a la suma del flujo máximo entre todos los pares de nodos (excluyendo ese nodo).

Véase también

- Análisis de redes

- Servicio de red social

- Redes sociales de internet

- Clique

- Comunidades de práctica

- Comunidad virtual

- Gestión del conocimiento

- Ley de Metcalfe

- Software social

- Dinámica de grupos

- Sistema complejo

Referencias

- ↑ Linton Freeman, The Development of Social Network Analysis. Vancouver: Empirical Press, 2006.

- ↑ Wellman, Barry and S.D. Berkowitz, eds., 1988. Social Structures: A Network Approach. Cambridge: Cambridge University Press.

- ↑ Hansen, William B. and Reese, Eric L. 2009. Network Genie User Manual. Greensboro, NC: Tanglewood Research.

- ↑ Freeman, Linton. 2006. The Development of Social Network Analysis. Vancouver: Empirical Pres, 2006; Wellman, Barry and S.D. Berkowitz, eds., 1988. Social Structures: A Network Approach. Cambridge: Cambridge University Press.

- ↑ Scott, John. 1991. Social Network Analysis. London: Sage.

- ↑ Wasserman, Stanley, and Faust, Katherine. 1994. Social Network Analysis: Methods and Applications. Cambridge: Cambridge University Press.

- ↑ The Development of Social Network Analysis Vancouver: Empirical Press.

- ↑ A.R. Radcliffe-Brown, «On Social Structure,» Journal of the Royal Anthropological Institute: 70 (1940): 1-12.

- ↑ [Nadel, SF. 1957. The Theory of Social Structure. London: Cohen and West.

- ↑ The Networked Individual: A Profile of Barry Wellman. [1]

- ↑ Mark Granovetter, «Introduction for the French Reader,» Sociologica 2 (2007): 1-8; Wellman, Barry. 1988. «Structural Analysis: From Method and Metaphor to Theory and Substance.» Pp. 19-61 in Social Structures: A Network Approach, edited by Barry Wellman and S.D. Berkowitz. Cambridge: Cambridge University Press.

- ↑ Mark Granovetter, «Introduction for the French Reader,» Sociologica 2 (2007): 1-8; Wellman, Barry. 1988. «Structural Analysis: From Method and Metaphor to Theory and Substance.» Pp. 19-61 in Social Structures: A Network Approach, edited by Barry Wellman and S.D. Berkowitz. Cambridge: Cambridge University Press. (see also Scott, 2000 and Freeman, 2004).

- ↑ Barry Wellman, Wenhong Chen and Dong Weizhen. Networking Guanxi. Pp. 221-41 in Social Connections in China: Institutions, Culture and the Changing Nature of Guanxi, edited by Thomas Gold, Douglas Guthrie and David Wank. Cambridge University Press, 2002.

- ↑ Could It Be A Big World After All?: Judith Kleinfeld article.

- ↑ Six Degrees: The Science of a Connected Age, Duncan Watts.

- ↑ James H. Fowler and Nicholas A. Christakis. 2008. «Dynamic spread of happiness in a large social network: longitudinal analysis over 20 years in the Framingham Heart Study.» British Medical Journal. December 4, 2008: doi:10.1136/bmj.a2338. Para aquellos que no puedan ver el original: Happiness: It Really is Contagious Retrieved December 5, 2008.

- ↑ «Genes and the Friends You Make», Wall Street Journal, 27 de enero de 2009.

- ↑ Fowler, J. H. (10 de febrero de 2009). «Model of Genetic Variation in Human Social Networks» (PDF). Proceedings of the National Academy of Sciences 106 (6): pp. 1720–1724. doi:. http://jhfowler.ucsd.edu/genes_and_social_networks.pdf.

- ↑ Medios de comunicación y solidaridad: reflexiones entorno a la (des)articulicación social, Ed. Universitat Jaume I, España, 2006

- ↑ Cohesive.blocking R es el programa para calcular la cohesión estructural según el algoritmo de Moody-White (2003). Ese wiki provee numerosos ejemplos y un tutorial para utilizar R.

Lecturas adicionales

- Barnes, J. A. «Class and Committees in a Norwegian Island Parish», Human Relations 7:39-58

- Berkowitz, Stephen D. 1982. An Introduction to Structural Analysis: The Network Approach to Social Research. Toronto: Butterworth. ISBN 0-409-81362-1

- Brandes, Ulrik, and Thomas Erlebach (Eds.). 2005. Network Analysis: Methodological Foundations Berlin, Heidelberg: Springer-Verlag.

- Breiger, Ronald L. 2004. «The Analysis of Social Networks.» Pp. 505–526 in Handbook of Data Analysis, edited by Melissa Hardy and Alan Bryman. London: Sage Publications. ISBN 0-7619-6652-8 Excerpts in pdf format

- Burt, Ronald S. (1992). Structural Holes: The Structure of Competition. Cambridge, MA: Harvard University Press. ISBN 0-674-84372-X

- (en italiano) Casaleggio, Davide (2008). TU SEI RETE. La Rivoluzione del business, del marketing e della politica attraverso le reti sociali. ISBN 88-901826-5-2

- Carrington, Peter J., John Scott and Stanley Wasserman (Eds.). 2005. Models and Methods in Social Network Analysis. New York: Cambridge University Press. ISBN 978-0-521-80959-7

- Christakis, Nicholas and James H. Fowler «The Spread of Obesity in a Large Social Network Over 32 Years,» New England Journal of Medicine 357 (4): 370-379 (26 July 2007)

- Coz Fernandez, Jose Ramón and Fojón Chamorro, Enrique (2010). «Modulo de Madurez para la Privacidad de una Red Social Virtual». ISBN 978-1-4457-2017-3

- Doreian, Patrick, Vladimir Batagelj, and Anuska Ferligoj. (2005). Generalized Blockmodeling. Cambridge: Cambridge University Press. ISBN 0-521-84085-6

- Freeman, Linton C. (2004) The Development of Social Network Analysis: A Study in the Sociology of Science. Vancouver: Empirical Press. ISBN 1-59457-714-5

- Hill, R. and Dunbar, R. 2002. «Social Network Size in Humans.» Human Nature, Vol. 14, No. 1, pp. 53–72.

- Jackson, Matthew O. (2003). «A Strategic Model of Social and Economic Networks». Journal of Economic Theory 71: pp. 44–74. doi:. pdf

- Huisman, M. and Van Duijn, M. A. J. (2005). Software for Social Network Analysis. In P J. Carrington, J. Scott, & S. Wasserman (Editors), Models and Methods in Social Network Analysis (pp. 270–316). New York: Cambridge University Press. ISBN 978-0-521-80959-7

- Krebs, Valdis (2006) Social Network Analysis, A Brief Introduction. (Includes a list of recent SNA applications Web Reference.)

- Ligon, Ethan; Schechter, Laura, «The Value of Social Networks in rural Paraguay», University of California, Berkeley, Seminar, March 25, 2009 , Department of Agricultural & Resource Economics, College of Natural Resources, University of California, Berkeley

- Lin, Nan, Ronald S. Burt and Karen Cook, eds. (2001). Social Capital: Theory and Research. New York: Aldine de Gruyter. ISBN 0-202-30643-7

- Mullins, Nicholas. 1973. Theories and Theory Groups in Contemporary American Sociology. New York: Harper and Row. ISBN 0-06-044649-8

- Müller-Prothmann, Tobias (2006): Leveraging Knowledge Communication for Innovation. Framework, Methods and Applications of Social Network Analysis in Research and Development, Frankfurt a. M. et al.: Peter Lang, ISBN 0-8204-9889-0.

- Manski, Charles F. (2000). «Economic Analysis of Social Interactions». Journal of Economic Perspectives 14: pp. 115–36. [2] via JSTOR

- Moody, James, and Douglas R. White (2003). «Structural Cohesion and Embeddedness: A Hierarchical Concept of Social Groups.» American Sociological Review 68(1):103-127. [3]

- Newman, Mark (2003). «The Structure and Function of Complex Networks». SIAM Review 56: pp. 167–256. doi:. pdf

- Nohria, Nitin and Robert Eccles (1992). Networks in Organizations. second ed. Boston: Harvard Business Press. ISBN 0-87584-324-7

- Nooy, Wouter d., A. Mrvar and Vladimir Batagelj. (2005). Exploratory Social Network Analysis with Pajek. Cambridge: Cambridge University Press. ISBN 0-521-84173-9

- Scott, John. (2000). Social Network Analysis: A Handbook. 2nd Ed. Newberry Park, CA: Sage. ISBN 0-7619-6338-3

- Sethi, Arjun. (2008). Valuation of Social Networking [4]

- Tilly, Charles. (2005). Identities, Boundaries, and Social Ties. Boulder, CO: Paradigm press. ISBN 1-59451-131-4

- Valente, Thomas W. (1995). Network Models of the Diffusion of Innovations. Cresskill, NJ: Hampton Press. ISBN 1-881303-21-7

- Wasserman, Stanley, & Faust, Katherine. (1994). Social Network Analysis: Methods and Applications. Cambridge: Cambridge University Press. ISBN 0-521-38269-6

- Watkins, Susan Cott. (2003). «Social Networks.» Pp. 909–910 in Encyclopedia of Population. rev. ed. Edited by Paul George Demeny and Geoffrey McNicoll. New York: Macmillan Reference. ISBN 0-02-865677-6

- Watts, Duncan J. (2003). Small Worlds: The Dynamics of Networks between Order and Randomness. Princeton: Princeton University Press. ISBN 0-691-11704-7

- Watts, Duncan J. (2004). Six Degrees: The Science of a Connected Age. W. W. Norton & Company. ISBN 0-393-32542-3

- Wellman, Barry (1998). Networks in the Global Village: Life in Contemporary Communities. Boulder, CO: Westview Press. ISBN 0-8133-1150-0

- Wellman, Barry. 2001. «Physical Place and Cyber-Place: Changing Portals and the Rise of Networked Individualism.» International Journal for Urban and Regional Research 25 (2): 227-52.

- Wellman, Barry and Berkowitz, Stephen D. (1988). Social Structures: A Network Approach. Cambridge: Cambridge University Press. ISBN 0-521-24441-2

- Weng, M. (2007). A Multimedia Social-Networking Community for Mobile Devices Interactive Telecommunications Program, Tisch School of the Arts/ New York University

- White, Harrison, Scott Boorman and Ronald Breiger. 1976. «Social Structure from Multiple Networks: I Blockmodels of Roles and Positions.» American Journal of Sociology 81: 730-80.

Enlaces externos

Wikilibros alberga un libro o manual sobre Análisis de Redes Sociales.

Wikilibros alberga un libro o manual sobre Análisis de Redes Sociales.- Center for Computational Analysis of Social and Organizational Systems (CASOS) at Carnegie Mellon

- NetLab at the University of Toronto, studies the intersection of social, communication, information and computing networks

- Building networks for learning– A guide to on-line resources on strengthening social networking.

- Recomendaciones de seguridad en redes sociales– guía de la Oficina de seguridad del Internauta.

- ¿Cumplen las redes sociales los compromisos de privacidad con los menores?

Fuente: Wikipedia, Marzo 2013.

—————————————————————-

¿Cuánto vale una casa en Mosul?

junio 13, 2014

¿Cuánto vale una casa en Mosul?

La pregunta pude sonar extraña, pero no carente de interés. Mosul es hoy una ciudad en retirada:

“Medio millón de personas huyeron de Mosul y otras localidades norteñas ante el avance de los jihadistas y la respuesta de las tropas gubernamentales, que bombardearon algunas posiciones rebeldes.” La Nación, 13/06/14.

Este simple ejemplo pone de relieve la importancia de juzgar las inversiones con una perspectiva amplia, considerando períodos largos y no subestimando los riesgos. Similares preguntas podrían plantearse con relación a un Depósito bancario, una Cartera de Acciones o Bonos, un Mutual Fund o un Hedge Fund.

El valor y la calidad de una inversión depende del contexto, del lugar donde está radicada, del marco jurídico y de la estabilidad institucional.

Estos son algunos de los temas que evaluamos -en forma introductoria- en el Seminario gratuito “Cómo iniciar un Plan de Inversión eficaz” y profundizamos en el libro Manual de Economía Personal.

Si quiere saber más y acceder a esta valiosa información escriba a: [email protected]

Exodo en Mosul, junio 2014.

————————————–

Mosul es una ciudad localizada en el norte de Irak, ubicada al este del río Tigris y distante aproximadamente unos 396 km de Bagdad, la capital del país. Mosul es la tercera ciudad más grande de Irak, después de la capital y de Basora.

A pocos kilómetros de Mosul se encuentra el yacimiento de Tell Hassuna, que data aproximadamente del 6000 a. C.

La población de la provincia es fundamentalmente árabe pero la mayoría de los habitantes de la ciudad son asirios. En 1987 tenía 664.221 habitantes, pasando a 1.739.800 en 2002. En ella murieron miles de personas durante la guerra de Kuwait.

Fuente: Wikipedia, 2014.

————————————–

Los yihadistas que tomaron Mosul penetran en la ciudad iraquí de Tikrit.

Por Ángeles Espinosa.

· Los milicianos del EIIL prosiguen su ofensiva que ha causado medio millón de desplazados

· Los yihadistas conquistan la principal ciudad del norte de Irak

· La población del norte de Irak abandona sus casas

Envalentonados por el éxito militar y mediático de la toma de Mosul el martes, los extremistas suníes del Ejército Islámico de Irak y el Levante (EIIL) seguían avanzando el miércoles. Milicianos de ese grupo y otros asociados se hicieron con el control de Tikrit, la capital de la provincia de Saladino, donde también hostigaban una importante refinería. Mientras, las tropas de la vecina región autónoma del Kurdistán se mantenían en alerta ante la posibilidad de que el Gobierno central pida su cooperación para recuperar Mosul, una decisión que sin duda tendría un elevado coste político para Nuri al Maliki, justo cuando intenta asegurarse un tercer mandato como primer ministro.

“Con el permiso de Dios, no cesaremos en esta serie de benditas conquistas hasta que Él cumpla sus promesas o nosotros muramos”, aseguraba un comunicado del EIIL publicado en un foro yihadista y traducido por Efe.

No son solo palabras. A media tarde del miércoles, fuentes oficiales admitían que los insurgentes habían logrado invadir varios barrios de la ciudad de Tikrit y, según la agencia iraquí NINA, quemaron la sede de la gobernación tras haberla tomado sin resistencia. Situada a 150 kilómetros de Bagdad y famosa porque en sus cercanías nació el depuesto dictador Sadam Husein, Tikrit es la capital de la provincia de Saladino, donde los yihadistas han instalado sus banderas negras en otras localidades más pequeñas, e intentaban hacerse con la refinería de Baiji, tras garantizar a los 250 policías que la vigilan que podrán irse si deponen las armas.

Muchas familias que permanecen en sus casas no tienen ni electricidad ni agua corriente.

Un poco más al este, en la provincia de Kirkuk, los rebeldes ejecutaron sumariamente a 15 miembros de las fuerzas de seguridad, en las zonas que conquistaron la víspera, informa France Presse. También se supo que en Mosul retienen a 80 ciudadanos turcos. Medio centenar de ellos, incluido el cónsul, su familia y otros diplomáticos, fueron secuestrados en el consulado general de ese país; el resto son camioneros, ha confirmado el miércoles el Ministerio de Exteriores turco. Pero la mayoría de la población no espera a ver cuáles son las intenciones de esos extremistas que aspiran a refundar el Califato entre el Tigris y el Mediterráneo, y cuya brutalidad en Siria, donde también operan, les ha granjeado la condena de Al Qaeda, organización en la que se inspiraron.

“Medio millón de personas han abandonado sus hogares en Mosul o sus alrededores”, informa la Organización Internacional para las Migraciones (OIM). Es una cuarta parte de los habitantes de la ciudad. Según esa organización, también se ha producido “un número importante de víctimas entre los civiles”, aunque nadie ha facilitado datos al respecto. Además, escasean los víveres y el agua potable, y los yihadistas han prohibido el uso de coches. Quienes huyen tienen que hacerlo a pie.

Claves del Estado Islámico de Irak y Levante

Tiene de 3.000 a 5.000 milicianos en sus filas, tanto árabes como extranjeros. El profesor del Kings College de Londres, Peter Neumann, estima que el 80% de los milicianos extranjeros en Siria se ha sumado al EIIL.

Es una organización vinculada a Al Qaeda que se creó en abril de 2013.

El grupo es principalmente activo en Irak y Siria.

Abu Bakr al-Baghdadi es el líder principal.

Lucha contra lo que definen como el monopolio del poder por parte del primer ministro iraquí, el chií Nuri Al Maliki.

Los combatientes del EIIL profesan la rama suní del Islam.

En Irak, tienen el control de las ciudades de Ramadi, Faluya y Mosul y en Siria tienen una fuerte presencia en tres provincias.

Su fuente de financiación es desconocida.

La ofensiva, incluidos dos atentados suicidas en Bagdad que causaron una veintena de muertos, constituye un órdago al Gobierno de Al Maliki, incapaz de frenar el renacer de la insurgencia suní que él mismo ayudó a apaciguar en 2008. Desde principios de este año, y en gran medida por su gestión de las relaciones con esa comunidad, los yihadistas han logrado hacerse con el control de Faluya y de buena parte de Ramadi, a 60 y 100 kilómetros al oeste de Bagdad, respectivamente.

Ahora, con el país escapándosele de las manos, Al Maliki se enfrenta a una difícil tesitura. Ni el estado de emergencia que el jueves va a debatir el Parlamento, ni la leva de milicias populares que propuso el martes resultan suficientes para revertir esa tendencia. Sin el respaldo del Ejército estadounidense que se retiró de Irak a finales de 2011 y con unas fuerzas armadas que no dan más de sí (y cuya motivación ha quedado en evidencia en Mosul), solo le queda recurrir a los kurdos.

“Habrá una estrecha cooperación entre Bagdad y el Gobierno regional del Kurdistán para trabajar juntos y expulsar a esos combatientes extranjeros”, aseguró ayer el ministro iraquí de Exteriores, Hoshyar Zebari, en Atenas, donde acudía a una reunión entre la UE y la Liga Árabe. Zebari, que es kurdo, enunciaba lo que muchos tenían en la cabeza.

Sin embargo la entrada en escena de los Peshmerga, como se conoce a las tropas kurdas, no es tan sencilla. Por un lado, Al Maliki aún no ha logrado formar un nuevo Gobierno tras las elecciones del pasado abril y carece por tanto de aliados con los que respaldar esa decisión. Por otro, los kurdos, que a pesar de sus diferencias actúan como un bloque compacto en Bagdad, compiten con los chiíes por la influencia política, en especial en el control de los pozos petrolíferos de Kirkuk. ¿Qué precio van a pedir a cambio de su ayuda?

De momento, todo son especulaciones. Aunque sobre el terreno hay indicaciones de coordinación ocasional entre el Ejército iraquí y los Peshmerga, la petición no parece haberse cursado todavía. No puede tardar. Como advirtió Zebari, “la respuesta tiene que ser rápida; no se les puede dejar atrincherarse durante mucho tiempo”.

Fuente: El País, 11/06/14.

Etiquetas: EIIL, Yihad, Irak, Al Qaeda, Guerrillas, Terrorismo islamista, Oriente próximo, Asia, Grupos terroristas, Guerra, Terrorismo, Conflictos.

Los malos empleados aman su trabajo

junio 13, 2014

Los malos empleados aman su trabajo

Por Lauren Weber

Los mejores empleados de una empresa también deberían ser los más felices y entusiasmados, pero no siempre es así.

Un nuevo estudio indica que, en 42% de las empresas, los empleados con bajo desempeño de hecho reportan sentirse más entusiasmados —más motivados y con más probabilidad de disfrutar del trabajo en su organización, por ejemplo— que los que tienen un desempeño mediano y alto.

El estudio sugiere que muchas organizaciones no están logrando que sus empleados se responsabilicen por su trabajo, lo que permite que los peores trabajadores no hagan mucho esfuerzo, afirma Mark Murphy, presidente ejecutivo de Leadership IQ, la firma de consultoría con sede en Atlanta que realizó la encuesta.

«Quienes tienen un bajo desempeño suelen terminar con los trabajos más fáciles porque los gerentes no les piden mucho», sostiene, así que soportan menos estrés y están más satisfechos con sus vidas laborales día a día.

En tanto, los trabajadores dedicados y concienzudos terminan quedándose en la oficina hasta tarde, corrigiendo el trabajo de quienes tienen bajo desempeño y asegurándose de que los clientes o compradores estén satisfechos. Este patrón genera frustración y desapego entre los de mejor desempeño, y quizás termina llevándolos a buscar trabajo en otro lado. «Se sienten estresados y subestimados, y esto comienza a socavar la confianza de los empleados de desempeño alto en que la organización es una meritocracia», dice Murphy.

Para remediar la situación, los gerentes deberían hablar con franqueza con los empleados de desempeño alto y medio, para descubrir qué frustraciones podrían llevarlos a buscar nuevas oportunidades. También deberían averiguar qué podría motivarlos a quedarse, agrega.

Para averiguar esto, Leadership IQ analizó datos de 207 empresas que llevaban un registro detallado tanto de evaluaciones de desempeño como de encuestas de dedicación.

En el 58% restante de las organizaciones encuestadas, los que tenían un alto desempeño eran los más metidos en el trabajo, o las puntuaciones de dedicación eran parecidas entre todos los empleados. En los casos menos habituales, señala Murphy, los empleados de desempeño medio eran los más entusiasmados con el trabajo. Ese segmento de la fuerza laboral —los empleados que no son ni superestrellas ni holgazanes— suele ser ignorado por los gerentes, dice.

Leadership IQ analizó también la dinámica específica de una empresa, una firma de servicios tecnológicos con 1.000 empleados, donde los de menor desempeño reportaron altos niveles de dedicación. El estudio descubrió que, en una escala de 7 puntos, los de bajo desempeño otorgaron un puntaje de 5,99 a la afirmación «Estoy motivado para dar 100% de mi esfuerzo cuando estoy en el trabajo». Los de alto rendimiento otorgaron un puntaje de 5,36 y la puntuación de los de desempeño medio fue de 5,32, el nivel más bajo.

Los empleados de bajo desempeño también registraban una mayor probabilidad que los otros dos grupos de recomendar a su empresa como una «gran organización donde trabajar». Y en muchos casos, ni siquiera se dieron cuenta de que tenían bajo desempeño. Cuando se les preguntó si los empleados de la empresa «mantienen todos los mismos estándares», los trabajadores de bajo desempeño contestaron con mucha más frecuencia que estaban de acuerdo con el enunciado en comparación con sus colegas de mejor desempeño.

Fuente: The Wall Street Journal, 28/03/13.

The 2014 NUL top 100

junio 12, 2014

The 2014 NUL top 100.

By Warren S. Hersch, Emily Holbrook.

Statistics can tell a lot, not only about the financial health of companies, but also how they stack up against one another. In this annual feature, we take the pulse of 100 top-ranking life and health insurers when measured against four key metrics: net investment income, total enrollment (health lines only), policyholder surplus and net premiums written.

The report card on the last of these, of particular interest to life insurance professionals, reveals a shake up in the ranks, with a top three insurer in 2012 displacing the formerly number one carrier in 2013. Hence, UnitedHealth Group overtook WellPoint last year in the health segment (all lines); Jackson National surpassed Prudential Financial in the annuities space (individual and group); and Prudential nudged aside MetLife in life insurance net premiums (excepting credit life).

In two market segments — life/ accident & health (except credit); and life (supplemental & other) — the top insurer of 2012 maintained the top position in 2013. The companies: UnitedHealth Group Inc. and TIAA-CREF, respectively.

A comparison of 2012 and 2013 tables also reveals significant variations in net premiums written for individual companies. A prime example is Prudential Financial, which last year garnered $19.2 billion in net premiums, down from the $61.1 billion recorded in 2012.

How to explain so significant a decline? A Prudential spokesperson attributed the dip to two factors: (1) a one-time bump from $30 billion of premium income generated by pension risk transfer transactions concluded with General Motors and Verizon in 2012; and (2) a decrease in gross sales of variable annuities ($11.447 billion in 2013 versus $19.977 billion in 2012).

While these items are “almost certainly the main drivers” for the premium decline, the spokesperson cautions that Prudential cannot take responsibility for the accuracy of data provided by a third party.

The source of the stats: SNL Financial, which bases its figures on the insurers’ own filings with the National Association of Insurance Commissioners. SNL Financial’s proprietary database — to which NU and LifeHealthPro have privileged access — standardizes financial data using the life and health insurance industries’ financial parameters, terminology and performance metrics. The company data is also aligned over time to enable easy comparison of different periods.

With this as background, read on. See how your carriers measure up against the competition. You may be surprised!

See:

Evolución matemática de los juegos de azar durante el siglo XIX

junio 12, 2014

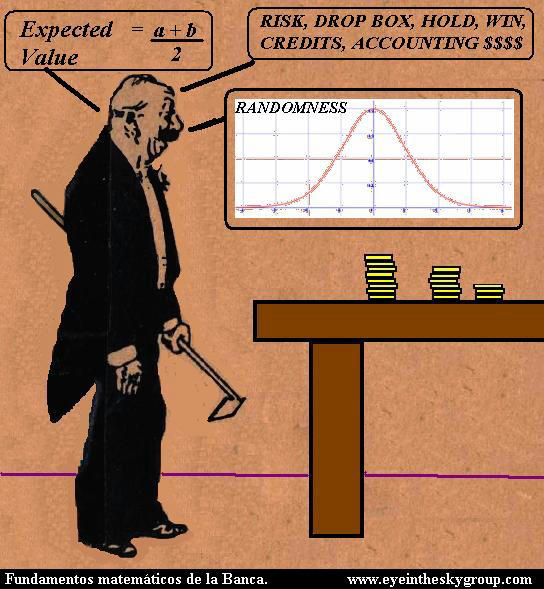

La Estadística y la Teoría de la Probabilidad en el Fortalecimiento de los Juegos de Azar:

¿Qué ocurría con la evolución de los juegos de azar durante el siglo XIX, campo primigenio en el cual había surgido la Teoría de la Probabilidad que paulatinamente se había extendido y alcanzado un desarrollo tan impresionante en todas las áreas de la ciencia?