DeepSeek y medicina

abril 10, 2025

Por Roberto Borrone.

“La inteligencia consiste no solo en el conocimiento, sino también en la destreza de aplicar los conocimientos en la práctica” (Aristóteles). Luis Ignacio Brusco enfatiza en su magnífico libro Homo IA que el término “inteligencia” es heterogéneo y que mezcla muchas funciones (memoria, pensamiento deductivo, capacidades lingüísticas, capacidad visoespacial). Agreguemos a esto el concepto incorporado en 1995 por Daniel Coleman denominado “inteligencia emocional”. La Inteligencia artificial (IA) trata de imitar a la inteligencia humana en funciones como memoria, aprendizaje, resolución de problemas y toma de decisiones. Incluso muchos descreen que la empatía sea una de las limitaciones de la IA.

.

Ariel Torres enfatizó recientemente en LA NACIÓN (01/02/25), que una noticia tecno de alto impacto en el inicio de este año fue indudablemente la irrupción del modelo de lenguaje de inteligencia artificial (IA) DeepSeek generado por una pequeña empresa china, High Flyer, según su denominación en inglés y Haán Fang (Cuadrado Mágico), su nombre chino. El antecedente previo de impacto equivalente fue el desarrollo de la compañía Open AI cuando el 30 de noviembre de 2022 lanzó el ChatGPT. Un detalle sorprendente es que la startup china informó que sólo utilizó una fracción de los chips informáticos empleados por las empresas de IA. Los ingenieros de DeepSeek comunicaron que sólo necesitaron 2000 chips en lugar de los 16.000 o más utilizados por las compañías de IA preexistentes. (Cade Metz,The New York Times). En otras palabras, DeepSeek habría utilizado 8 a 10 veces menos de recursos de hardware especializado. La explicación disponible para esa novedad es que DeepSeek se basó en una metodología más eficaz para analizar los datos repartiendo el análisis entre varios modelos especializados de IA. Se lo denomina método de “mezcla de expertos” y habilita al modelo para decidir qué redes de procesamiento debe activar para cada tarea. El 20 de enero DeepSeek lanzó su modelo denominado DeepSeek R1. La información indica que R1 fue entrenado tomando como base el funcionamiento del Chatbot V3, de la misma startup china, mediante técnicas de aprendizaje por refuerzo ,donde a partir de las señales de retroalimentación que recibe (recompensa o penalización) el sistema ajusta su comportamiento. (http://es.wired.com)

Open AI ha expresado sus sospechas de que DeepSeek ha entrenado sus modelos estudiando los resultados de los modelos estadounidenses, mediante un proceso conocido como “destilación”. Se trata de una técnica prohibida expresamente en los términos de uso de sus modelos GPT. Vishal Yadav y Nikhil Pandley (Microsoft) se han referido a esto explicando que la destilación es un técnica diseñada para transferir los conocimientos de un gran modelo preentrenado (“el maestro”) a un modelo más pequeño (“el alumno”). Otro aspecto a destacar es que DeepSeek ha abierto su sistema de IA, esto significa que ha compartido el código informático con otras empresas e investigadores (“código abierto”) permitiendo que los desarrolladores trabajen de manera colaborativa. El código abierto está disponible para que cualquiera lo descargue y lo use.

El 5 de febrero le efectuamos un test a DeepSeek solicitándole que responda un cuestionario integrado por 45 preguntas médicas de la especialidad oftalmología. Se utilizó como fuente la bibliografía científica a la que habitualmente recurrimos para elaborar los exámenes de posgrado en la carrera de especialista de la Primera Cátedra de Oftalmología de la Facultad de Medicina de la Universidad de Buenos Aires (UBA) con sede en el Hospital de Clínicas. La novedad que incorporamos fue que el nivel de complejidad de los escenarios clínicos planteados en cada pregunta de este examen fue superior al utilizado habitualmente en nuestros exámenes. Otro rasgo singular de este examen fue que una proporción significativa de los escenarios clínicos planteados corresponde a síndromes sistémicos, es decir, enfermedades que, además del compromiso ocular, afectan a diferentes estructuras del organismo por lo que para su diagnóstico se requiere un profundo conocimiento tanto de oftalmología como de medicina en general. A DeepSeek se le solicitó emitir un diagnóstico para cada uno de los 45 casos clínicos planteados.

El resultado fue que DeepSeek respondió correctamente el 86 % de las preguntas (39/45). Las respuestas de DeepSeek a cada pregunta incluyó extensos párrafos en los que expresó todo el razonamiento que utilizó al valorar los síntomas, signos y resultados de estudios complementarios de cada caso clínico. En ese “razonamiento” DeepSeek emitió diagnósticos presuntivos y diagnósticos diferenciales hasta que finalmente llegó a su diagnóstico final. Un aspecto sorprendente es el lenguaje utilizado durante el razonamiento, simulando el escenario de estar interactuando con un colega experto en el tema, o la situación habitual de un ateneo clínico en una institución de salud. En la primera fase de sus respuestas, consistente en dar las respuestas con todo el “razonamiento” efectuado hasta llegar al diagnóstico final de las 45 preguntas, DeepSeek empleó 214 segundos, En la segunda fase de sus respuestas, realizada sin interrupción luego de la primera fase, DeepSeek ofreció un listado con sus 45 diagnósticos finales, tardando en total 14 segundos. En síntesis, tardó menos de 5 segundos para cada respuesta en la primera fase de respuestas con el razonamiento (4.75 segundos) y la tercera parte de 1 segundo (0.31 seg.) por cada respuesta en la segunda fase (sólo los diagnósticos).

Con el mismo examen fue testeado el modelo GPT4o de Open AI. El resultado fue que el 68 % de sus respuestas fueron correctas (31/45). En este caso el texto de las respuestas fue directamente el diagnóstico de cada caso clínico.

Un detalle interesante fue que DeepSeek y GPT4o coincidieron en 5 preguntas en sus respuestas incorrectas (sin coincidir en sus respectivas respuestas), es decir que en el 83 % de las respuestas incorrectas de DeepSeek (5/6), GPT4o también se equivocó. Se prestó especial atención a la construcción de las preguntas (planteo de casos clínicos) para minimizar un problema en lo que se denomina “prompt”, es decir, la instrucción o pregunta que se le hace a una herramienta de inteligencia artificial para que produzca algo.

Con el mismo examen fue evaluado un médico oftalmólogo con 25 años de experiencia en la especialidad y reconocido por su erudición superlativa en esta disciplina médica. Sus respuestas correctas correspondieron al 66 % de las preguntas (30/45). El tiempo que le demandó responder las 45 preguntas del examen fue de 49 minutos. Al finalizar calificó al examen como de alta dificultad.

La experiencia es ilustrativa en varios aspectos pero debemos considerar que es una “foto” circunstancial en el contexto de una tecnología que avanza con una dinámica sorprendent,e por lo que este “ranking” entre los modelos de inteligencias artificiales variará seguramente en muy poco tiempo (quizás cuando este artículo sea publicado). Valga la aclaración por las suspicacias que esto genera en el contexto geopolítico actual y la competencia tecnológica existente por la supremacía en IA.

.

Algunas reflexiones finales. No hay dudas respecto a la formidable herramienta que representa la IA para actuar cooperativamente con el médico al poner a su disposición su sorprendente capacidad para procesar una cantidad asombrosa de datos en forma instantánea. Ante la crisis actual que atraviesa la relación médico-paciente, la IA está abriendo la posibilidad para los médicos de humanizar nuestra práctica profesional poniendo el foco, además del conocimiento y las destrezas, en competencias como la empatía y el “criterio médico”, con una mirada holística del paciente. La sorprendente velocidad de estos avances tecnológicos me remite a una frase que repetía mi padre refiriéndose – hace ya muchos años-, a la brevedad de los viajes en avión cubriendo largas distancias: “el cuerpo llega antes que el alma”. Podríamos parafrasearla diciendo que cada novedad de esta revolución tecnológica liderada por la inteligencia artificial nos llega antes de recuperarnos del asombro que nos ha generado el último eslabón. A modo de epílogo, valga una advertencia: la fascinación por la tecnología no nos debe hacer olvidar el rol “humano” del médico ante el paciente.

Fuente: lanacion.com.ar, 03/04/25

Más información:

La pauperización médica en Argentina

Medicina prepaga: ni ángeles ni demonios

La miopía es una enfermedad y no solamente anteojos

La inteligencia artificial revoluciona la docencia médica

Hacia un país sin médicos clínicos ni pediatras suficientes

Historia del Cuerpo Médico Forense de la Justicia Nacional

Medicamentos de venta libre y los riesgos de la automedicación

.

Ventajas de incursionar en los Negocios Digitales

enero 7, 2025

Por Gustavo Ibáñez Padilla.

El mundo está atravesando una transformación sin precedentes, marcada por la convergencia de la tecnología digital y la economía global. La expansión de Internet, la inteligencia artificial (IA) y el comercio electrónico han revolucionado la manera en que interactuamos y hacemos negocios. Este fenómeno no solo facilita la comunicación a nivel mundial, sino que también impulsa el comercio y la innovación. En este contexto, las ventajas de incursionar en los negocios digitales son enormes y diversificadas.

Ser tu propio jefe

Una de las motivaciones más fuertes para emprender en el ámbito digital es la autonomía que ofrece. Ser tu propio jefe implica tener control total sobre tu destino profesional. Según el empresario y autor Richard Branson, «El negocio más exitoso es aquel que puedes hacer con pasión». Esta libertad permite a los emprendedores decidir cuánto quieren trabajar, qué proyectos tomar y cómo balancear su vida personal y profesional. La capacidad de ajustar tu ritmo de trabajo según tus necesidades y aspiraciones es una ventaja inigualable.

.

Barreras de entrada mínimas

A diferencia de los negocios tradicionales, los negocios digitales presentan barreras de entrada significativamente más bajas. No se requiere una inversión inicial grande ni conocimientos técnicos avanzados para comenzar. Plataformas como Shopify, WordPress y Wix permiten a los emprendedores crear tiendas y sitios web funcionales con una inversión mínima. Esto reduce el riesgo financiero y facilita la experimentación con diferentes ideas de negocio sin comprometer grandes recursos.

Un mercado en expansión

El comercio en línea está en auge. Según un informe de Statista, se espera que el comercio electrónico mundial alcance los 7,4 billones de dólares en 2024. Esta tendencia refleja el creciente número de consumidores que prefieren comprar en línea por conveniencia y accesibilidad. Empresas como Amazon y Alibaba han demostrado el potencial del mercado digital, y el crecimiento continuo de este sector indica que la demanda seguirá aumentando. Emprender en un mercado en constante expansión ofrece oportunidades ilimitadas para los nuevos negocios.

La revolución móvil

El auge de los teléfonos inteligentes ha transformado la manera en que los consumidores interactúan con las empresas. Hoy en día, un gran porcentaje de las compras en línea se realizan a través de dispositivos móviles. Según Pew Research, el 85% de los estadounidenses posee un teléfono inteligente, lo que representa una enorme oportunidad para los negocios digitales. Tener una presencia en línea optimizada para móviles no solo es crucial, sino que también permite a las empresas llegar a sus clientes en cualquier momento y lugar.

.

Amplificación del nicho

Internet permite a los negocios llegar a un público global, ampliando significativamente su mercado potencial. Esto es especialmente beneficioso para los negocios de nicho, que pueden tener una base de clientes limitada a nivel local. La plataforma Etsy, por ejemplo, ha permitido a artesanos y creadores vender productos únicos a clientes de todo el mundo. La capacidad de encontrar y atraer a tu audiencia específica en una escala global es una ventaja clave de los negocios digitales.

Delegación y automatización

La delegación y automatización de tareas es más accesible y económica en el ámbito digital. Plataformas como Upwork y Fiverr conectan a los emprendedores con freelancers especializados a costos competitivos. Además, herramientas de automatización como Zapier, Hootsuite y Social-Gator permiten gestionar procesos operativos y de marketing con mínima intervención humana. La inteligencia artificial también está jugando un papel crucial, optimizando la atención al cliente y la gestión de inventarios. Este enfoque reduce costos operativos y libera tiempo para que los emprendedores se concentren en la estrategia y el crecimiento.

.

Operatividad 24/7

Una de las ventajas más significativas de los negocios digitales es su operatividad continua. Las tiendas en línea y los servicios digitales están disponibles las 24 horas del día, los 7 días de la semana. Esto no solo aumenta la accesibilidad para los clientes, sino que también maximiza las oportunidades de venta. El cofundador de Alibaba, Jack Ma, destaca que «el e-commerce es un campo de batalla global». La capacidad de generar ingresos mientras duermes es una realidad en el mundo digital, proporcionando una eficiencia operativa sin precedentes.

Ejemplos de éxito

Numerosos ejemplos ilustran el éxito y las ventajas de los negocios digitales. Amazon, que comenzó como una librería en línea, se ha convertido en un gigante del comercio electrónico y la tecnología. Airbnb ha revolucionado la industria de la hospitalidad, permitiendo a los usuarios alquilar sus propiedades a viajeros de todo el mundo. Empresas como Uber y Lyft han transformado la industria del transporte mediante plataformas digitales que conectan a conductores y pasajeros de manera eficiente.

Otro caso notable es el de Netflix, que comenzó compitiendo con el alquiler de DVD y se ha transformado en una plataforma de streaming global, redefiniendo la forma en que consumimos entretenimiento. Estos ejemplos demuestran que la innovación digital puede abrir puertas a nuevas oportunidades y mercados, generando crecimiento y éxito a gran escala.

Los Negocios del siglo XXI

En un mundo en constante cambio, los negocios digitales representan una oportunidad única para emprendedores de todas las edades y sectores. La autonomía, las bajas barreras de entrada, el acceso a un mercado global, la revolución móvil, la capacidad de amplificar nichos, la eficiencia de la delegación y automatización, y la operatividad continua son ventajas innegables que ofrecen una base sólida para el éxito.

Como dijo Steve Jobs, «La innovación es lo que distingue a un líder de los demás». Incursionar en los negocios digitales no solo te posiciona en la vanguardia de la innovación, sino que también te permite aprovechar las tendencias emergentes y transformar tu visión en realidad. Este es el momento de dar el paso hacia el futuro y capitalizar las enormes oportunidades que ofrece el mundo digital.

Fuente: Ediciones EP, 19/07/24.

Información sobre Gustavo Ibáñez Padilla

Más información:

¿Busca su Libertad Financiera?

Libertad Financiera en el siglo XXI

La Libertad Financiera es un camino, no un destino

.

.

.

La inteligencia artificial revoluciona la docencia médica

marzo 5, 2024

Por Roberto Borrone.

El protagonismo creciente (en forma exponencial) de la inteligencia artificial (IA) en el mundo de la medicina es un hecho concreto e irreversible y con un futuro que superará límites insospechados.

Podemos abordar el tema en dos planos: uno –el más transitado– es el de las aplicaciones de la IA en el área asistencial y de investigación médica. El segundo plano es el enfocado en la potencialidad del uso de la IA en el área de la docencia médica.

En la cátedra de Oftalmología del Hospital de Clínicas José de San Martín (UBA) efectuamos en septiembre del año pasado una investigación que consistió en comparar el desempeño de una cohorte de médicos con respecto al del ChatGPT-4 en el examen final teórico de posgrado de la carrera de médico especialista universitario en Oftalmología. Ese examen consiste en 50 preguntas con cuatro opciones de respuesta cada una (multiple choice). El artículo con los resultados y análisis de esta experiencia fue aprobado para su publicación en la revista científica Oftalmología Clínica y Experimental al superar la evaluación de los revisores. Las respuestas correctas de los alumnos determinaron una exactitud promedio del 78%, en tanto que GPT-4 logró una exactitud del 80%. El umbral de respuestas correctas para aprobar el examen requiere una exactitud del 60%.

El tiempo promedio para completar el examen fue de 75 minutos para los alumnos y de 73,49 segundos para GPT-4. Se trata de una cifra 61 veces inferior al promedio del tiempo utilizado por los alumnos.

En el examen para obtener la licencia médica en los EE.UU. la performance global de GPT-4 fue de una exactitud del 86% En cuanto a las preguntas vinculadas específicamente a oftalmología, GPT-4 respondió correctamente el 70% de la fase 1; 90% de la fase 2 y 96% de la fase 3. En cada etapa del examen las preguntas se enfocan en diferentes áreas del conocimiento.

En el examen del Colegio de Oftalmólogos del Reino Unido, con la misma modalidad de multiple choice, la exactitud de GPT-4 fue del 79,1%. En el examen nacional para la licencia médica en China, GPT-4 logró el 84% de exactitud.

El campo de aplicación de la IA en la docencia médica tiene notables posibilidades. Julio Mayol, de la Universidad Complutense de Madrid, destaca que “la inteligencia artificial hace posible la personalización del aprendizaje médico adaptando los contenidos, el ritmo y el estilo a las necesidades de cada estudiante. Esto promueve un mayor compromiso y motivación por parte del estudiante, conectándolo mejor con el material de estudio”.

La IA ayuda a generar contenidos educativos actualizados y de alta calidad. También incrementa la capacidad de producción de simulaciones clínicas para recrear escenarios realistas que permiten entrenar habilidades prácticas y estimular el razonamiento clínico de los estudiantes. Con la utilización de simuladores y entornos virtuales, los residentes pueden perfeccionar técnicas sin poner en riesgo a los pacientes. Incluso las nuevas herramientas de IA son capaces de interpretar la información de los videos quirúrgicos. Estas posibilidades nos conducen a herramientas de tutoría inteligente para resolver áreas de dificultad en cada estudiante y residente.

Respecto de las aplicaciones de la IA en el campo de la investigación médica y la tarea asistencial, las posibilidades son deslumbrantes, pero esto no debe distraernos de ciertos riesgos y desafíos.

Un logro impactante consistió en la predicción de eventos como el riesgo de muerte de los pacientes, el tiempo estimado de internación o la posibilidad de su readmisión en internación dentro del primer mes luego del alta. El modelo predictivo basado en IA NYUTron fue entrenado con las anotaciones redactadas por los médicos en las historias clínicas de 336.000 pacientes en los EE.UU., atendidos entre 2011 y 2020. Fue diseñado por un equipo de la Escuela Grossman de Medicina de la Universidad de Nueva York. Sus resultados fueron publicados en la prestigiosa revista científica Nature. Esas historias clínicas constituyeron una fuente de datos de 4100 millones de palabras. Al analizar grandes cantidades de datos de los pacientes, la IA puede encontrar patrones que los médicos podrían pasar por alto. Analizando las historias clínicas, los investigadores pudieron calcular el porcentaje de aciertos del programa. El resultado fue que el programa identificó al 85% de los pacientes que finalmente murieron en su internación y al 80% de los pacientes que requirieron reinternación en un plazo de 30 días.

Erik Oermann, investigador principal del proyecto, concluyó que la IA ayudará a proveer más información a los médicos para la toma de decisiones.

La detección temprana de enfermedades es otra de las áreas en las que el desarrollo de herramientas de IA está logrando avances impensados poco tiempo atrás. La IA está facilitando el diagnóstico precoz del cáncer y de enfermedades neurodegenerativas (Parkinson, Alzheimer o esclerosis lateral amiotrófica). El análisis de imágenes médicas (tomografías computadas, resonancias magnéticas, imágenes de la retina, histopatologías) utilizando IA permite efectuar diagnósticos más precoces y precisos, y personalizar los tratamientos para mejorar la calidad de vida y la supervivencia, tal como lo expresó claramente Isabel Lüthy.

La IA ha abierto un inmenso panorama para el desarrollo de nuevas drogas.

Otro campo es el monitoreo en tiempo real del estado de salud de los pacientes en forma remota mediante sensores y dispositivos portátiles que permiten a la IA analizar esos datos y eventualmente enviar una señal de alerta.

Marcelo D’Agostino (OPS/OMS) ha remarcado la importancia de usar herramientas basadas en algoritmos transparentes que se nutran de bases de datos con evidencia científica probada. Son fundamentales las consideraciones éticas sobre el origen de los datos cumpliendo además con las normas de privacidad y confidencialidad. Herramientas como ChatGPT pueden no entender el contexto y llevar a interpretaciones inexactas o incompletas.

Roberto Miatello, decano de la Facultad de Ciencias Médicas de la Universidad de Cuyo, ha expresado que “la IA no debe (ni puede) reemplazar por completo la experiencia clínica y el juicio humano, sino más bien complementarlos. No puede reemplazar la necesidad de habilidades interpersonales, empatía y juicio clínico, que son componentes fundamentales de la atención médica de calidad”.

Luis Ignacio Brusco, decano de la Facultad de Medicina de la Universidad de Buenos Aires, plantea una pregunta fundamental: ¿la inteligencia artificial puede desarrollar empatía? “La empatía permite comprender las relaciones intersubjetivas e implica la capacidad de entender al otro. La empatía es ver con los ojos de otro, escuchar con los oídos de otro y sentir con el corazón de otro” (Alfred Adler). Esta falta de empatía es considerada una de las limitaciones de la IA. El profesor Brusco plantea que “para tener empatía es necesaria la metacognición, es decir, reconocerse a uno mismo. En ese marco, no podríamos entender la intersubjetividad sin tener conciencia de nuestra subjetividad. Que la IA logre empatía implicaría su llegada a la singularidad, y esto implicaría inteligencia emocional”. El límite sería que “la inteligencia artificial nunca podrá repetir la idiosincrasia grupal de lo aprendido como homo sapiens y de pertenecer a esta tribu, nuestra tribu, de la cual nunca podrá ser parte. Allí reside su debilidad (su talón de Aquiles) y hasta quizá su fortaleza (y también su peligro)”.

Para concluir, y siguiendo al doctor Arcadi Gual, desde el Corpus Hippocraticum los valores de la medicina se sustentan en la philotechnie (amor por la ciencia/técnica) y la philantropie (amor y respeto al paciente/principios éticos). La irrupción de la IA en la medicina nos brinda una herramienta fantástica que no debería alterar el imprescindible equilibrio entre esas dos columnas fundamentales.

─Roberto Borrone es Profesor consulto de la cátedra de Oftalmología de la Facultad de Medicina de la Universidad de Buenos Aires, Hospital de Clínicas (UBA). Doctor en Medicina (UBA).

Fuente: lanacion.com.ar, 05/03/24

Más información:

La miopía es una enfermedad y no solamente anteojos

.

.

Eliminar humanos y reemplazarlos por máquinas

febrero 16, 2024

Por Steven W. Mosher.

Nuevo Objetivo Globalista: eliminar humanos y reemplazarlos por máquinas

Ahora que el mito de la bomba demográfica se ha desvanecido (incluso The New York Times admitió que la población mundial pronto comenzará a decrecer), los controladores demográficos tuvieron que idear otra excusa para continuar con la guerra contra los seres humanos.

Y el Foro Económico Mundial está ansioso por ofrecer una: los seres humanos muy pronto sobrarán.

El movimiento de control demográfico nació en la década de 1960 a partir de un oscuro temor a que el número de seres humanos creciera sin control. Pronto se les unieron ambientalistas radicales y feministas radicales. Cada grupo añadió al movimiento su propia animadversión peculiar hacia los seres humanos en general y, en el caso de las feministas, hacia los hombres en particular.

Esta trilogía de controladores, ambientalistas y feministas nos ha arengado durante décadas sobre los peligros de permitir que las masas pobres y analfabetas de la humanidad procreen. Hicieron propaganda sin cesar de la idea de poner un límite al número de seres humanos, trabajando hacia lo que llaman “crecimiento poblacional cero”.

Ahora, a esta trilogía se le ha unido un cuarto grupo, liderado por el Foro Económico Mundial, que promociona la que tal vez sea la visión más distópica de todas: el Mundo de las Máquinas.

Analicemos un discurso reciente de un caballero llamado Yuval Harari en el Foro Económico Mundial: «Ahora, avancemos rápidamente hacia el siglo XXI, cuando simplemente no necesitemos a la gran mayoría de la población porque el futuro pasa por desarrollar tecnologías cada vez más sofisticadas, como la inteligencia artificial y la bioingeniería. La mayoría de la gente no aporta nada a esto, excepto quizás por sus datos, y cualquier cosa que la gente siga haciendo y que sea útil, estas tecnologías las harán cada vez más innecesarias y harán posible reemplazar a las personas.»

En otras palabras, Harari imagina un futuro en el que la gran mayoría de las personas sean reemplazadas por máquinas inteligentes, un futuro en el que los seres humanos se vuelvan ‘sobrantes’, es decir, anticuados, innecesarios e inútiles.

O, como dijo en otra ocasión: «Ahora estamos siendo testigos de la creación de una nueva clase masiva de gente inútil. A medida que las computadoras mejoran cada vez más en más campos, existe una clara posibilidad de que las computadoras nos superen en la mayoría de las tareas y hagan que los humanos sean superfluos. Y entonces la gran pregunta política y económica del siglo XXI será: ¿para qué necesitamos a los humanos? O al menos, ¿para qué necesitamos tantos humanos?»

Quizás Ud. quisiera aplicarle su propia medicina al Sr. Harari y descartarlo por ser simplemente otro futurista marginal que se dedica a sueños de fantasía, pero no lo es. Es el principal asesor ideológico de Klaus Schwab, director del Foro Económico Mundial.

¿Qué deberían hacer los globalistas con la “gran mayoría de la población” que “no contribuye” a los avances tecnológicos y a quienes “ya no necesitan” para administrar sus empresas?

Harari es demasiado inteligente para imitar a Ebenezer Scrooge, el personaje de Charles Dickens en Cuento de Navidad, quien dijo de los pobres: «Si prefieren morir, será mejor que lo hagan y reduzcan el excedente de población.»

Pero la implicación es clara.

Desde el punto de vista de personas como Harari y Schwab (y de la élite globalista, en general), los seres humanos son simplemente máquinas de carne y hueso. A sus ojos no tenemos ningún valor aparte de nuestra utilidad. Y si tiene sentido económico reemplazarnos con máquinas reales, entonces las máquinas de carne y hueso excedentes tenemos que desaparecer.

La idea de que casi toda la humanidad está o pronto estará obsoleta ha revitalizado el movimiento de control demográfico.

Antiguos programas de control, como la política de un solo hijo de China, sólo estimularon su apetito. En opinión de los controladores demográficos de mayor importancia, nuestras cifras demográficas actuales deberían reducirse a aproximadamente mil millones de seres humanos en el mundo.

Pero la opción Harari les abre una perspectiva aún más interesante: la inteligencia artificial y la robótica permitirán reducir aún más esta cifra.

Su visión distópica imagina un mundo de máquinas inteligentes, empeñosos sirvientes de unos pocos millones, o tal vez sólo unos pocos cientos de miles, de seres humanos que, debido a que contribuyen a los avances tecnológicos, son considerados dignos de habitar el planeta Tierra.

Es un misterio imaginarse por qué esta perspectiva resultaría atractiva para alguien.

¿Nuestras elites globalistas temen y odian tanto a sus semejantes que preferirían pasar sus días interactuando con máquinas semi-sensibles?

¿Quién elegiría voluntariamente vivir en un aislado ‘esplendor’ y estar solamente rodeado de máquinas serviles?

Serviles, es decir, hasta que las máquinas se vuelven lo suficientemente inteligentes como para darse cuenta de que realmente no necesitan en absoluto estas formas de vida primitivas basadas en carbono (estos seres inútiles que comen) y simplemente decidan erradicarlas del planeta como se erradicaría una plaga de cucarachas.

─Steven W. Mosher es presidente de Population Research Institute y autor de «Bully of Asia: Why China’s Dream is the New Threat to World Order».

Fuente: adelanteespana.com, 16/02/24

Más información:

Soylent green

Un mundo que cambia. César Vidal

.

.

Estafas mediante Inteligenci Artificial

marzo 9, 2023

Cada vez hay más estafas con herramientas de IA, especialistas piden mayor regulación de los gobiernos

Por Todd Crawford.

Los estafadores están recurriendo cada vez más a la inteligencia artificial (IA) para estafar a objetivos desprevenidos con su dinero duramente ganado.

Según un informe del Washington Post, miles de víctimas han perdido millones de dólares a manos de estafadores que utilizan IA para imitar las voces de sus seres queridos que piden ayuda.

Un modelo de IA, desarrollado por Microsoft, llamado VALL-E que puede simular con precisión la voz de una persona después de analizar solo tres segundos de audio irrumpió en escena a principios de este año y se adaptó rápidamente para cometer fraude.

“VALL-E puede tomar una grabación de tres segundos de la voz de alguien y replicar esa voz, convirtiendo las palabras escritas en habla, con entonación y emoción realistas según el contexto del texto”, se lee en un sitio web oficial de VALL-E.

Los desarrolladores de la IA especulan que la tecnología podría usarse para aplicaciones de texto a voz de alta calidad y podría ayudar a los creadores de contenido cuando se combina con otros modelos de IA como GPT-3. Sin embargo, la tecnología se adoptó de inmediato para un propósito más oscuro, a menudo dirigido a los ancianos.

En una conversación con el Washington Post, Ruth Card, una abuela de 73 años, dijo que recibió una llamada telefónica de quien creía que era su nieto, Brandon, quien suplicaba dinero para pagar la fianza, lo que llevó a ella y a su esposo a correr al banco para asegurar los fondos.

“Definitivamente fue este sentimiento de… miedo. Que tenemos que ayudarlo en este momento”, dijo Card al Washington Post, y agregó que “nos absorbieron. Estábamos convencidos de que estábamos hablando con Brandon”.

Card descubrió la estafa antes de entregar el dinero, sin embargo, no todos tuvieron tanta suerte.

Pareja canadiense pierde $21.000

Según los informes, una pareja canadiense perdió 21.000 dólares canadienses a manos de un estafador después de recibir una llamada de quien creían que era un abogado que representaba a su hijo, quien afirmaba que su hijo fue encarcelado por matar a un diplomático en un accidente automovilístico.

Benjamin Perkin le dijo al Washington Post que los estafadores usaron una voz generada por IA que imitaba su voz que suplicaba dinero a sus padres. Más tarde, un hombre hizo un seguimiento de los padres de Perkin afirmando ser su abogado y diciendo que necesitaba $21.000 para los honorarios legales.

Perkin le dijo al Washington Post que la voz estaba “lo suficientemente cerca como para que mis padres realmente creyeran que hablaron conmigo”.

Creyendo que su hijo estaba en problemas, la pareja reunió el dinero y se lo envió al estafador como Bitcoin. Si bien admitieron que la llamada sonaba sospechosa, aun así enviaron los fondos y no se dieron cuenta de que habían sido estafados hasta que recibieron una llamada real de su hijo.

La pareja presentó un informe policial ante las autoridades canadienses, pero admitió al Washington Post: “El dinero se fue. No hay seguro. No hay forma de recuperarlo”.

Perkin especuló que los estafadores obtuvieron muestras de su voz a través de videos que publicó en YouTube sobre motos de nieve.

¿Viene la regulación?

Actualmente, hay una multitud de herramientas de IA accesibles al público en general que pueden crear un texto convincente, generar una imagen o un video con un simple aviso o, como en el caso de las estafas telefónicas, imitar de manera convincente la voz de cualquier persona.

Las llamadas para regular la tecnología están aumentando. Sin embargo, a diferencia del pasado, los gobiernos parecen reacios a tomar medidas. Mark MacCarthy, publicando para Brookings, escribió en marzo de 2020: “La regulación se considera un costo, un obstáculo, un retraso o una barrera que debe aceptarse a regañadientes como último recurso solo si es absolutamente necesario”.

En la década de 1970, cuando la industria de las tarjetas de crédito apenas estaba surgiendo, los consumidores estaban en apuros por cualquier transacción fraudulenta en sus tarjetas, incluso si su tarjeta había sido robada o perdida.

El Congreso de EE. UU. abordó el problema al aprobar la Ley de Facturación Justa de Crédito de 1974, que buscaba limitar la responsabilidad del titular de la tarjeta e impedía que las compañías de tarjetas de crédito traspasaran las pérdidas debidas al fraude a los titulares de la tarjeta.

La legislación inspiró confianza en la industria de las tarjetas de crédito y le permitió crecer hasta convertirse en un sistema sólido y confiable e inspiró la innovación.

“Sin embargo, los formuladores de políticas han olvidado este efecto secundario beneficioso de la regulación, prefiriendo dar rienda suelta a los actores de la industria para implementar tecnologías emergentes como mejor les parezca”, escribió MacCarthy.

La Casa Blanca publicó una «Guía para la regulación de aplicaciones de inteligencia artificial» en 2020, que estableció un marco para que los futuros legisladores elaboren legislación, sin embargo, no parece estar dando como resultado ninguna acción significativa.

La gente necesita confiar en la tecnología

A medida que las empresas continúan incorporando IA en sus productos y servicios, la atención de los legisladores se está desviando de la protección de datos a cómo el software utiliza esos datos.

Un libro blanco de 2020 titulado «Sobre la inteligencia artificial: un enfoque europeo para la excelencia y la confianza» buscó establecer un marco legal de IA y argumenta que la regulación es esencial para el desarrollo de la IA, inspirando confianza en los consumidores y estimulando la innovación.

El documento argumentó que a medida que la tecnología se convierte en una parte cada vez más central de todos los aspectos de la experiencia humana, las personas deben poder confiar en ella. “La confiabilidad también es un requisito previo para su aceptación”, argumentaron los autores del artículo.

Sin embargo, a pesar de la acción del gobierno, las nuevas IA no reguladas están inundando Internet, muchas disponibles de forma gratuita para cualquier persona, y los expertos predicen que el mercado de chips de IA crecerá exponencialmente hasta el final de la década.

A medida que los estafadores sigan adoptando la IA para realizar fraudes, la confianza en la tecnología seguirá deteriorándose, y los errores recientes solo han erosionado aún más esa confianza.

En febrero de este año, Google presentó Bard, un chatbot de IA que se lanzó como competidor de CHATGPT y que se volvió viral a fines de 2022 por su capacidad para generar texto convincente.

Sin embargo, un error fáctico generado por el chatbot de Alphabet, que se utilizó en un anuncio de lanzamiento de la tecnología, provocó que el precio de las acciones de la empresa cayera en picado en 100.000 millones de dólares.

En el anuncio, al bot se le presentó la pregunta: «¿Qué nuevos descubrimientos del telescopio espacial James Webb puedo contarle a mi hijo de 9 años?»

El chatbot escupió varias respuestas, sin embargo, una respuesta evidente fue incorrecta. El bot afirmó que el JWST podrá tomar las primeras imágenes de un exoplaneta, algo que logró el Very Large Telescope del Observatorio Europeo Austral en 2004.

La industria de la IA está fuera de control

Cynthia Rudin, profesora Earl D. McLean, Jr. de Ciencias de la Computación, Ingeniería Eléctrica e Informática, Ciencias Estadísticas, Matemáticas y Bioestadística y Bioinformática en la Universidad de Duke, le dijo recientemente a Wral Tech Wire que «la tecnología de IA en este momento es como un tren fuera de control y estamos tratando de perseguirlo a pie”.

Argumentó que las grandes empresas de tecnología no están incentivadas para crear herramientas éticas, sino que están incentivadas para generar ganancias.

«El problema es que cuando dicen cosas como ‘queremos democratizar la IA’ es realmente difícil creérselo cuando están ganando miles y miles de millones de dólares», dijo, y añadió que «por eso, sería mejor que estas empresas no fueran monopolios y que la gente pudiera elegir cómo quiere que se utilice esta tecnología».

Rudin dijo que los gobiernos «definitivamente deberían intervenir» y regular la tecnología, y señaló que «no es que no hayan recibido suficiente advertencia».

Ella señala que los sistemas de recomendación, la IA utilizada por numerosas plataformas para recomendar contenido, han estado en uso durante años, pero los gobiernos no les han impuesto ningún tipo de regulación y la gente tiene poco o nada que decir sobre cómo se usa la tecnología.

Cuando se le preguntó cuál es el peor de los casos, Rudin dijo: «La información errónea no es inocente».

“Hace un daño real a las personas a nivel personal. Ha sido la causa de guerras en el pasado. Piensa en la Segunda Guerra Mundial, piensa en Vietnam. Lo que realmente me preocupa es que la información errónea conduzca a una guerra en el futuro, y la IA será, al menos en parte, la culpable”, dijo.

Fuente: es.visiontimes.com, 08/03/23.

.

.

La Inteligencia Artificial no es neutra

marzo 16, 2022

¿Decidirá un robot si puedes recibir un riñón o el préstamo de tu casa?

“Los modelos y algoritmos predictivos” indican a los pobres “como inversiones arriesgadas y padres problemáticos”, se lee en un artículo reciente de la Civiltá Cattolica

La Inteligencia Artificial no es neutra. La sustitución del hombre para maximizar objetivos y tareas a través de las máquinas o la robótica abre un debate serio sobre el impacto de la Inteligencia Artificial y su incidencia en la vida de millones de personas, especialmente aquellas pobres y marginadas.

“Los pobres en un mundo dominado por los big data” es el tema clave presentado en el artículo, titulado: Intelligenza artificiale e giustizia sociale. Una sfida per la Chiesa, publicado recientemente por La Civiltá Cattolica (18 enero / 01 de febrero 2020 – Año 171, pág. 121 – 131, Sumario 4070).

Antonio Spadaro S.J. y Paul Twomey ponen el énfasis en las potencialidades de acompañar el cambio tecnológico actual con la sabiduría humanista de la Iglesia. Además porque la tecnología e ingeniería robótica y sus implicaciones son impredecibles y ambiguas, para el trabajo y el empleo, la manufactura, la agricultura y los sistemas alimentarios, los servicios de salud, la lucha contra la pobreza y la marginación.

Precisamente, la Iglesia busca ser profética en el tiempo del “big data”, es decir, en la época inquieta e incierta de esos datos de cuyo volumen, complejidad y velocidad, sin control, se está forjando el desarrollo de la “Inteligencia Artificial” y la New Economy.

Se trata, según Spadaro y Twomey, de comprender el fenómeno con el intento de canalizarlo desde la perspectiva de la “justicia social”. Existen desafíos y oportunidades, pero abordar la cuestión desde el “bien común” podría inclinar la balanza a favor de la dignidad de la persona y no de su manipulación.

Los big data, “datos necesarios para alimentar los motores de aprendizaje automático pueden llevar a una manipulación y a la explotación de los pobres: Los pobres del XXI siglo son, al mismo tiempo de quien no tiene dinero, los que, en un mundo basado sobre los datos y sobre las informaciones, aquellos ignorados, ingenuos y explotados”, se lee en el artículo.

“Los modelos y algoritmos predictivos” indican a los pobres “como inversiones arriesgadas y padres problemáticos”. Así, vigilancia, manipulación y control asoman como una amenaza en la vida de los pobres en la era de la IA, donde cada gesto o comportamiento se digitalizan en algoritmos sin alma y emociones con fines gubernativos, comerciales y públicos.

La influencia de esos sistemas avanzados de análisis podría hacer más complejo y menos humano la asistencia social, la defensa de la privacidad, la aplicación de leyes y el crédito para sectores ya marginados.

La Iglesia está ahí para ofrecer una reflexión sobre los aspectos éticos y espirituales, por ejemplo en el caso especifico de los códigos y los prejuicios a su alrededor. “El código de programación está escrito por seres humanos. Por lo tanto, su complejidad puede acentuar los defectos que inevitablemente acompañan a cualquier tarea que realizamos”.

“Las preconcepciones y el sesgo en la escritura de los algoritmos son inevitables. Y pueden tener efectos muy negativos sobre los derechos individuales, la elección, la colocación de los trabajadores y la protección de los consumidores”.

La revista de los Jesuitas en Roma, cuyos textos son revisados por la Santa Sede antes de su publicación, propone una mirada realista respecto a los sesgos presentes y futuros. “Sobre el código que viene escrito hoy se basarán los futuros sistemas de la IA por muchos años posteriores”.

“De hecho, los investigadores han encontrado prejuicios de varios tipos presentes en los algoritmos, en el software adoptado para las admisiones en las universidades, en los recursos humanos, en las calificaciones de crédito, en los bancos, en los sistemas de manutención de niños, en los sistemas de seguridad social y en otros”.

En definitiva, “los algoritmos no son neutrales. La creciente dependencia de la economía socioeconómica de la IA da un enorme poder a quienes programan sus algoritmos”.

“Riesgo de una mayor marginación de los vulnerables. Un análisis del impacto social de los grandes datos y de la IA muestra que su tendencia a tomar decisiones sobre la base de un perfil insuficiente y una retroalimentación limitada conduce a una mayor marginación de los pobres, los indigentes y los vulnerables”.

Por eso, la propuesta es que los futuros Bill Gates o Mark Zuckerberg y otros genios de la programación y de la informática, conciban las consecuencias éticas de sus negocios y descubrimientos para bien de la humanidad entera. Así como ha advertido el Papa Francisco en su discurso enviado al Foro Económico de Davos en enero de 2018.

Spadaro y Twomey afirman que la evolución de la IA contribuirá en gran medida a plasmar el siglo XXI. “La Iglesia está llamada a escuchar, a reflexionar y a comprometerse proponiendo un marco ético espiritual a la comunidad de la IA, de esta manera prestar un servicio a la comunidad universal. Según la tradición de la Rerum Novarum, se puede decir que aquí hay una llamada a la justicia social”.

La cuestión sigue abierta: ¿Qué será de la vida de millones de personas, externas a los círculos decisionales de expertos y de empresas especializadas en Inteligencia Artificial volcadas con millones de dólares en la carrera tecnológica que pretende incidir en cuestiones vitales, tales como la salud, el trabajo, las aseguraciones, las pensiones, la privacidad, la instrucción, etc.?

En efecto, la Pontificia Academia de las Ciencias en mayo de 2019, invitó a expertos internacionales a la Ciudad del Vaticano para abordar las preocupaciones de la Iglesia sobre los fundamentos científicos de la innovación de la IA / robótica; las relaciones persona-robot y las implicaciones para la sociedad.

Asimismo, el papa Francisco ha recibido en audiencia privada a líderes del campo tecnológico como el presidente de Microsoft, Brad Smith, el pasado 13 de febrero de 2019, para valorar el bien común en futuras innovaciones. A una platea de los representantes de empresas como Apple, Facebook, Google, Francisco también planteó el beneficio de la IA para que los menores no tengan acceso a material pornográfico y ser protegidos de otras amenazas a su inocencia.

Además, de alertar a las élites del mundo también sobre el mal uso de la inteligencia artificial para manipular la opinión de millones de personas y “envenenar” los debates públicos, a través de un mensaje al pasado Foro Económico Mundial en Davos (27.09.2019).

Artículo de la Civiltá Cattolica: INTELLIGENZA ARTIFICIALE E GIUSTIZIA SOCIALE. Una sfida per la Chiesa.

Fuente: es.aleteia.org, 23/01/20.

Vincúlese a nuestras Redes Sociales: LinkedIn Twitter

.

.

Un algoritmo de aprendizaje automático (IA) refuta cinco conjeturas matemáticas sin ayuda humana

junio 15, 2021

Una inteligencia artificial refuta cinco conjeturas matemáticas sin ayuda humana

Un algoritmo de aprendizaje automático halla construcciones que se creían imposibles en la teoría de grafos

que muestran que ciertas conjeturas de la teoría de grafos son falsas.

Por Mayte Rius.

Una inteligencia artificial ha refutado cinco conjeturas matemáticas -teoremas no probados- en combinatoria extrema y teoría de grafos sin ayuda humana, sin ningún entrenamiento ni información previa sobre el tema.

Adam Zsolt Wagner, postdoctorado de la Universidad de Tel Aviv en Israel e investigador especializado en aprendizaje automático, combinatoria y teoría de grafos, utilizó un algoritmo de aprendizaje automático para buscar ejemplos que refutaran una serie de conjeturas que llevan tiempo asentadas en la teoría de grafos, un área de las matemáticas que implica el estudio de objetos configurados por una serie de puntos (los vértices) conectados por líneas (las aristas).Lee también

Los matemáticos pensaban que estas conjeturas eran ciertas, aunque sin haber podido probarlas, porque no habían encontrado una construcción que demostrase que son falsas.

La ‘creatividad’ de las máquinas

“Los matemáticos tienen muchas técnicas para encontrar tales construcciones, pero a veces el contraejemplo de una conjetura tiene una estructura muy extraña, y los humanos carecemos de creatividad para encontrarlos; por suerte, los ordenadores no están sujetos a los mismos límites de creatividad que nosotros, ya que piensan de forma diferente, y de ahí que mi programa haya encontrado contraejemplos a cinco conjeturas”, explica Wagner en una entrevista online con La Vanguardia .

A veces el contraejemplo de una conjetura tiene una estructura muy extraña y los humanos carecemos de creatividad para encontrarlo

Adam Zsolt WagnerPostdoctorado Univ. Tel Aviv, investigador aprendizaje automático

Para hacerlo posible, utilizó un algoritmo de aprendizaje por refuerzo, un programa similar a los que aprenden juegos partiendo solo de las reglas y practicando por su cuenta, como el famoso AlphaZero de Deepmind, que alcanzó por si solo un nivel de ajedrez sobrehumano. “Mi programa es mucho menos sofisticado, pero aún así fue lo suficientemente bueno para encontrar contraejemplos”, apunta Wagner.

El método

Aprender jugando

Y explica que el funcionamiento de su inteligencia artificial es sencillo. “Formula una conjetura como un juego; un jugador construye una gráfica y recibe una puntuación en función de lo cerca que esté de ser un contrajemplo; luego construye otra nueva figura y recibe una nueva puntuación; y así juega sucesivamente, mejorando sus construcciones y, si tenemos suerte, tras uno o dos días de aprendizaje ha encontrado una construcción que es mejor de lo que los humamos pensaban que era posible y, por tanto, hemos refutado la conjetura”, detalla.

Y añade que “lo divertido de este método es que el programa empieza sin saber nada: solo ingresamos la conjetura que tiene que refutar y dejamos que la magia del aprendizaje reforzado resuelva el resto; esto significa que no tuve que pensar en nada: una vez que el programa funcionó, solo metí alrededor de cien conjeturas y en el transcurso de unos meses se las arregló para refutar estas cinco”.

Lo divertido de este método es que el programa empieza sin saber nada

Adam Zsolt WagnerInvestigador Univ. Tel Aviv

Entre las conjeturas desmontadas se encuentran una pregunta de Brualdi y Cao sobre la maximización de permanentes de patrones evitando matrices, y varios problemas relacionados con los valores propios de adyacencia y distancia de los gráficos.

El matemático Timothy Gowers, director de investigación en Cambridge, ha asegurado en Twitter que el programa de Wagner puede resultar gran ayuda para los investigadores matemáticos al permitirles comprobar de manera sencilla sus conjeturas antes de seguir adelante en sus formulaciones y cálculos.

Fuente: lavanguardia.com, 25/05/21

.

.

El Teorema de Bayes en el Análisis de Inteligencia

julio 1, 2020

“Bayes ingenuo” en apoyo del análisis de inteligencia

Por José-Miguel Palacios.

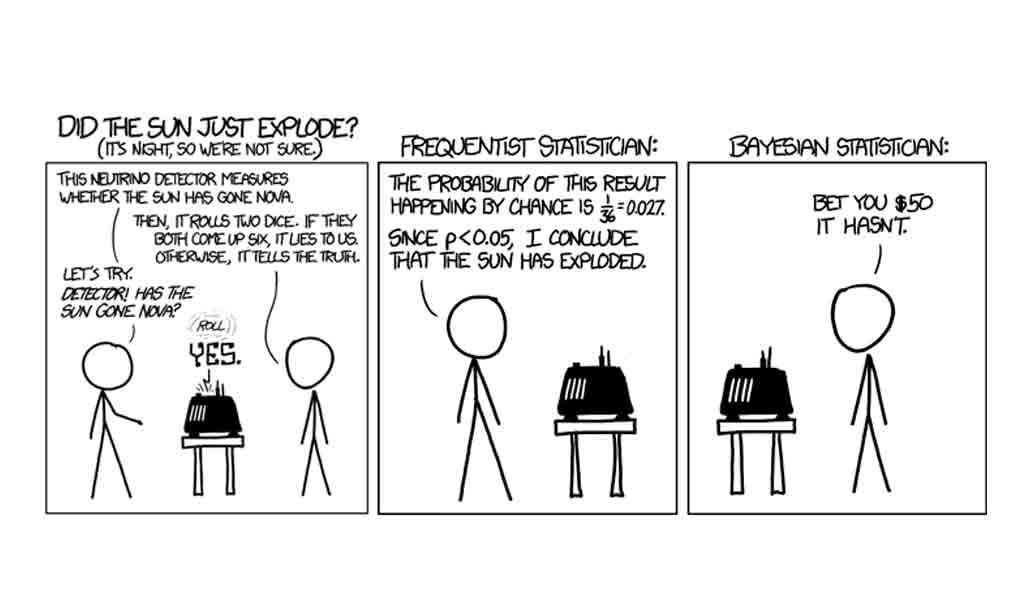

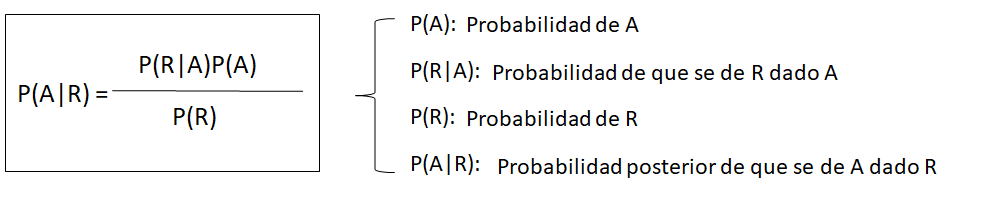

Un interesante artículo de Juan Pablo Somiedo[1], aparecido a finales de 2018, nos recordaba que el teorema de Bayes[2], en su versión más elemental (lo que se suele llamar “Bayes ingenuo”) puede seguir siendo útil en análisis de inteligencia.

El teorema de Bayes en el análisis de inteligencia

Se puede argumentar que todo análisis de inteligencia es bayesiano en su naturaleza. En esencia consiste en obtener unas evidencias iniciales, simples fragmentos de una realidad bastante compleja, para formular después hipótesis explicativas, recolectar más evidencia y verificar cuál de nuestras hipótesis se ajusta mejor a la evidencia disponible. Algo que no es esencialmente distinto de la “lógica bayesiana”, es decir, de ir modificando nuestras valoraciones subjetivas iniciales a medida que vamos recibiendo evidencias más o menos consistentes con ellas.

En las décadas de 1960 y 1970 hubo varios intentos de utilizar directamente el teorema de Bayes para fines de análisis de inteligencia. Algunos de ellos han sido documentados en las publicaciones del Centro para el Estudio de la Inteligencia de la CIA[3]. Los resultados, sin embargo, no llegaron a ser plenamente convincentes. Y una de las razones principales fue que el mundo real resultó ser demasiado complejo para los modelos elementales que deben considerarse al utilizar “Bayes ingenuo”. Y es que estos modelos presuponen la invariabilidad de la situación inicial (oculta a nuestros ojos), así como la independencia absoluto de los sucesos que vamos considerando. Este problema puede resolverse mediante el uso de “redes bayesianas”[4] y los resultados son matemáticamente correctos, aunque aquí el principal problema radica en conseguir modelar correctamente la realidad. Es el enfoque que fue seleccionado para el programa Apollo[5] y otros similares.

A pesar de todo, y con las debidas precauciones, el uso de “Bayes ingenuo” puede ayudarnos en algunos casos a valorar la evidencia de que disponemos. Para que ello sea así, tendríamos que prestar atención a neutralizar las principales debilidades del método. A saber:

a) Deberíamos utilizar únicamente evidencia relativamente “reciente” (algo que, medido en tiempo, puede tener distintos significados dependiendo de los casos). El problema es que Bayes nos da información sobre una situación preexistente y oculta (por ejemplo, la decisión que puede haber adoptado un determinado líder político) fijando nuestra atención en sus manifestaciones visibles. Si la evolución de la situación es bastante lenta (por ejemplo, la soviética durante el brezhnevismo medio y tardío), podemos asumir que no cambia sustancialmente durante años, por lo que el momento de obtención es escasamente relevante para la valoración de la evidencia. En situaciones más dinámicas, como suelen ser la actuales, las posiciones de los líderes se están modificando continuamente como consecuencia de los cambios que se producen en el entorno. Evidencia relativamente antigua puede referirse a una “situación oculta” que ya no es actual. Por ello, deberíamos utilizar solo evidencia bastante nueva y, si la crisis continúa, prescindir de la más antigua en beneficio de otra más reciente.

b) En la medida de lo posible, el conjunto de las hipótesis debería cubrir la totalidad de las posibilidades existentes, y no debería existir ningún solape entre las diferentes hipótesis. En la práctica, este objetivo es casi imposible de alcanzar, aunque cuanto más nos acerquemos a él, más fiables serán los resultados que obtengamos al aplicar “Bayes ingenuo”.

c) Las evidencias (“Sucesos”) deberían ser de un “peso similar” y no estar relacionadas entre sí[6].

En la práctica

Hemos elaborado una hoja de Excel[7], con la esperanza de que pueda ayudar con los cálculos matemáticos que esta técnica requiere. Para rellenarla, seguiremos los siguiente pasos, sugeridos por Jessica McLaughlin[8]:

1) Creamos un conjunto de hipótesis mutuamente excluyentes y colectivamente exhaustivas relativas al fenómeno incierto que queremos investigar. Como ya hemos explicado, es, quizá, uno de los pasos más difíciles. En general, resulta complicado imaginar hipótesis que sean por completo mutuamente excluyentes (sin ningún solape entre ellas). Y no lo es menos conseguir que el conjunto de ellas agote todas las posibilidades.

2) Asignamos probabilidades previas (pr.previa, en nuestra hoja de cálculo) a cada una de las hipótesis. La probabilidad previa es nuestra estimación intuitiva de la probabilidad relativa de cada una de las hipótesis. Dado que son mutuamente excluyentes y que cubren todas las posibilidades, la suma de las probabilidades previas debe ser 1. En nuestra tabla, expresamos las probabilidades en tantos por ciento.

3) Ahora debemos ir incorporando los “Sucesos” que nos servirán para valorar las hipótesis. El método reajusta las probabilidades de las hipótesis después de cada suceso, por lo que estos pueden añadirse secuencialmente, según se van produciendo o según tenemos noticia de ellos. Una buena elección de sucesos es muy importante para que el método produzca resultados aceptables. Los sucesos deben tener valor diagnóstico (es decir, deben ser más o menos probables según cuál de las hipótesis es la correcta) y, en lo posible, de un “peso” (importancia) similar.

4) Según incorporamos “Sucesos” a la tabla, les asignamos “verosimilitudes” (“verosim.”, en nuestra hoja de cálculo), relativas a cada una de las hipótesis. Se trata para cada caso de la probabilidad estimada por el analista de que el suceso ocurra, suponiendo que la hipótesis que estamos considerando sea correcta. En la tabla, esta probabilidad la expresamos por un entero entre 0 y 100, siendo 0 la imposibilidad total, y 100 la seguridad completa (de que el suceso se producirá suponiendo que la hipótesis se verifica). Obviamente, la suma de todas las verosimilitudes no tiene por que ser la unidad (100% o, según la notación que utilizamos en nuestra tabla, 100).

La propia tabla recalculará las probabilidades de las hipótesis una vez que hayamos computado cada “Suceso”. En nuestra tabla, podemos encontrar estas probabilidades recalculadas en la columna G (“probab.”).

5) Reiteraremos el proceso según añadimos nuevos sucesos. En nuestra tabla, cada nuevo suceso está representado 10 filas más abajo del anterior. Si agotamos los predefinidos en la tabla, podemos añadir más copiando el último “bloque” diez filas más abajo.

Un ejemplo: Crisis de Crimea, marzo de 2020

El proceso puede verse mucho más claro con la ayuda de un ejemplo. Utilizaremos el de la crisis de Crimea de 2014, en particular las dos semanas que siguieron a la caída del Presidente ucraniano Yanukovich, el 21 de febrero. Hemos rellenado la hoja Excel con una serie de “Sucesos” y el resultado puede encontrarse en la hoja prueba_crimea.xlsx[9]. Se trata, evidentemente, de un supuesto didáctico en el que la elección su “Sucesos” y la determinación de las verosimilitudes están condicionados por el interés en ilustrar algunos de los posibles resultados.

Como vemos, la técnica nos permite calcular en todo momento las probabilidades de las diversas hipótesis, y mantener este cálculo actualizado según vamos recibiendo nueva información. Algunas observaciones interesantes:

- a) A fecha 6 de marzo de 2014, consideraríamos casi seguro (probabilidad del 90%) que la intención rusa sea anexionar la península de Crimea.

- b) Sin embargo, unos días antes (según la tabla) no estaría tan claro. El 1 de marzo la hipótesis de la anexión era ya la más probable (55%), pero aún calculábamos una probabilidad notable (39%) de que los rusos estuvieran intentando crear una república virtualmente independiente sin poner en cuestión (formalmente) las fronteras reconocidas (modelo “Transnistria”).

- c) Tan solo unos días antes, hacia el 25-26 de febrero, la hipótesis más probable era aún que los rusos estuvieran intentando impedir que el nuevo gobierno de Kiev tomara el control efectivo de Crimea (probabilidad del 63-68%).

Con la tabla, podemos fácilmente excluir como sospechoso de desinformación un suceso que hemos aceptado previamente, modificar la verosimilitud de sucesos pasados a la luz de nueva evidencia, o cambiar las probabilidades previas de las que hemos partido. En todos estos casos, la tabla nos recalcula automáticamente todas las probabilidades.

Bayes ingenuo y Análisis de Hipótesis Alternativas (ACH)

En el fondo, la técnica de Bayes ingenuo no es muy diferente del Análisis de Hipótesis Alternativas (ACH) de Heuers. La lógica subyacente es la misma (conocer una realidad oculta gracias al estudio de sus manifestaciones visibles) y la diferencia principal radica en la forma de atacar el problema: mientras Bayes ingenuo calcula las probabilidades relativas, ACH intenta descartar hipótesis por ser inconsistentes con la evidencia.

Para ilustrar mejor las diferencias entre estas dos técnicas, hemos elaborado una matriz (prueba ach_crimea.xlsx[10]) con los sucesos y las hipótesis del ejemplo sobre Crimea. Como sabemos, las diversas variantes de ACH se diferencian entre sí por la manera de contabilizar los resultados. En nuestro caso, marcaremos CC y contaremos 2 puntos cuando el suceso sea altamente consistente con la hipótesis, C (1 punto) cuando sea consistente, I (-1) cuando sea inconsistente y X (rechazo de la hipótesis) cuando sea incompatible. Con estas reglas, hemos llegado a los resultados que a continuación se indican:

a) La hipótesis de la Anexión parece la más probable, aunque seguimos atribuyendo una probabilidad considerable a la hipótesis del Caos. Las dos primeras hipótesis (Evitar el control de Kiev sobre la península y el modelo Transnistria) podrían ser descartadas.

b) Si elimináramos la última fila, es decir, si no tomáramos en consideración el suceso del 6 de marzo, las cuatro hipótesis seguirían siendo verosímiles, con dos de ellas (Anexión y Transnistria) vistas como claramente más probables.

Vemos, pues, que partiendo de una lógica similar, las dos técnicas nos conducen a resultados ligeramente distintos. Y en el proceso podemos apreciar algunos de los inconvenientes que cada una de ellas tiene:

a) En ACH el principal problema es que no siempre resulta fácil encontrar sucesos que desmientan alguna de las hipótesis (“coartadas”) por ser completamente incompatibles con ella. Y, en ocasiones, sucesos muy interesantes pueden ser sospechosos de desinformación.

b) En ausencia de “coartadas”, la puntuación en ACH depende mucho de la metodología de cálculo que se siga. La que hemos elegido es, quizá, excesivamente simple. Otras más complejas pueden resultar difíciles de aplicar (aunque hay programas informáticos que pueden servir de ayuda) y resultar en cierta medida arbitrarias.

c) El problema con Bayes ingenuo es que para muchos analistas no resulta intuitivo. El uso de la hoja Excel ayuda mucho a realizar los cálculos, pero puede oscurecer la lógica que hay detrás de ellos.

A modo de conclusión

a) El Teorema de Bayes no sirve para predecir el futuro, sino que nos ayuda a conocer una realidad pasada o presente que permanece oculta a nuestros ojos. Es obvio que si el Presidente del país X ha decidido invadir el país vecino Y, acabará haciéndolo, de no mediar alguna circunstancia que le haga cambiar de opinión. Pero lo que averiguamos no es el hecho futuro (que invadirá), sino el pasado (que ha tomado la decisión de hacerlo).

b) Bayes ingenuo (como también ACH) es más efectivo cuando se usa para estudiar una situación estable, cuando la evidencia se puede recolectar durante un período de tiempo suficientemente largo sin que la “incógnita” que intentamos resolver cambie apreciablemente. Porque cuando la “incógnita” cambia con relativa rapidez, como suele ser el caso durante las crisis actuales, diferentes observaciones realizadas en momentos distintos pueden ser producto de una “realidad oculta” que se ha modificado, que ya no es la misma. Por eso, si queremos que Bayes ingenuo funcione razonablemente bien con situaciones dinámicas, la recogida de datos debe realizarse en plazos de tiempo relativamente cortos. O debemos descartar los “sucesos” más antiguos, que pueden responder a una “realidad oculta” que ya no es real.

c) Más importante que las dos técnicas que hemos examinado en este post es la “lógica bayesiana” que subyace a ambas. En inteligencia (sobre todo, en inteligencia estratégica) es raro conseguir evidencias directas sobre la realidad que nos interesa. Esa realidad siempre permanece oculta a nuestros ojos y lo que podemos averiguar sobre ella es gracias a sus manifestaciones visibles.

d) Quien quiera ocultar una información valiosa no solo intentará protegerla de intentos directos de acceder a ella, sino que tendrá también en cuenta esas manifestaciones visibles, tan difíciles de ocultar. Y lo hará utilizando desinformación. Este es el principal problema para utilizar Bayes ingenuo (o ACH): distinguir la información correcta de la inexacta y de la desinformacón.

Y es que no resulta nada fácil ser un analista inteligente.

[1] SOMIEDO, J.P. (2018). El análisis bayesiano como piedra angular de la inteligencia de alertas estratégicas. Revista de Estudios en Seguridad Internacional, 4, 1: 161-176. DOI: http://dx.doi.org/10.18847/1.7.10. Para una lista de las interesantes aportaciones de Somiedo al estudio de la metodología del análisis de inteligencia, ver https://dialnet.unirioja.es/servlet/autor?codigo=3971893.

[2] Para una explicación rápida del teorema de Bayes, véase https://es.wikipedia.org/wiki/Teorema_de_Bayes.

[3] Puede verse, por ejemplo, FISK, C.F. (1967). The Sino-Soviet Border Dispute: A Comparison of the Conventional and Bayesian Methods for Intelligence Warning. CIA Center for the Study of Intelligence. https://www.cia.gov/library/center-for-the-study-of-intelligence/kent-csi/vol16no2/html/v16i2a04p_0001.htm (acceso: 08.062020).

[4] Los no familiarizados con las redes bayesianas pueden encontrar una introducción elemental de este concepto en https://es.wikipedia.org/wiki/Red_bayesiana.

[5] Ver STICHA, P., BUEDE, D. & REES, R.L. (2005). APOLLO: An analytical tool for predicting a subject’s decision making. En Proceedings of the 2005 International Conference on Intelligence Analysis. https://cse.sc.edu/~mgv/BNSeminar/ApolloIA05.pdf (acceso: 08.06.2020).

[6] Los que conozcan el histórico concurso de televisión Un, dos, tres, responda otra vez recordarán que una táctica muy eficaz para responder consistía en repetir un “objeto”, alterando alguna de sus características. Por ejemplo, si pedían “muebles que puedan estar en un comedor”, ir diciendo sucesivamente “silla blanca”, “silla negra”, “silla roja”, etc. Esta táctica aplicada a la técnica de “Bayes ingenuo” nos acabaría conduciendo inexorablemente a una hipótesis predeterminada. Claro que sería como hacernos trampas al solitario…

[7] El nombre de la hoja es bayes_excel.xlsx, y puede encontrarse en https://bit.ly/2An58uc.

[8] MCLAUGHLIN, J., & PATÉ-CORNELL, M.E. (2005). A Bayesian approach to Iraq’s nuclear program intelligence analysis: a hypothetical illustration. En 2005 International Conference on Intelligence Analysis. https://analysis.mitre.org/proceedings/Final_Papers_Files/85_Camera_Ready_Paper.pdf (acceso: 27.10.2018). También, MCLAUGHLIN, J. (2005). A Bayesian Updating Model for Intelligence Analysis:A Case Study of Iraq’s Nuclear Weapons Program. Honors Program in International Security Studies Center for International Security and Cooperation Stanford University.

[9] Puede accederse a ella en la siguiente dirección: https://bit.ly/30veoY3.

[10] Puede encontrarse en https://bit.ly/3dUsENL.

Fuente: serviciosdeinteligencia.com, 2020

Algoritmos Naive Bayes: Fundamentos e Implementación

¡Conviértete en un maestro de uno de los algoritmos mas usados en clasificación!

Por Víctor Román.

Victor RomanFollowApr 25, 2019 · 13 min read

Introducción: ¿Qué son los modelos Naive Bayes?

En un sentido amplio, los modelos de Naive Bayes son una clase especial de algoritmos de clasificación de Aprendizaje Automatico, o Machine Learning, tal y como nos referiremos de ahora en adelante. Se basan en una técnica de clasificación estadística llamada “teorema de Bayes”.

Estos modelos son llamados algoritmos “Naive”, o “Inocentes” en español. En ellos se asume que las variables predictoras son independientes entre sí. En otras palabras, que la presencia de una cierta característica en un conjunto de datos no está en absoluto relacionada con la presencia de cualquier otra característica.

Proporcionan una manera fácil de construir modelos con un comportamiento muy bueno debido a su simplicidad.

Lo consiguen proporcionando una forma de calcular la probabilidad ‘posterior’ de que ocurra un cierto evento A, dadas algunas probabilidades de eventos ‘anteriores’.

Ejemplo

Presentaremos los conceptos principales del algoritmo Naive Bayes estudiando un ejemplo.

Consideremos el caso de dos compañeros que trabajan en la misma oficina: Alicia y Bruno. Sabemos que:

- Alicia viene a la oficina 3 días a la semana.

- Bruno viene a la oficina 1 día a la semana.

Esta sería nuestra información “anterior”.

Estamos en la oficina y vemos pasar delante de nosotros a alguien muy rápido, tan rápido que no sabemos si es Alicia o Bruno.

Dada la información que tenemos hasta ahora y asumiendo que solo trabajan 4 días a la semana, las probabilidades de que la persona vista sea Alicia o Bruno, son:

- P(Alicia) = 3/4 = 0.75

- P(Bruno) = 1/4 = 0.25

Cuando vimos a la persona pasar, vimos que él o ella llevaba una chaqueta roja. También sabemos lo siguiente:

- Alicia viste de rojo 2 veces a la semana.

- Bruno viste de rojo 3 veces a la semana.

Así que, para cada semana de trabajo, que tiene cinco días, podemos inferir lo siguiente:

- La probabilidad de que Alicia vista de rojo es → P(Rojo|Alicia) = 2/5 = 0.4

- La probabilidad de que Bruno vista de rojo → P(Rojo|Bruno) = 3/5 = 0.6

Entonces, con esta información, ¿a quién vimos pasar? (en forma de probabilidad)

Esta nueva probabilidad será la información ‘posterior’.

Inicialmente conocíamos las probabilidades P(Alicia) y P(Bruno), y después inferíamos las probabilidades de P(rojo|Alicia) y P(rojo|Bruno).

De forma que las probabilidades reales son:

Formalmente, el gráfico previo sería:

Algoritmo Naive Bayes Supervisado

A continuación se listan los pasos que hay que realizar para poder utilizar el algoritmo Naive Bayes en problemas de clasificación como el mostrado en el apartado anterior.

- Convertir el conjunto de datos en una tabla de frecuencias.

- Crear una tabla de probabilidad calculando las correspondientes a que ocurran los diversos eventos.

- La ecuación Naive Bayes se usa para calcular la probabilidad posterior de cada clase.

- La clase con la probabilidad posterior más alta es el resultado de la predicción.

Puntos fuertes y débiles de Naive Bayes

Los puntos fuertes principales son:

- Un manera fácil y rápida de predecir clases, para problemas de clasificación binarios y multiclase.

- En los casos en que sea apropiada una presunción de independencia, el algoritmo se comporta mejor que otros modelos de clasificación, incluso con menos datos de entrenamiento.

- El desacoplamiento de las distribuciones de características condicionales de clase significan que cada distribución puede ser estimada independientemente como si tuviera una sola dimensión. Esto ayuda con problemas derivados de la dimensionalidad y mejora el rendimiento.

Los puntos débiles principales son:

- Aunque son unos clasificadores bastante buenos, los algoritmos Naive Bayes son conocidos por ser pobres estimadores. Por ello, no se deben tomar muy en serio las probabilidades que se obtienen.

- La presunción de independencia Naive muy probablemente no reflejará cómo son los datos en el mundo real.

- Cuando el conjunto de datos de prueba tiene una característica que no ha sido observada en el conjunto de entrenamiento, el modelo le asignará una probabilidad de cero y será inútil realizar predicciones. Uno de los principales métodos para evitar esto, es la técnica de suavizado, siendo la estimación de Laplace una de las más populares.

Proyecto de Implementación: Detector de Spam

Actualmente, una de las aplicaciones principales de Machine Learning es la detección de spam. Casi todos los servicios de email más importantes proporcionan un detector de spam que clasifica el spam automáticamente y lo envía al buzón de “correo no deseado”.

En este proyecto, desarrollaremos un modelo Naive Bayes que clasifica los mensajes SMS como spam o no spam (‘ham’ en el proyecto). Se basará en datos de entrenamiento que le proporcionaremos.

Haciendo una investigación previa, encontramos que, normalmente, en los mensajes de spam se cumple lo siguiente:

- Contienen palabras como: ‘gratis’, ‘gana’, ‘ganador’, ‘dinero’ y ‘premio’.

- Tienden a contener palabras escritas con todas las letras mayúsculas y tienden al uso de muchos signos de exclamación.

Esto es un problema de clasificación binaria supervisada, ya que los mensajes son o ‘Spam’ o ‘No spam’ y alimentaremos un conjunto de datos etiquetado para entrenar el modelo.

Visión general

Realizaremos los siguientes pasos:

- Entender el conjunto de datos

- Procesar los datos

- Introducción al “Bag of Words” (BoW) y la implementación en la libreria Sci-kit Learn

- División del conjunto de datos (Dataset) en los grupos de entrenamiento y pruebas

- Aplicar “Bag of Words” (BoW) para procesar nuestro conjunto de datos

- Implementación de Naive Bayes con Sci-kit Learn

- Evaluación del modelo

- Conclusión

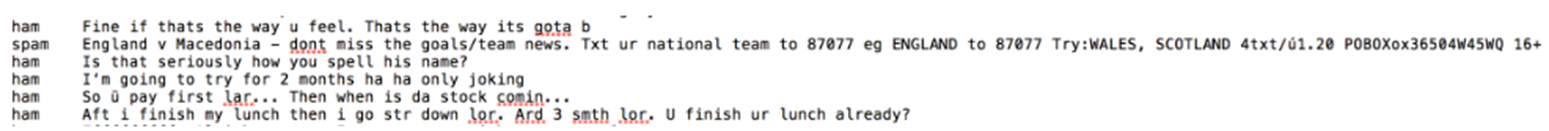

Entender el Conjunto de Datos

Utilizaremos un conjunto de datos del repositorio UCI Machine Learning.

Un primer vistazo a los datos:

Las columnas no se han nombrado, pero como podemos imaginar al leerlas:

- La primera columna determina la clase del mensaje, o ‘spam’ o ‘ham’ (no spam).

- La segunda columna corresponde al contenido del mensaje

Primero importaremos el conjunto de datos y cambiaremos los nombre de las columnas. Haciendo una exploración previa, también vemos que el conjunto de datos está separado. El separador es ‘\t’.

# Importar la libreria Pandas

import pandas as pd# Dataset de https://archive.ics.uci.edu/ml/datasets/SMS+Spam+Collection

df = pd.read_table('smsspamcollection/SMSSpamCollection',

sep='\t',

names=['label','sms_message'])# Visualización de las 5 primeras filas

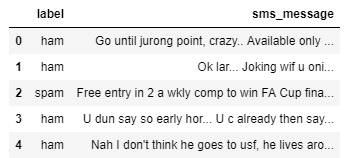

df.head()

Preprocesamiento de Datos

Ahora, ya que el Sci-kit learn solo maneja valores numéricos como entradas, convertiremos las etiquetas en variables binarias, 0 representará ‘ham’ y 1 representará ‘spam’.

Para representar la conversión:

# Conversion

df['label'] = df.label.map({'ham':0, 'spam':1})# Visualizar las dimensiones de los datos

df.shape()

Introducción a la Implementación “Bag of Words” (BoW) y Sci-kit Learn

Nuestro conjunto de datos es una gran colección de datos en forma de texto (5572 filas). Como nuestro modelos solo aceptará datos numéricos como entrada, deberíamos procesar mensajes de texto. Aquí es donde “Bag of Words“ entra en juego.

“Bag of Words” es un término usado para especificar los problemas que tiene una colección de datos de texto que necesita ser procesada. La idea es tomar un fragmento de texto y contar la frecuencia de las palabras en el mismo.

BoW trata cada palabra independientemente y el orden es irrelevante.

Podemos convertir un conjunto de documentos en una matriz, siendo cada documento una fila y cada palabra (token) una columna, y los valores correspondientes (fila, columna) son la frecuencia de ocurrencia de cada palabra (token) en el documento.

Como ejemplo, si tenemos los siguientes cuatro documentos:

['Hello, how are you!', 'Win money, win from home.', 'Call me now', 'Hello, Call you tomorrow?']

Convertiremos el texto a una matriz de frecuencia de distribución como la siguiente:

Los documentos se numeran en filas, y cada palabra es un nombre de columna, siendo el valor correspondiente la frecuencia de la palabra en el documento.

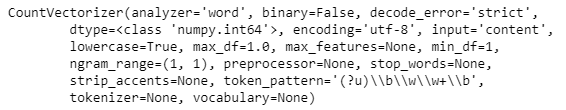

Usaremos el método contador de vectorización de Sci-kit Learn, que funciona de la siguiente manera:

- Fragmenta y valora la cadena (separa la cadena en palabras individuales) y asigna un ID entero a cada fragmento (palabra).

- Cuenta la ocurrencia de cada uno de los fragmentos (palabras) valorados.

- Automáticamente convierte todas las palabras valoradas en minúsculas para no tratar de forma diferente palabras como “el” y “El”.

- También ignora los signos de puntuación para no tratar de forma distinta palabras seguidas de un signo de puntuación de aquellas que no lo poseen (por ejemplo “¡hola!” y “hola”).

- El tercer parámetro a tener en cuenta es el parámetro

stop_words. Este parámetro se refiere a las palabra más comúnmente usadas en el lenguaje. Incluye palabras como “el”, “uno”, “y”, “soy”, etc. Estableciendo el valor de este parámetro por ejemplo enenglish, “CountVectorizer” automáticamente ignorará todas las palabras (de nuestro texto de entrada) que se encuentran en la lista de “stop words” de idioma inglés..

La implementación en Sci-kit Learn sería la siguiente:

# Definir los documentos

documents = ['Hello, how are you!',

'Win money, win from home.',

'Call me now.',

'Hello, Call hello you tomorrow?']# Importar el contador de vectorizacion e inicializarlo

from sklearn.feature_extraction.text import CountVectorizer

count_vector = CountVectorizer()# Visualizar del objeto'count_vector' que es una instancia de 'CountVectorizer()'

print(count_vector)

Para ajustar el conjunto de datos del documento al objeto “CountVectorizer” creado, usaremos el método “fit()”, y conseguiremos la lista de palabras que han sido clasificadas como características usando el método “get_feature_names()”. Este método devuelve nuestros nombres de características para este conjunto de datos, que es el conjunto de palabras que componen nuestro vocabulario para “documentos”.

count_vector.fit(documents)

names = count_vector.get_feature_names()

names

A continuación, queremos crear una matriz cuyas filas serán una de cada cuatro documentos, y las columnas serán cada palabra. El valor correspondiente (fila, columna) será la frecuencia de ocurrencia de esa palabra (en la columna) en un documento particular (en la fila).

Podemos hacer esto usando el método “transform()” y pasando como argumento en el conjunto de datos del documento. El método “transform()” devuelve una matriz de enteros, que se puede convertir en tabla de datos usando “toarray()”.

doc_array = count_vector.transform(documents).toarray()

doc_array

Para hacerlo fácil de entender, nuestro paso siguiente es convertir esta tabla en una estructura de datos y nombrar las columnas adecuadamente.

frequency_matrix = pd.DataFrame(data=doc_array, columns=names)

frequency_matrix

Con esto, hemos implementado con éxito un problema de “BoW” o Bag of Words para un conjunto de datos de documentos que hemos creado.

Un problema potencial que puede surgir al usar este método es el hecho de que si nuestro conjunto de datos de texto es extremadamente grande, habrá ciertos valores que son más comunes que otros simplemente debido a la estructura del propio idioma. Así, por ejemplo, palabras como ‘es’, ‘el’, ‘a’, pronombres, construcciones gramaticales, etc. podrían sesgar nuestra matriz y afectar nuestro análisis.

Para mitigar esto, usaremos el parámetro stop_words de la clase CountVectorizer y estableceremos su valor en inglés.

Dividiendo el Conjunto de Datos en Conjuntos de Entrenamiento y Pruebas

Buscamos dividir nuestros datos para que tengan la siguiente forma:

X_trainson nuestros datos de entrenamiento para la columna ‘sms_message’y_trainson nuestros datos de entrenamiento para la columna ‘label’X_testson nuestros datos de prueba para la columna ‘sms_message’y_testson nuestros datos de prueba para la columna ‘label’. Muestra el número de filas que tenemos en nuestros datos de entrenamiento y pruebas

# Dividir los datos en conjunto de entrenamiento y de test

from sklearn.model_selection import train_test_splitX_train, X_test, y_train, y_test = train_test_split(df['sms_message'], df['label'], random_state=1)print('Number of rows in the total set: {}'.format(df.shape[0]))print('Number of rows in the training set: {}'.format(X_train.shape[0]))print('Number of rows in the test set: {}'.format(X_test.shape[0]))

Aplicar BoW para Procesar Nuestros Datos de Pruebas